统计语言模型与N元文法在自然语言处理中的应用

"自然语言处理模型描述,包括统计语言建模、概率语法、N元文法和噪声通道模型,是自然语言处理课程的重要内容,适用于语音识别、机器翻译等多个领域。"

自然语言处理是一个复杂的领域,它涉及到人类语言的理解、生成和分析。随着大规模语料库的建设和统计方法的引入,自然语言处理模型得以显著提升,为研究语言的普遍规律和机器学习提供了新途径。统计语言模型(Statistical Language Model, SLM)是这一领域的核心概念,它尝试通过概率方法来捕捉语言的统计特性,从而改进各种自然语言处理应用的性能。

隐马尔科夫模型(HMM)是统计语言模型中的经典代表,最初在语音识别中取得了突破性进展。HMM通过概率模型描述观测序列与状态序列之间的关系,对于理解连续的语音信号尤其有效。此外,还有其他类型的概率语法模型,如n元文法(n-gram)、概率上下文无关文法(PCFG)和概率链接语法等,它们在不同的自然语言任务中各有优势。

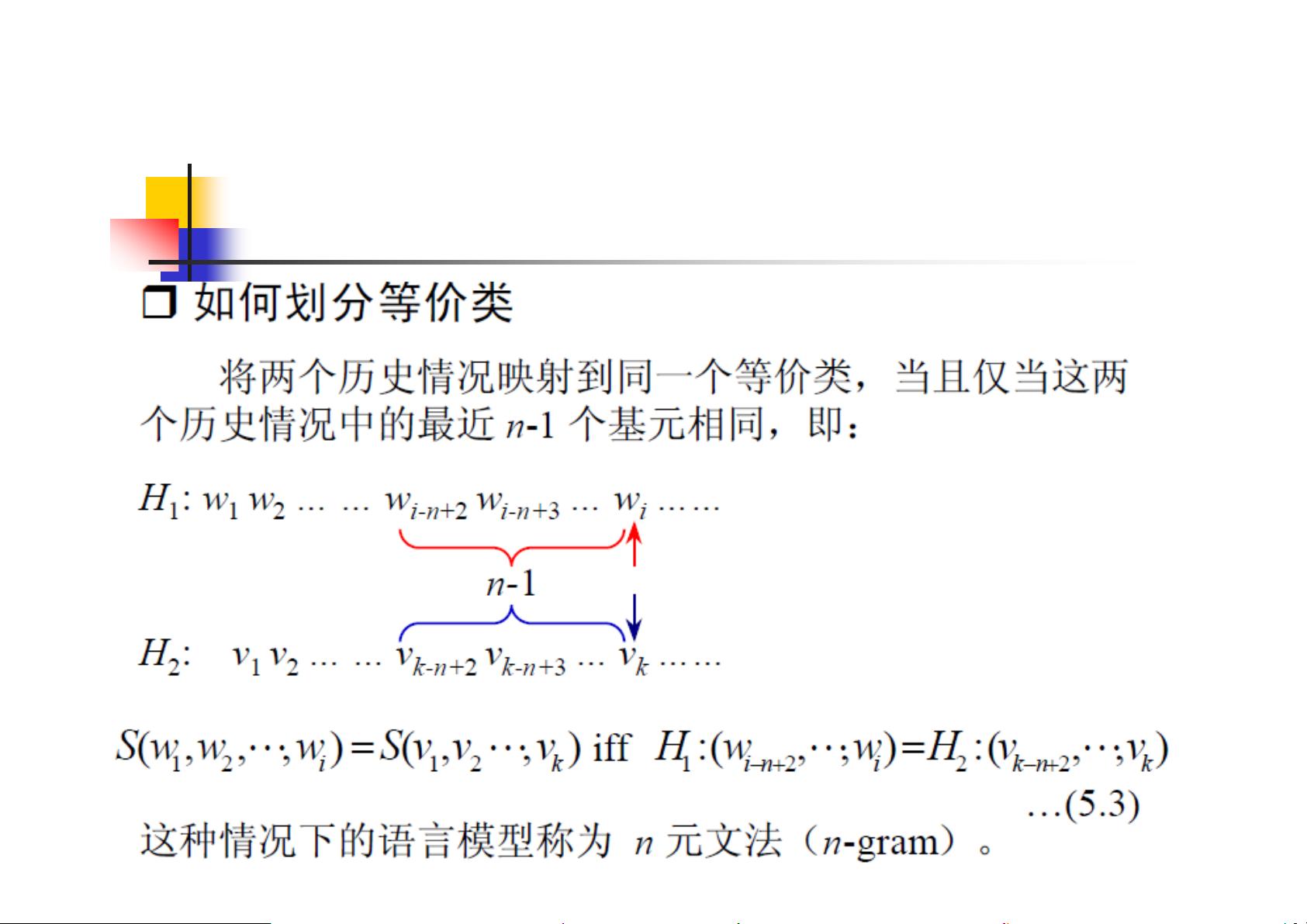

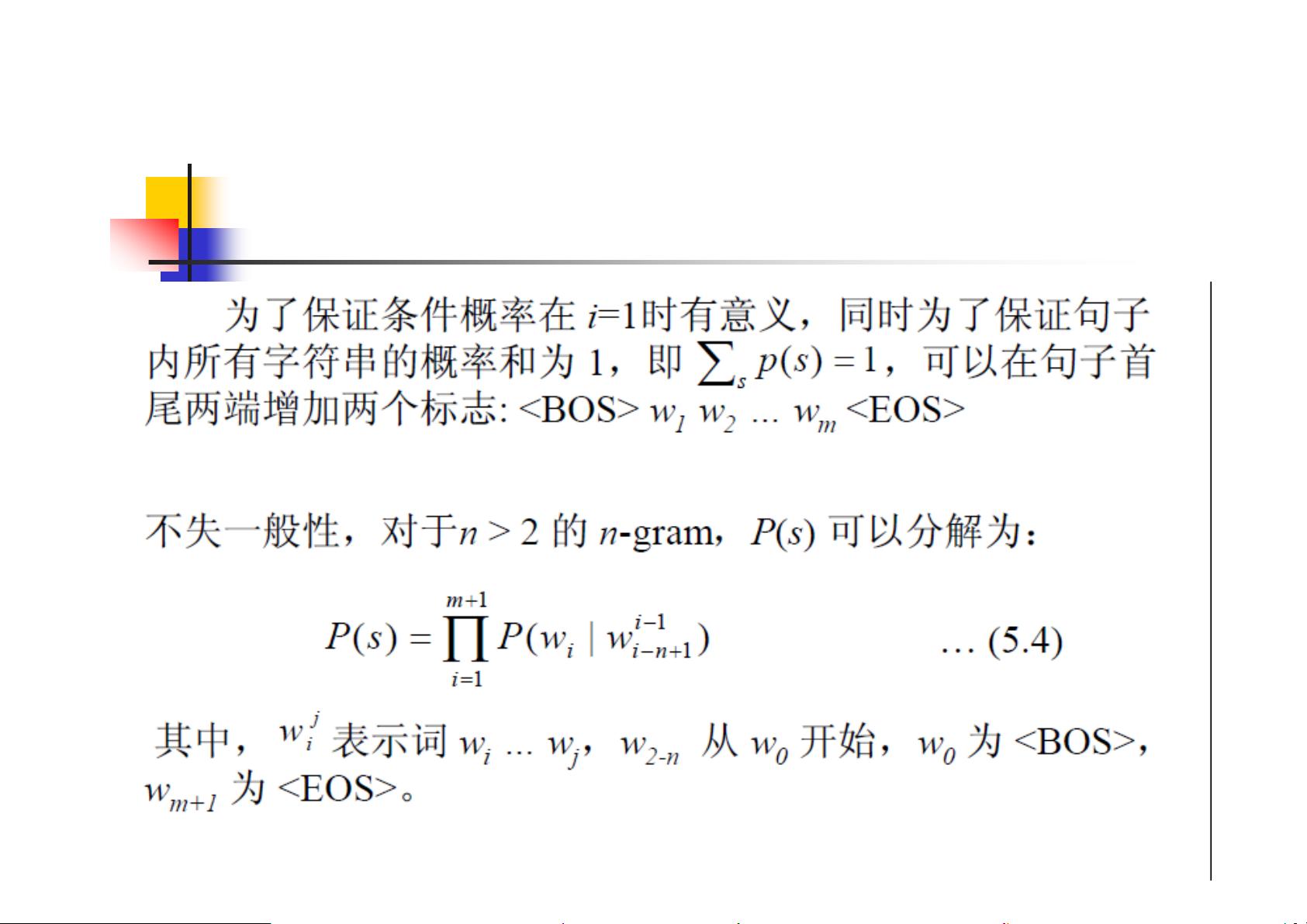

n元文法(n-gram)是SLM的一种形式,其中n-1阶马尔科夫假设用于预测下一个单词的概率。例如,一元文法(unigram)只考虑当前单词,二元文法(bigram)考虑前一个单词,而三元文法(trigram)则考虑前两个单词。尽管更高的n值可以提供更丰富的上下文信息,但随之而来的是参数估计的复杂性和数据需求的增加。在实践中,三元模型常常是平衡性能和计算资源的理想选择,而更大的n值可能导致过拟合或者训练数据不足的问题。

噪声通道模型在自然语言处理中也有其应用,尤其是在文本纠错和机器翻译中。它将输出视为由干净的语言信号通过一个噪声过程生成,这种模型可以帮助理解和纠正语言生成过程中的错误。

这些模型和方法在语音识别、手写体文字识别、机器翻译、键盘输入、信息检索等众多领域发挥着关键作用。通过学习和理解这些模型,开发者可以构建更准确、更适应实际应用场景的自然语言处理系统。然而,模型选择和参数优化需要根据具体任务和可用数据来决定,这需要对自然语言处理理论和技术有深入的理解。

323 浏览量

308 浏览量

243 浏览量

386 浏览量

2021-10-05 上传

649 浏览量

546 浏览量

108 浏览量

2021-10-05 上传

MELODY602904826

- 粉丝: 0

最新资源

- 全面详实的大学生电工实习报告汇总

- 利用极光推送实现App间的消息传递

- 基于JavaScript的节点天气网站开发教程

- 三星贴片机1+1SMT制程方案详细介绍

- PCA与SVM结合的机器学习分类方法

- 钱能版C++课后习题完整答案解析

- 拼音检索ListView:实现快速拼音排序功能

- 手机mp3音量提升神器:mp3Trim使用指南

- 《自动控制原理第二版》习题答案解析

- 广西移动数据库脚本文件详解

- 谭浩强C语言与C++教材PDF版下载

- 汽车电器及电子技术实验操作手册下载

- 2008通信定额概预算教程:快速入门指南

- 流行的表情打分评论特效:实现QQ风格互动

- 使用Winform实现GDI+图像处理与鼠标交互

- Python环境配置教程:安装Tkinter和TTk