sklearn入门:决策树详解与实战应用

需积分: 10 6 浏览量

更新于2024-07-16

收藏 3.37MB PDF 举报

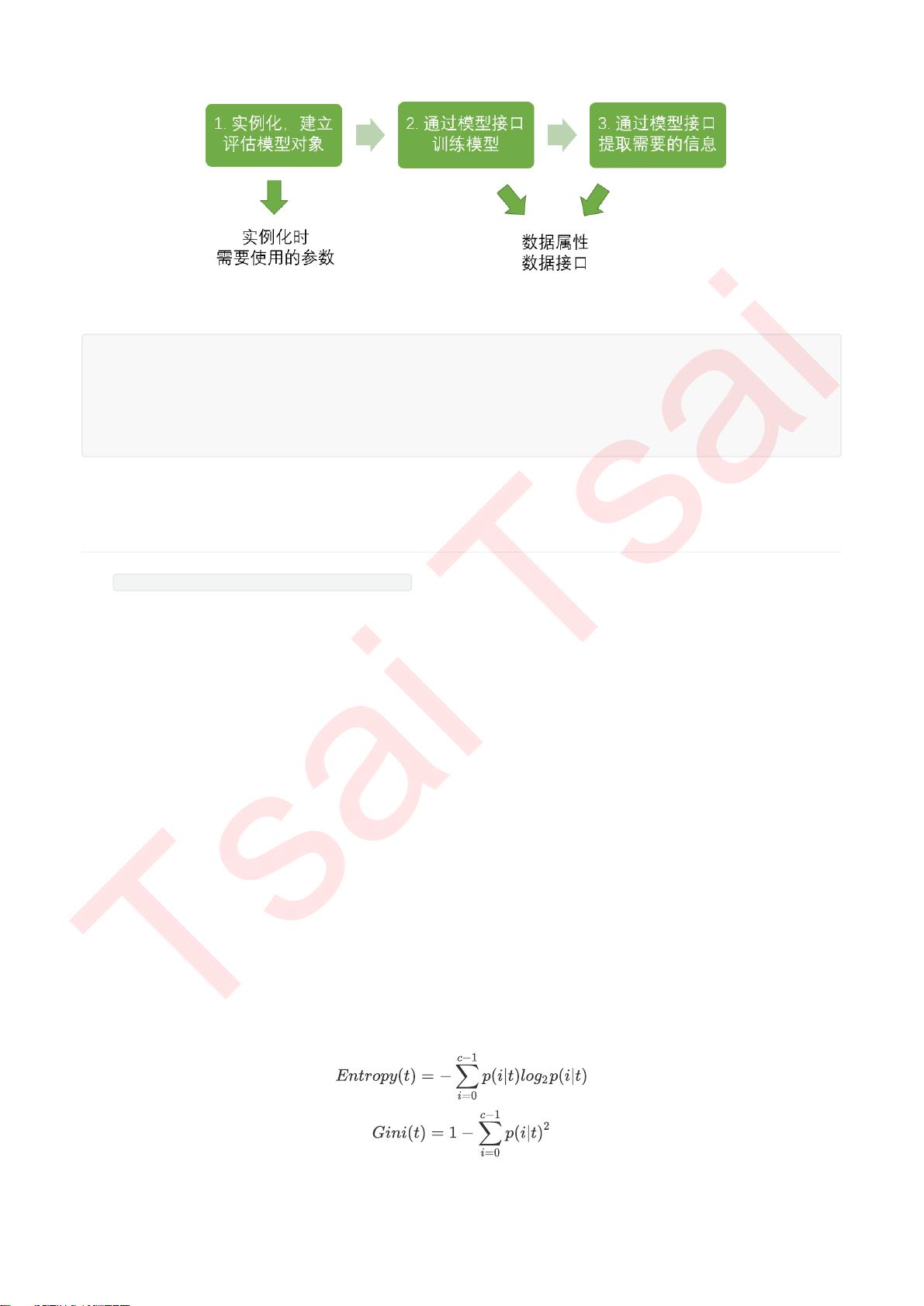

决策树是一种常用的数据挖掘和机器学习技术,用于解决分类和回归问题。在sklearn库中,决策树的实现提供了直观易懂的模型理解和可解释性。本资源介绍了sklearn中的DecisionTreeClassifier和DecisionTreeRegressor两个主要类,以及它们在实际项目中的应用。

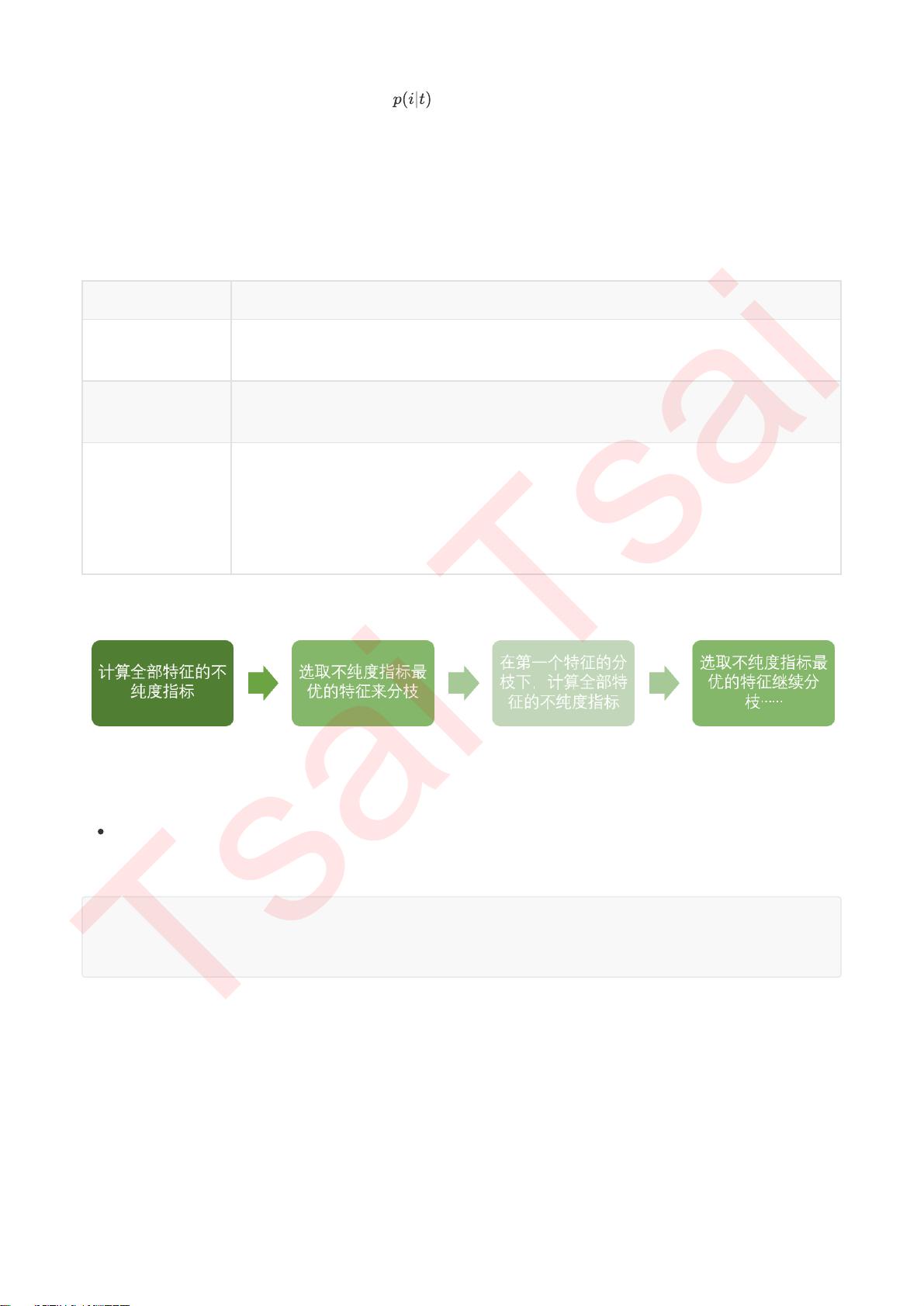

1. **工作原理**:

决策树通过一系列的提问(特征选择)来分割数据集,形成一个树状结构,每个内部节点代表一个特征,分支表示特征值的取向,叶子节点则对应最终的类别预测或数值预测。决策树根据训练数据集中的特征进行划分,以最大化信息增益或基尼不纯度等准则。

2. **sklearn中的关键组件**:

- **criterion**: 决策树的分裂准则,如'gini'(基尼不纯度)和'entropy'(信息熵),用于评估节点划分的质量。

- **random_state** 和 **splitter**: random_state用于设置随机种子,保证结果的可重复性;splitter指定如何处理缺失值,如'best'选择最优分割,'random'随机选择。

- **剪枝参数**:如max_depth、min_samples_split、min_samples_leaf等,用于控制决策树的复杂度,防止过拟合。

- **目标权重参数**:对于多类别问题,可以通过weight参数调整样本的重要性。

3. **应用示例**:

- 使用DecisionTreeClassifier处理红酒数据集,了解不同参数对模型性能的影响。

- 回归示例:一维回归问题中,如何通过sklearn构建决策树并可视化预测结果。

- 实战案例:利用决策树预测泰坦尼克号乘客的生存概率,展示模型在实际问题中的实用性。

4. **优缺点**:

- 优点:易于理解和解释,适合处理非线性关系和缺失数据;能够处理多类别问题。

- 缺点:容易过拟合,尤其是树的深度较大时;对异常值敏感,不稳定性较高。

5. **附录**:

- 提供了详细的分类树参数、属性和接口列表,便于进一步学习和调试。

- 还包括额外的章节,如使用决策树在合成数集上的表现,以及配置开发环境和sklearn库的安装指南。

这份资源是sklearn入门教程的一部分,涵盖了决策树的基本概念、关键参数和使用方法,以及在sklearn中的具体操作步骤和实战应用。通过学习,读者可以掌握如何构建、调参和评估决策树模型,以及在实际问题中的应用技巧。

1738 浏览量

4250 浏览量

393 浏览量

jetskyyyy

- 粉丝: 0

- 资源: 1

最新资源

- 火炬连体网络在MNIST的2D嵌入实现示例

- Angular插件增强Application Insights JavaScript SDK功能

- 实时三维重建:InfiniTAM的ros驱动应用

- Spring与Mybatis整合的配置与实践

- Vozy前端技术测试深入体验与模板参考

- React应用实现语音转文字功能介绍

- PHPMailer-6.6.4: PHP邮件收发类库的详细介绍

- Felineboard:为猫主人设计的交互式仪表板

- PGRFileManager:功能强大的开源Ajax文件管理器

- Pytest-Html定制测试报告与源代码封装教程

- Angular开发与部署指南:从创建到测试

- BASIC-BINARY-IPC系统:进程间通信的非阻塞接口

- LTK3D: Common Lisp中的基础3D图形实现

- Timer-Counter-Lister:官方源代码及更新发布

- Galaxia REST API:面向地球问题的解决方案

- Node.js模块:随机动物实例教程与源码解析