伪孪生BERT:解决'技术需求'与'技术成果'关联度计算难题

需积分: 0 100 浏览量

更新于2024-08-05

收藏 828KB PDF 举报

本篇论文主要关注于2019年CCF BDCI(中国计算机学会大数据与人工智能创新竞赛)中的一项任务,即“技术需求”与“技术成果”项目之间的关联度计算。研究者马凯欣,作为东北林业大学计算机技术专业的一年级研究生,利用BERT(Bidirectional Encoder Representations from Transformers,双向Transformer预训练模型)进行模型设计。

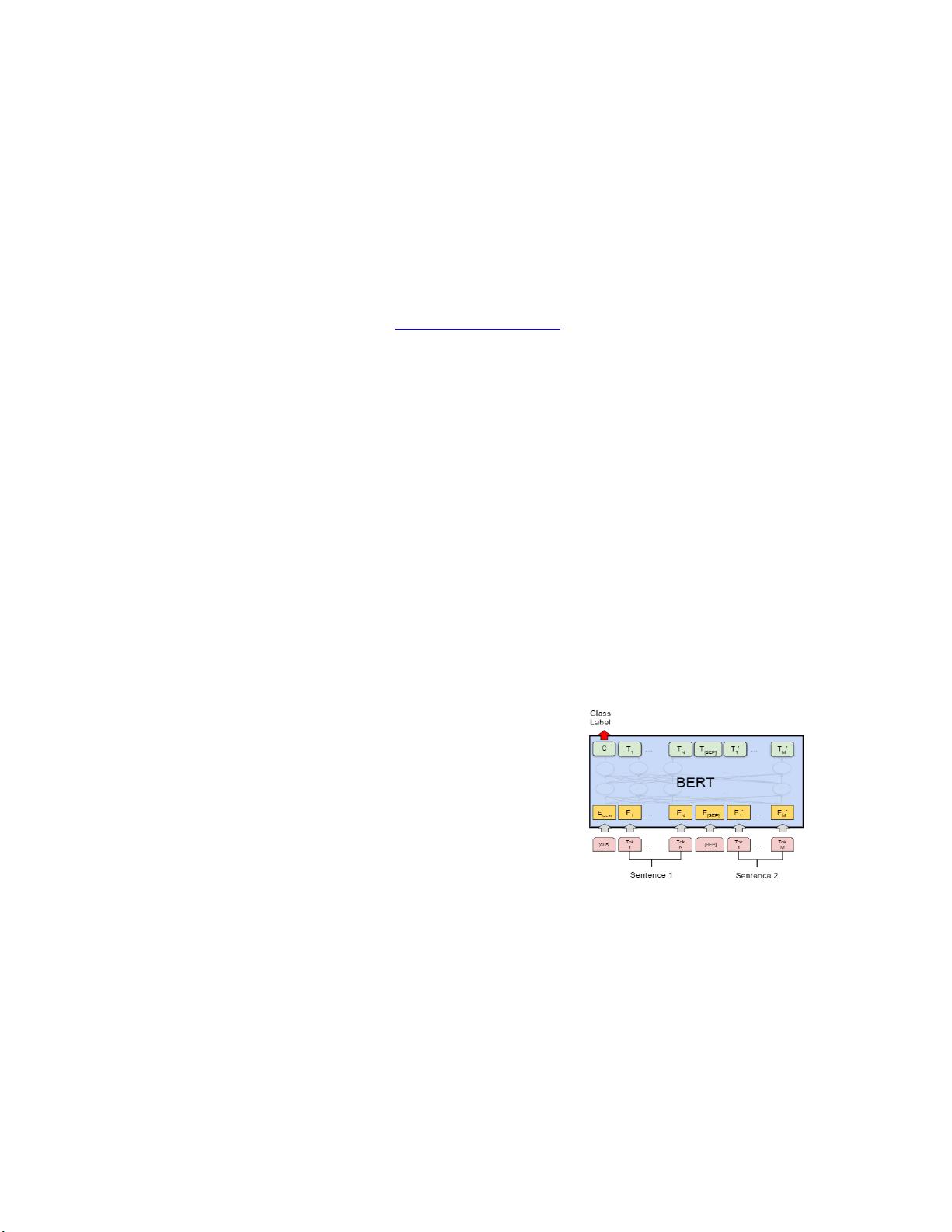

论文的核心内容是介绍了一种基于伪孪生网络结构的BERT微调模型。BERT在自然语言处理任务中表现出色,其预训练阶段通过添加特殊标记如[CLS]和[SEP],并采用WordPiece方法进行分词处理,同时引入段落嵌入和位置嵌入,以捕捉文本的上下文信息。作者尝试使用这种模型来解决项目间的关联度计算问题,但是遇到了过拟合的问题。尽管进行了简单的数据清洗,仅使用替换方法,但增加数据增强策略并未带来理想的结果,可能是因为模型复杂性与有限的数据集之间存在冲突。

作者试图通过一种偏好处理方法来减少预测误差,但论文中没有详述这种方法的具体实现细节。实验结果显示,伪孪生BERT在处理这项任务时相较于标准BERT微调模型表现更优,这表明引入伪孪生网络结构有助于提高模型的泛化能力和关联度计算的准确性。

论文的关键点包括文本关联度的计算、伪孪生网络结构的设计以及BERT预训练的优势。然而,由于时间限制,关于数据增强的进一步探索并未深入展开。这篇论文提供了一个初步的尝试,为后续研究者在这个领域提供了可能的方向,即如何优化BERT模型以更好地适应特定任务,尤其是在处理自然语言推理和项目关联度分析这类任务时。

2024-06-03 上传

2022-08-08 上传

2021-04-15 上传

2021-03-24 上传

2021-03-14 上传

2024-04-14 上传

2021-04-14 上传

2021-05-16 上传

2021-02-03 上传

丛乐

- 粉丝: 38

- 资源: 312

最新资源

- 构建基于Django和Stripe的SaaS应用教程

- Symfony2框架打造的RESTful问答系统icare-server

- 蓝桥杯Python试题解析与答案题库

- Go语言实现NWA到WAV文件格式转换工具

- 基于Django的医患管理系统应用

- Jenkins工作流插件开发指南:支持Workflow Python模块

- Java红酒网站项目源码解析与系统开源介绍

- Underworld Exporter资产定义文件详解

- Java版Crash Bandicoot资源库:逆向工程与源码分享

- Spring Boot Starter 自动IP计数功能实现指南

- 我的世界牛顿物理学模组深入解析

- STM32单片机工程创建详解与模板应用

- GDG堪萨斯城代码实验室:离子与火力基地示例应用

- Android Capstone项目:实现Potlatch服务器与OAuth2.0认证

- Cbit类:简化计算封装与异步任务处理

- Java8兼容的FullContact API Java客户端库介绍