深度学习与算法结合:图表示学习的推理新进展

需积分: 10 121 浏览量

更新于2024-07-16

1

收藏 6.08MB PDF 举报

"图表示学习算法推理是DeepMind的研究科学家Petar Veličković在WWW 2020图深度学习研讨会(DL4G)上所作的报告,探讨了神经图算法推理的最新研究,包括GNN基准、泛化能力、多任务学习以及算法发现。该报告共有46页,旨在结合神经网络和算法的优势,解决结构化数据的表示学习问题。"

图深度学习是当前计算机科学中的一个热门领域,它专注于在图数据上应用深度学习技术。图数据结构能够有效地表示各种复杂关系,如社交网络、生物信息学网络或知识图谱。Petar Veličković的报告中,他对比了传统问题解决方法,如神经网络和算法,来阐述它们各自的优点和局限性。

神经网络在处理原始输入、应对噪声环境时具有良好的泛化能力,并且模型可以在不同任务之间复用。然而,它们需要大量数据进行训练,且在数据外推时可能不可靠,同时缺乏可解释性。另一方面,算法通常具有简单而强烈的泛化能力,可以分解为可复用的子程序,保证正确性,并且操作具有可解释性。但它们对输入规范性要求严格,对任务变化不具鲁棒性。

报告提出的关键问题在于,是否有可能将这两种方法的优点结合起来,创造出既具备强大的泛化能力和数据效率,又具有算法的解析性和可靠性。这正是图表示学习算法推理所追求的目标,通过图神经网络(GNNs)来实现。

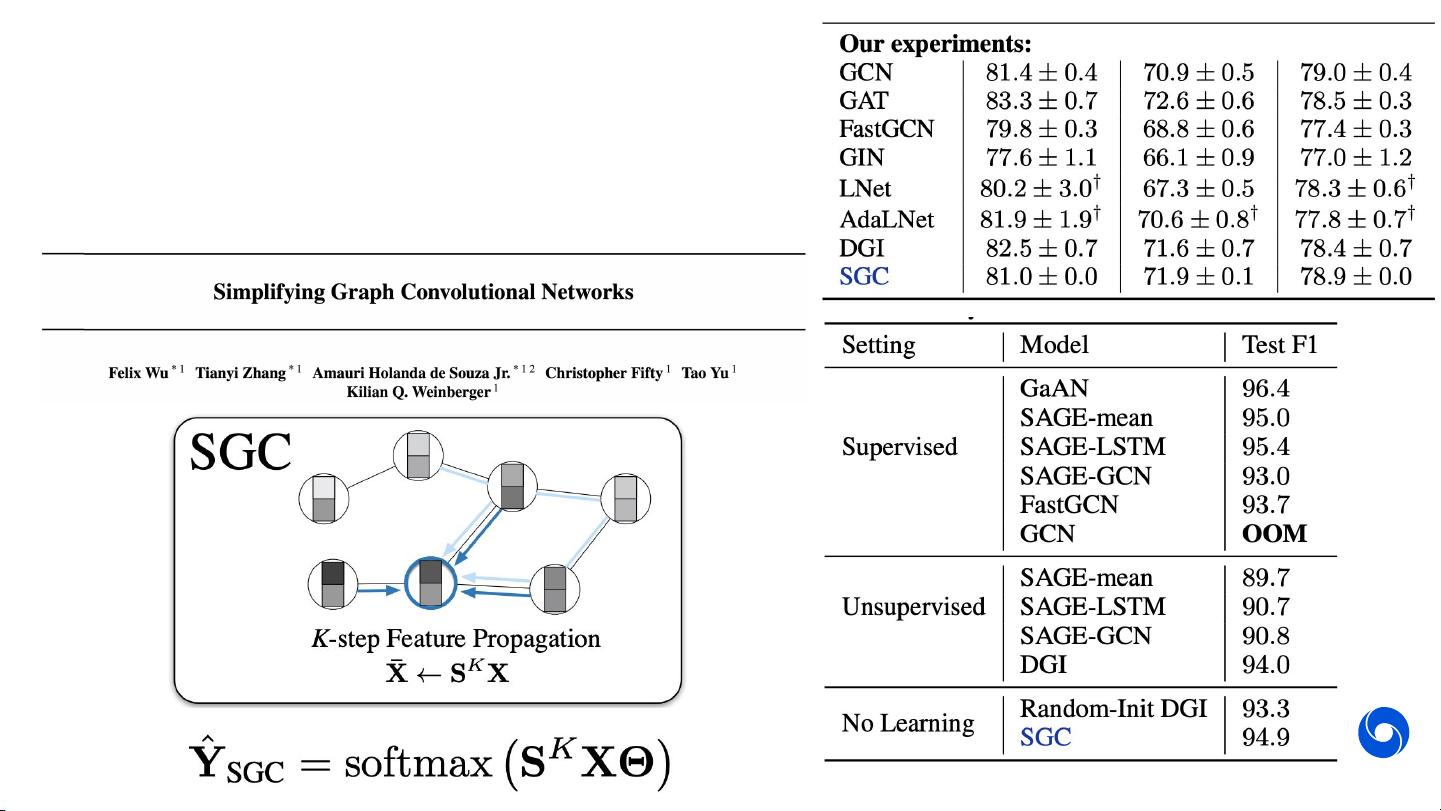

GNN是一种深度学习模型,能够学习图节点和边的表示,通过不断的信息传播和聚合过程理解图的结构。在GNN基准方面,报告可能涵盖了各种GNN变体的性能比较和评估标准,这些变体可能包括GCN、GAT、GIN等。此外,报告可能讨论了如何通过GNN进行多任务学习,以提高模型的泛化性能,以及如何在无监督或半监督的环境中学习有效的图表示。

在算法发现部分,报告可能探讨了如何利用GNNs来自动学习或发现新的算法,这可能涉及到强化学习或元学习的方法,以探索图上的操作序列,从而解决特定问题。

图表示学习算法推理是深度学习与传统算法的交叉研究,旨在构建更智能、更适应复杂任务的系统,同时保持理解和可解释性。这样的研究对于推动人工智能的发展,特别是在需要理解并处理复杂关系的数据集上的应用,具有重要的理论和实践意义。

2020-04-17 上传

2019-09-07 上传

2023-08-12 上传

点击了解资源详情

142 浏览量

2023-08-24 上传

2010-04-27 上传

2022-05-27 上传

syp_net

- 粉丝: 158

- 资源: 1187

最新资源

- 掌握Jive for Android SDK:示例应用的使用指南

- Python中的贝叶斯建模与概率编程指南

- 自动化NBA球员统计分析与电子邮件报告工具

- 下载安卓购物经理带源代码完整项目

- 图片压缩包中的内容解密

- C++基础教程视频-数据类型与运算符详解

- 探索Java中的曼德布罗图形绘制

- VTK9.3.0 64位SDK包发布,图像处理开发利器

- 自导向运载平台的行业设计方案解读

- 自定义 Datadog 代理检查:Python 实现与应用

- 基于Python实现的商品推荐系统源码与项目说明

- PMing繁体版字体下载,设计师必备素材

- 软件工程餐厅项目存储库:Java语言实践

- 康佳LED55R6000U电视机固件升级指南

- Sublime Text状态栏插件:ShowOpenFiles功能详解

- 一站式部署thinksns社交系统,小白轻松上手