自然语言处理中的数据增强技术:复述、噪声与抽样

需积分: 5 38 浏览量

更新于2024-07-09

收藏 2.24MB PDF 举报

"哈工大发表的《自然语言处理数据增强方法》综述论文,155页,详细探讨了复述、噪声和抽样三大数据增强策略在NLP领域的应用和挑战。"

在自然语言处理(NLP)领域,数据增强已经成为提升模型性能和泛化能力的关键技术。这篇由Bohan Li, Yutai Hou和Wanxiang Che共同撰写的综述论文,全面阐述了如何利用数据增强来应对数据稀缺问题。论文首先定义了数据增强的基本概念,即通过现有数据合成新数据,以提升模型的鲁棒性和泛化性能。

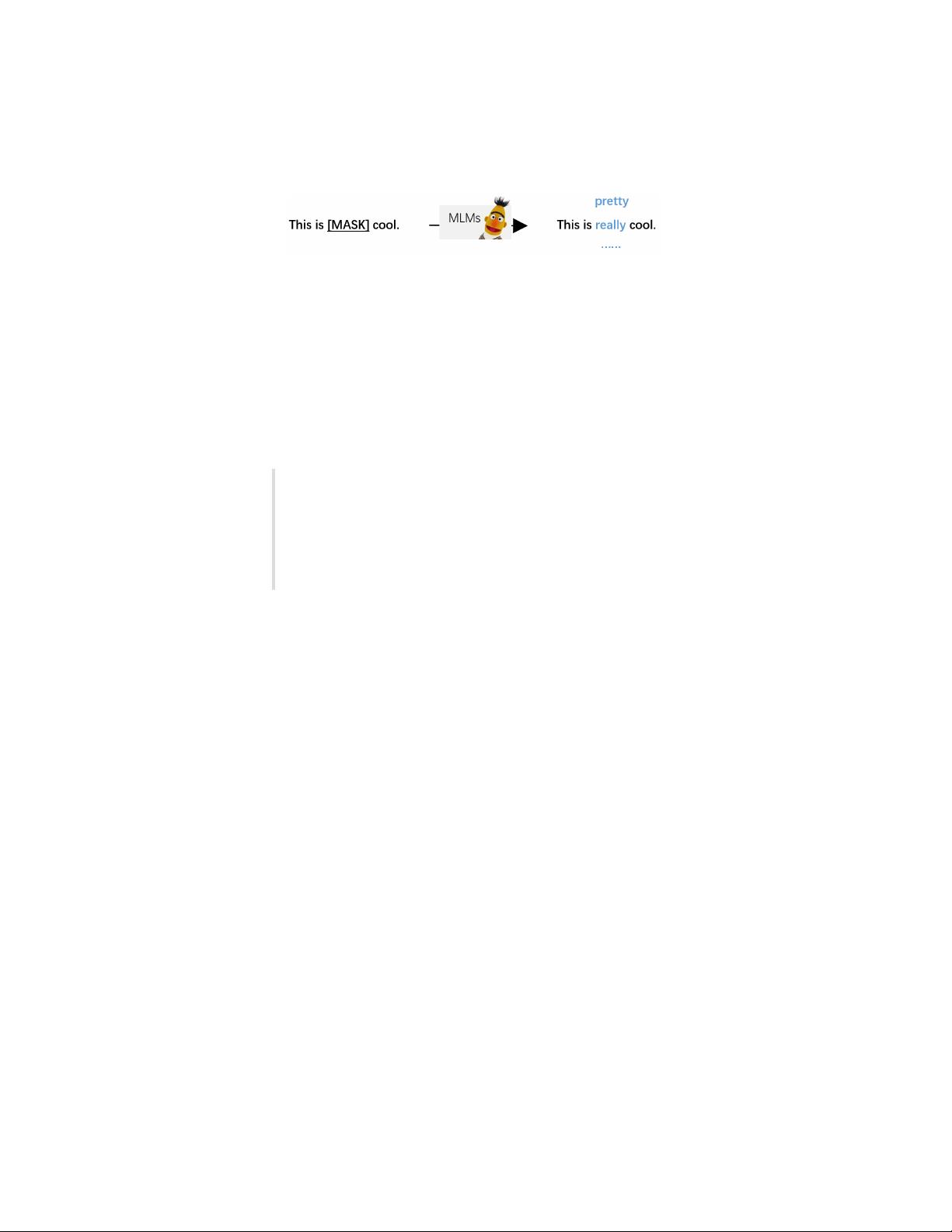

一、复述(Paraphrasing)

复述是通过对句子的词汇、短语或结构进行改写,同时保持原文的语义。这种方法旨在创造语法正确且意义不变的新句子,增加了训练数据的多样性。复述可以通过同义词替换、句法重排、语义保留的翻译等多种方式实现。例如,使用预训练的语义模型进行文本生成,或者运用规则和模板来构造新句子。

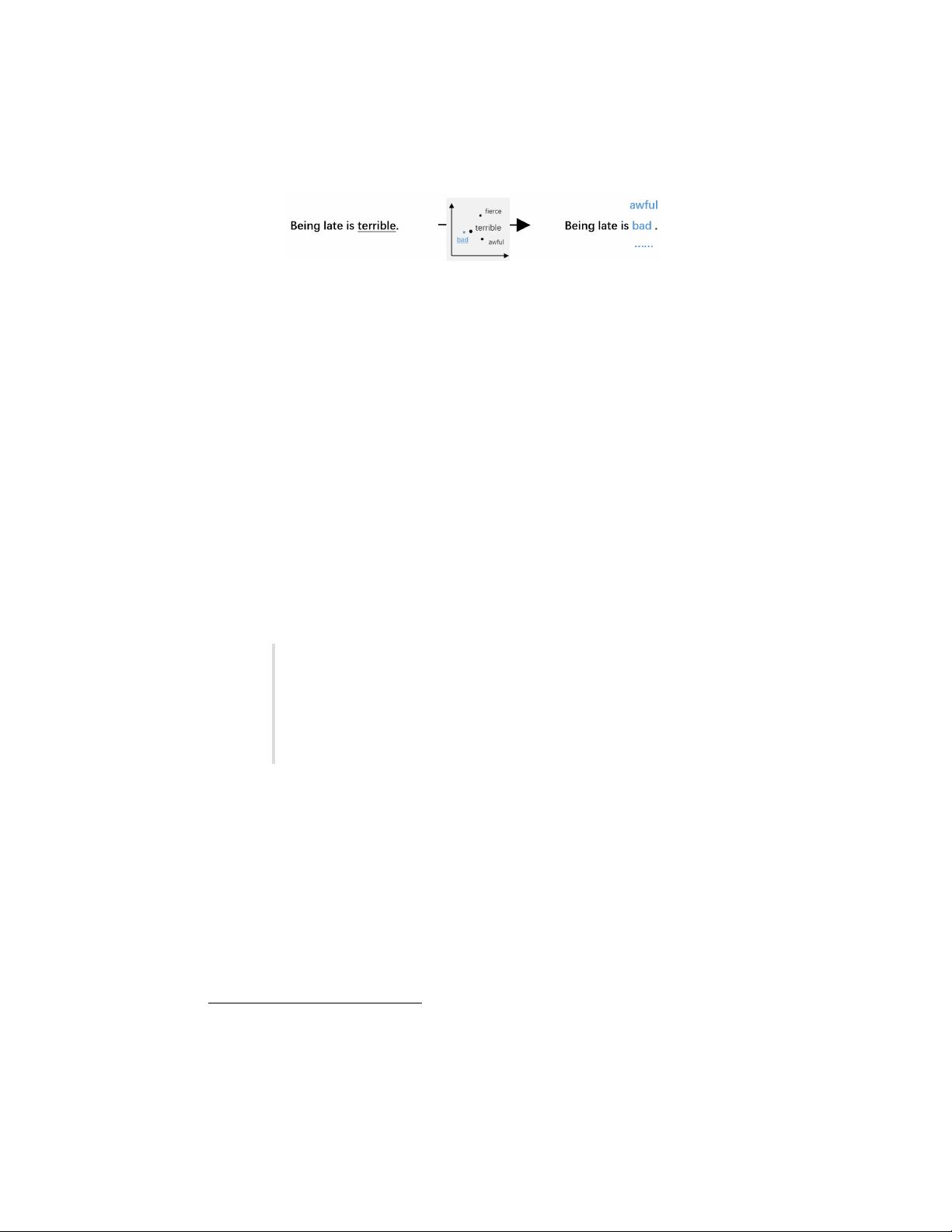

二、噪声(Noising)

噪声注入是在保持标签不变的情况下,向输入数据添加离散或连续的干扰。这些干扰可能包括拼写错误、词汇替换、插入或删除随机字符等,其目的是模拟真实世界中的噪声环境,让模型在处理不完美数据时更具适应性。不过,添加噪声需要谨慎,以避免对语义造成过大影响。

三、抽样(Sampling)

抽样方法则是根据现有数据分布生成新的样本,目标是增加数据的多样性和覆盖范围。这可以是基于概率的采样,如在文本生成中使用自回归模型,或者在对话系统中模拟用户行为。抽样策略需要确保新生成的样本既具有代表性,又不与原始数据过于相似,以促进模型学习更广泛的模式。

论文进一步分析了这些方法在各种NLP任务中的应用,如情感分析、机器翻译、问答系统和对话生成等,并讨论了数据增强面临的挑战。这些挑战包括如何保持语义一致性、避免过度拟合、处理长文本和结构化数据,以及评估增强数据的有效性。

关键词:数据增强、自然语言处理

2010MSC分类:00-01, 99-00

通讯作者邮箱:bhli@ir.hit.edu.cn (Bohan Li), ythou@ir.hit.edu.cn (Yutai Hou), car@ir.hit.edu.cn (Wanxiang Che)

这篇预印本论文已提交至《Journal of L》出版,为NLP研究者和从业者提供了关于数据增强的深入理解和实践指导。

1983 浏览量

202 浏览量

205 浏览量

179 浏览量

146 浏览量

297 浏览量

YOLOv8 and Natural Language Processing Integration: A Study on Image and Text Information Fusion ...

点击了解资源详情

点击了解资源详情

点击了解资源详情

努力+努力=幸运

- 粉丝: 17

- 资源: 136