优化深度网络性能的梯度下降算法及其Python实现

需积分: 0 104 浏览量

更新于2024-01-02

收藏 1.99MB PDF 举报

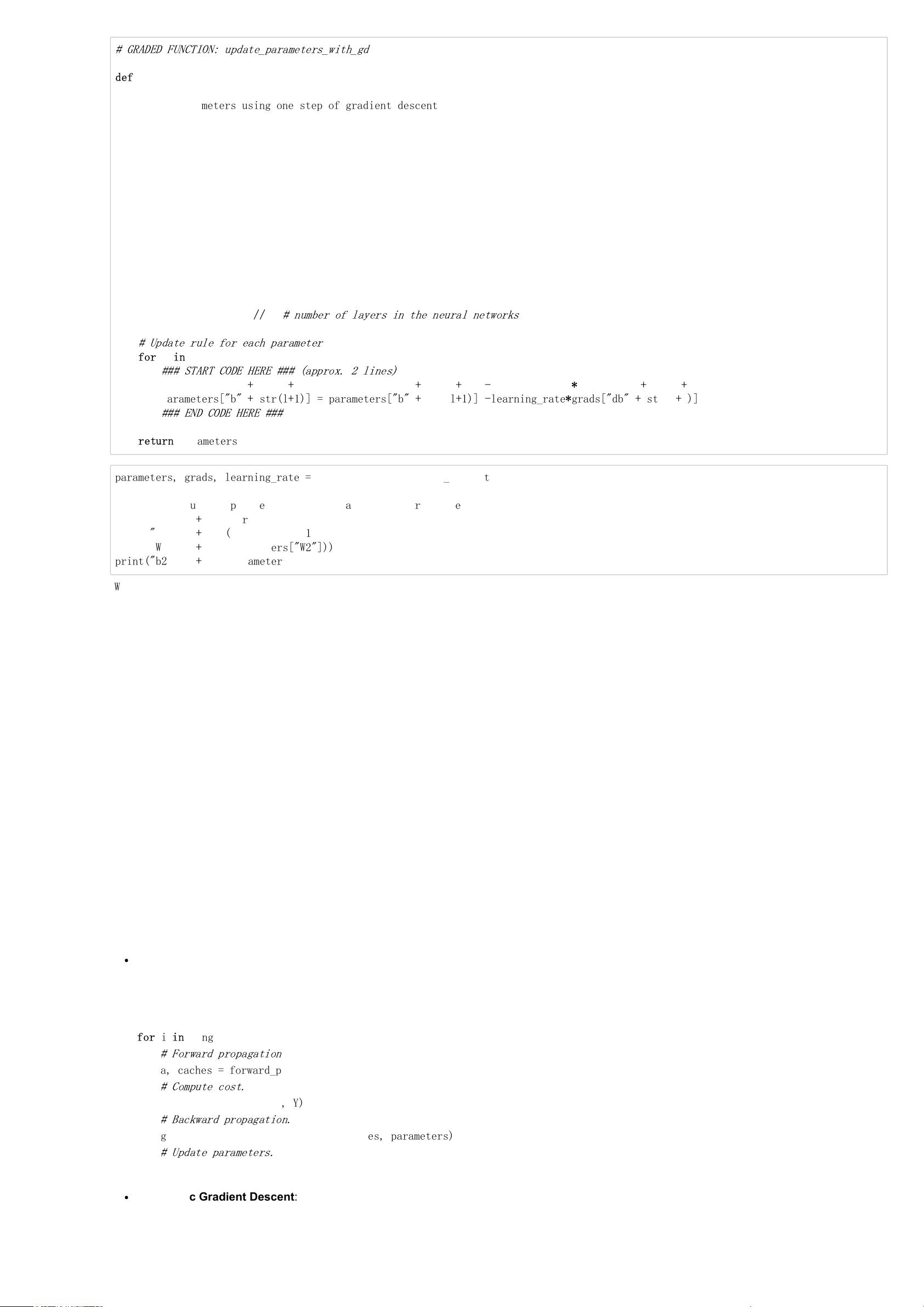

本文主要讨论了深度学习中的优化算法,旨在提高深度网络的性能。优化算法在深度学习中的反向传播过程中起着重要的作用,通过找到最优的参数(如W、b),使得代价函数(cost function)最小化,来提高深度网络的精度和速度。

首先介绍了梯度下降算法的几种变体。其中,批量梯度下降(Batch Gradient Descent)是指在寻找最优参数W和b的过程中,使用全部的训练样本计算梯度,并以此调整参数。它的优点是每次更新都能朝着最优方向前进,但缺点是计算量大,训练速度慢。

其次介绍了随机梯度下降(Stochastic Gradient Descent),它与批量梯度下降相反,只使用一个样本来计算梯度和调整参数。虽然训练速度快,但由于噪声的存在,很容易陷入局部最优解。

接下来介绍了动量梯度下降(Momentum Gradient Descent),它在随机梯度下降的基础上引入了动量项。动量项考虑了历史梯度的加权平均,使得参数更新更加稳定,避免了在平坦区域受到的震荡。

然后介绍了RMSprop算法,它通过计算梯度的移动平均值来调整学习率。这样可以减少学习率的抖动,提高收敛速度。

接下来介绍了学习率衰减(Learning Rate Decay),它是一种让学习率随着时间逐渐减小的方法。在训练初期使用较大的学习率可以加速收敛,而在训练后期使用较小的学习率可以更细致地搜索最优解。

最后介绍了Adam算法,它结合了动量梯度下降和RMSprop算法的优点,既能快速收敛,又能适应不同参数的学习率变化。

在文章的附录部分,作者给出了每个优化算法的原理解释和公式推导,并提供了Python代码的实现框架,可以在Github上查阅详细数据和代码。作者表示本文的原理解释部分由LSayhi完成,供学习参考和传播,代码实现部分的框架由Coursera提供,由LSayhi完成。

总之,本文综述了深度学习中常用的优化算法,包括梯度下降、批量梯度下降、随机梯度下降、动量梯度下降、RMSprop、学习率衰减和Adam算法。这些优化算法在提高深度网络性能方面起着重要作用,能够大大提高整个团队的效率和训练速度。通过仔细选择和调整合适的优化算法,可以使得深度网络更好地收敛,提高精度和速度,从而推动深度学习的发展和应用。

199 浏览量

246 浏览量

6311 浏览量

170 浏览量

138 浏览量

1091 浏览量

161 浏览量

434 浏览量

AshleyK

- 粉丝: 27

最新资源

- 基于HTML构建简易人员管理系统实现增删改查功能

- 360漏洞修复网管版:集中管理与批量更新

- Lokimo-crx: 扩展程序带来房地产市场新视角

- 仁霸门窗设计软件v3.1更新发布,操作更优化

- 探索啤酒API在C#应用开发中的作用

- rcssserver最新版本15.2.2发布

- Redis有序集合(SortedSet)实战演示与代码实践

- CopterControl 3D组件清单压缩文件解读

- Java Swing中JTabbedPane增强功能的实现教程

- 理解CVE的重要性与应用

- VC9运行库:32位与64位系统安装指南

- Android断点续传:Eclipse环境下的下载恢复技术

- 微信小程序地图标注功能:位置信息一目了然

- 平面转三维视效:探索30张立体图片的奇妙

- node-wkhtmltopdf-cli: 构建前端PDF文档的CLI工具

- SpringBoot项目中多数据源与分布式事务整合实践