"深度学习中的正则化策略及影响"

需积分: 0 20 浏览量

更新于2024-01-04

收藏 1.96MB PDF 举报

正则化常用于缓解模型过拟合的问题。过拟合发生的原因是模型的容量过大,即模型有很多自由度来适应训练数据的噪声,但却不一定能够在新数据上表现良好。为了解决这个问题,正则化可以对模型施加某些限制,从而降低模型的有效容量。

目前有多种正则化策略可供选择。其中一些策略是向模型添加额外的约束,如增加对参数的限制。这可以是对参数范数、稀疏性或其他形式的约束。这种约束是对参数的硬约束,通过限制参数的取值范围来降低模型的复杂度。

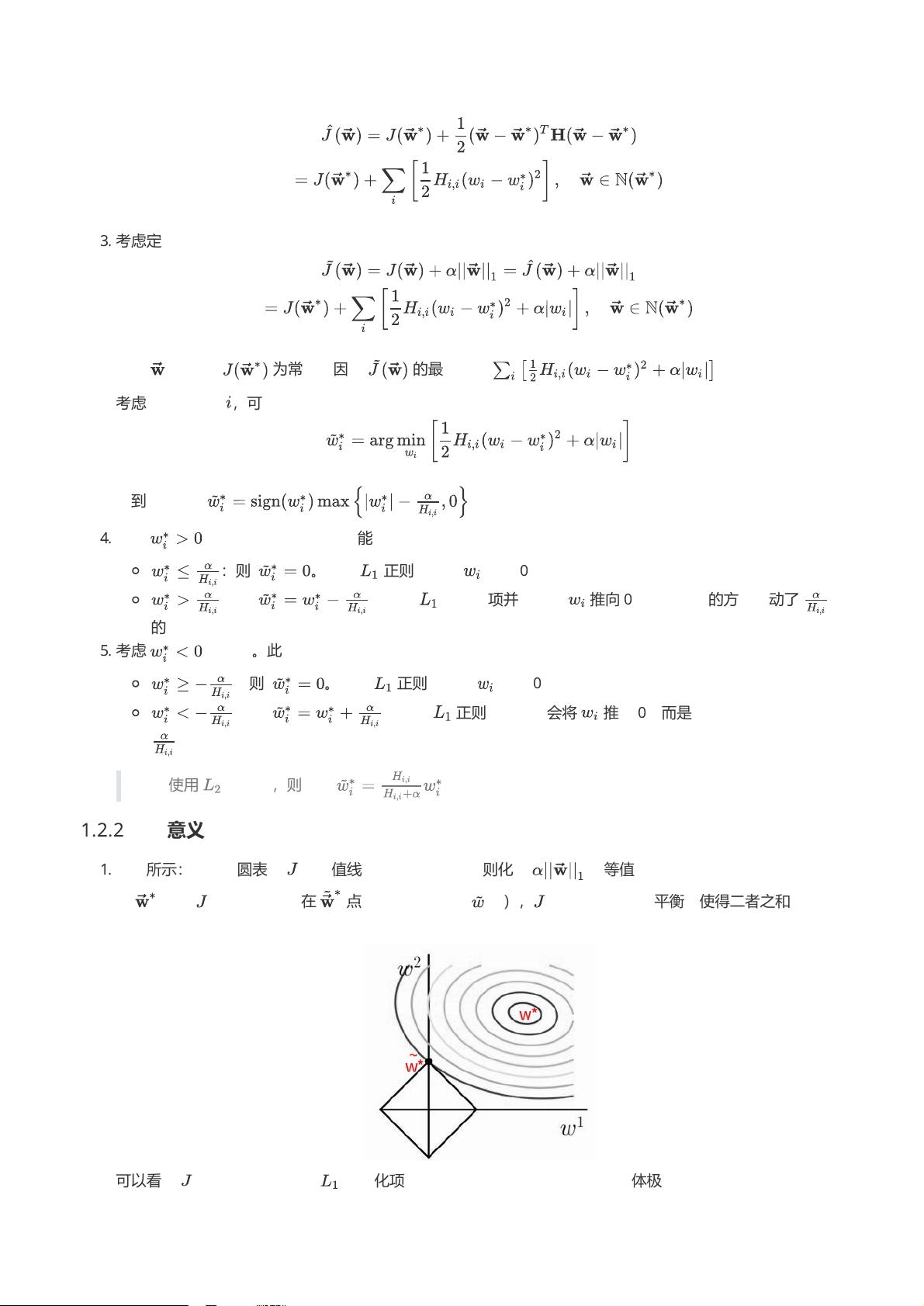

另一些正则化策略是向目标函数添加额外的项,即正则化项。这个项衡量了模型的复杂度,并通过在优化过程中平衡正则化项和标准目标函数的比重来实现对参数的软约束。常见的正则化项包括L1正则化、L2正则化和弹性网络等。

正则化策略代表了某种先验知识,即我们倾向于选择简单的模型。简单的模型更容易泛化到新数据,而复杂的模型则更容易过拟合。例如,在线性回归中,如果我们已经知道目标函数是一条直线,那么使用一个高次多项式模型就是过于复杂的。因此,我们可以使用L1正则化来倾向于选择直线模型。

在深度学习中,大多数正则化策略都是基于对模型参数进行正则化。正则化通过在优化过程中对参数的增加偏差来换取对方差的减少,从而减少模型的过拟合。一个有效的正则化可以显著降低模型的方差,并且不会过度增加偏差。

在实际应用中,当面临过拟合问题时,不要因害怕过拟合而采用一个小模型。相反,建议采用一个大模型,并使用正则化来控制其复杂度。大模型可以提供更好的表达能力,而正则化可以帮助避免过拟合,从而在训练数据和新数据上都能取得较好的性能。

总而言之,正则化是一种重要的技术,用于控制模型的复杂度、降低过拟合的风险,并提高模型在新数据上的泛化能力。目前有多种正则化策略可供选择,它们代表了某种先验知识,并通过对模型参数的限制来实现对模型的正则化。在深度学习的实际应用中,我们应该选择一个大模型,并使用适当的正则化策略来提高模型的性能。

2022-08-08 上传

2022-08-03 上传

1290 浏览量

2023-06-08 上传

900 浏览量

946 浏览量

154 浏览量

169 浏览量

张匡龙

- 粉丝: 25

最新资源

- 深入探究PHP框架Massimo2的特性与应用

- EhLib 6.3.184:面向多种Delphi版本的组件库更新

- 幼儿智力游戏系统开发与编程参考

- Oracle考题精讲与实战解析

- 快速提升开发技能:struts+hibernate论坛源码解析

- Lazy-uiautomatorviewer: 提升安卓自动化测试效率的工具

- Linux命令大全:详尽解说及实例,CHM格式查阅

- 微控制器驱动的CheckPM微尘测量管理服务

- 探索AmazingsWPFControls:炫丽UI的开源新秀

- Oracle基础入门课程:详尽内容与丰富试题

- C++实现图像变形效果:膨胀、扭曲与涟漪

- 3D屏保:全球排名第一的无病毒保护程序

- STM32开发HMI串口屏幕教程详解

- 煤矿安全实时监控系统的设计与实现

- WAP2.0开发教程:ASP源码解析与实践指南

- 《俺爹俺娘》纪录片非时空再现分析