浙大研究:集成学习Boosting算法详解与应用

版权申诉

84 浏览量

更新于2024-09-03

收藏 2.97MB PDF 举报

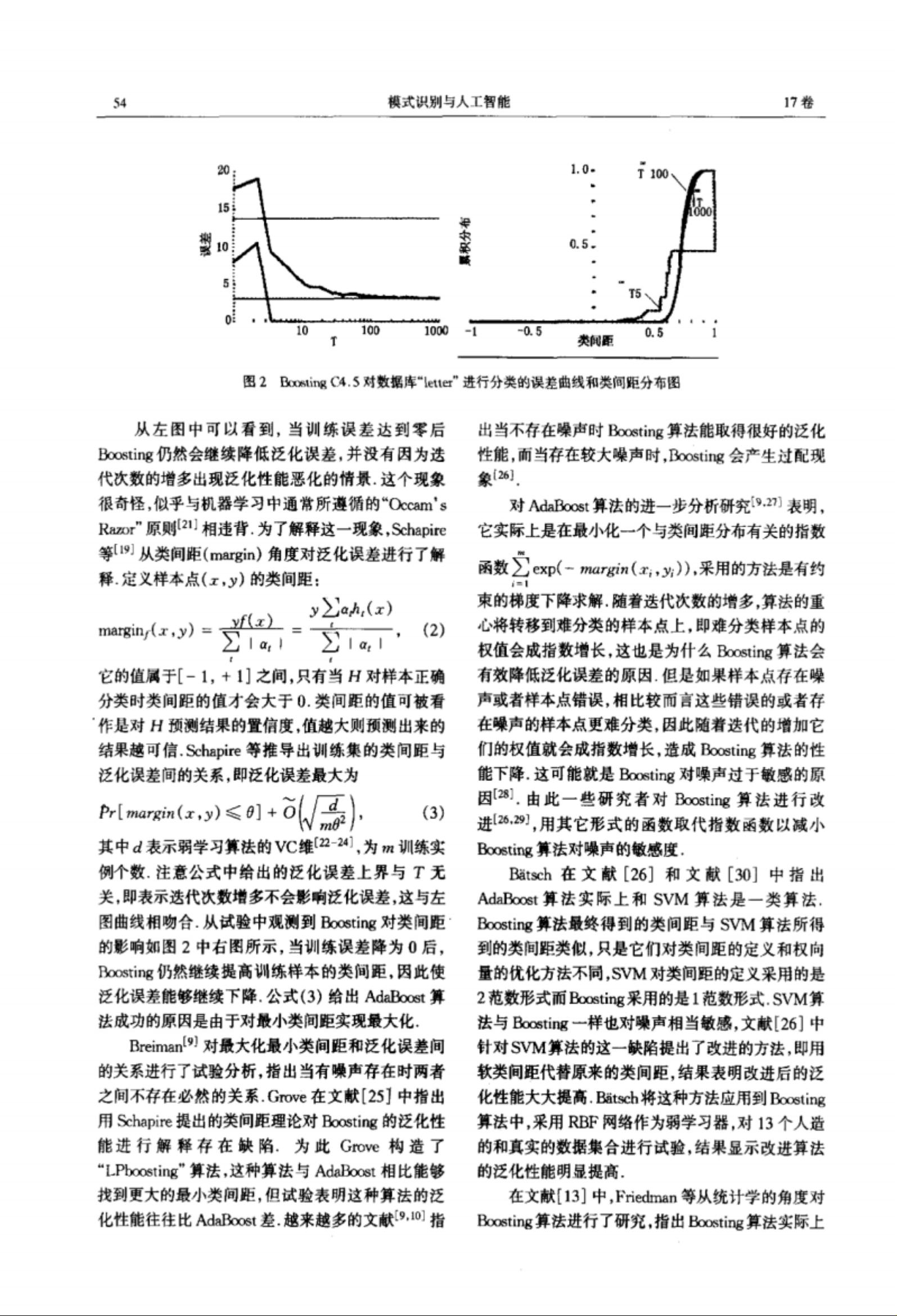

集成学习是一种强大的机器学习方法,它通过结合多个弱学习器(weak learners)形成一个强学习器(strong learner),从而提高预测性能和泛化能力。在本文《集成学习:Boosting算法综述》中,作者于玲和吴铁军,来自浙江大学智能系统与决策研究所,对Boosting算法进行了深入的探讨。Boosting算法起源于Leo Grady Valiant在1984年的理论工作,他提出了可学习性理论,这是一种理解机器学习问题难度的关键概念。

Shapire和Freund在90年代的工作尤为关键,他们展示了弱学习的概念,以及如何通过迭代提升(如AdaBoost)来解决复杂的学习问题。AdaBoost算法(1995年)由Yoav Freund提出,它通过调整样本权重,优先训练那些先前被错误分类的样本,逐步优化模型。Drucker等人在1993年的研究中展示了Boosting如何提升神经网络的性能,而 Freund和Schapire在1997年的论文中,不仅介绍了在线学习的决策理论应用,还提出了信心度量的改进Boosting算法。

文章特别提到了Leo Breiman的"Arcing the Edge"报告,展示了Boosting在C4.5决策树等工具中的应用,并指出Bagging(随机森林)和Boosting是两种互补的集成学习策略。Quinlan在1996年的论文中对比了这两种方法,强调了它们各自的优点。

此外,文中还引用了多项研究,这些研究都围绕Boosting的不同变体、其理论基础、实践应用和性能改进展开。通过阅读这篇综述,读者可以深入了解Boosting算法的工作原理、发展历史、关键算法以及在实际问题中的有效性。该文章作为2004年《模式识别与人工智能》期刊上的发表,已被引用18次,证明了其在学术界的重要地位。

这篇综述是理解和掌握Boosting算法不可或缺的资源,对于研究者、工程师和机器学习实践者来说,它提供了一个全面且深入的框架,帮助他们探索和利用Boosting算法的潜力。

2021-11-10 上传

2022-03-19 上传

2021-09-24 上传

2020-12-27 上传

2021-07-14 上传

2021-09-24 上传

2021-09-24 上传

2021-07-14 上传

2021-08-28 上传

霖落^0^时空

- 粉丝: 3

- 资源: 9万+

最新资源

- 高清艺术文字图标资源,PNG和ICO格式免费下载

- mui框架HTML5应用界面组件使用示例教程

- Vue.js开发利器:chrome-vue-devtools插件解析

- 掌握ElectronBrowserJS:打造跨平台电子应用

- 前端导师教程:构建与部署社交证明页面

- Java多线程与线程安全在断点续传中的实现

- 免Root一键卸载安卓预装应用教程

- 易语言实现高级表格滚动条完美控制技巧

- 超声波测距尺的源码实现

- 数据可视化与交互:构建易用的数据界面

- 实现Discourse外聘回复自动标记的简易插件

- 链表的头插法与尾插法实现及长度计算

- Playwright与Typescript及Mocha集成:自动化UI测试实践指南

- 128x128像素线性工具图标下载集合

- 易语言安装包程序增强版:智能导入与重复库过滤

- 利用AJAX与Spotify API在Google地图中探索世界音乐排行榜