探索信息技术:KNN、SVM与贝叶斯分类算法详解

需积分: 46 44 浏览量

更新于2024-07-18

3

收藏 619KB PPTX 举报

分类算法合集是机器学习领域的重要组成部分,它包含了多种方法,用于根据输入数据的特征将其归类到预定义的类别中。本文将重点介绍几种常见的分类算法:

1. **K近邻(K-Nearest Neighbor, KNN)**: KNN是最基础的机器学习算法之一。它的核心思想是基于样本之间的相似性进行分类,通过查找待分类样本的K个最近邻居,并依据邻居的类别归属来决定样本的类别。然而,当样本分布不均衡时,可能会导致误判,可通过调整权重来解决。KNN算法的计算量相对较大,因为它涉及全量样本比较。

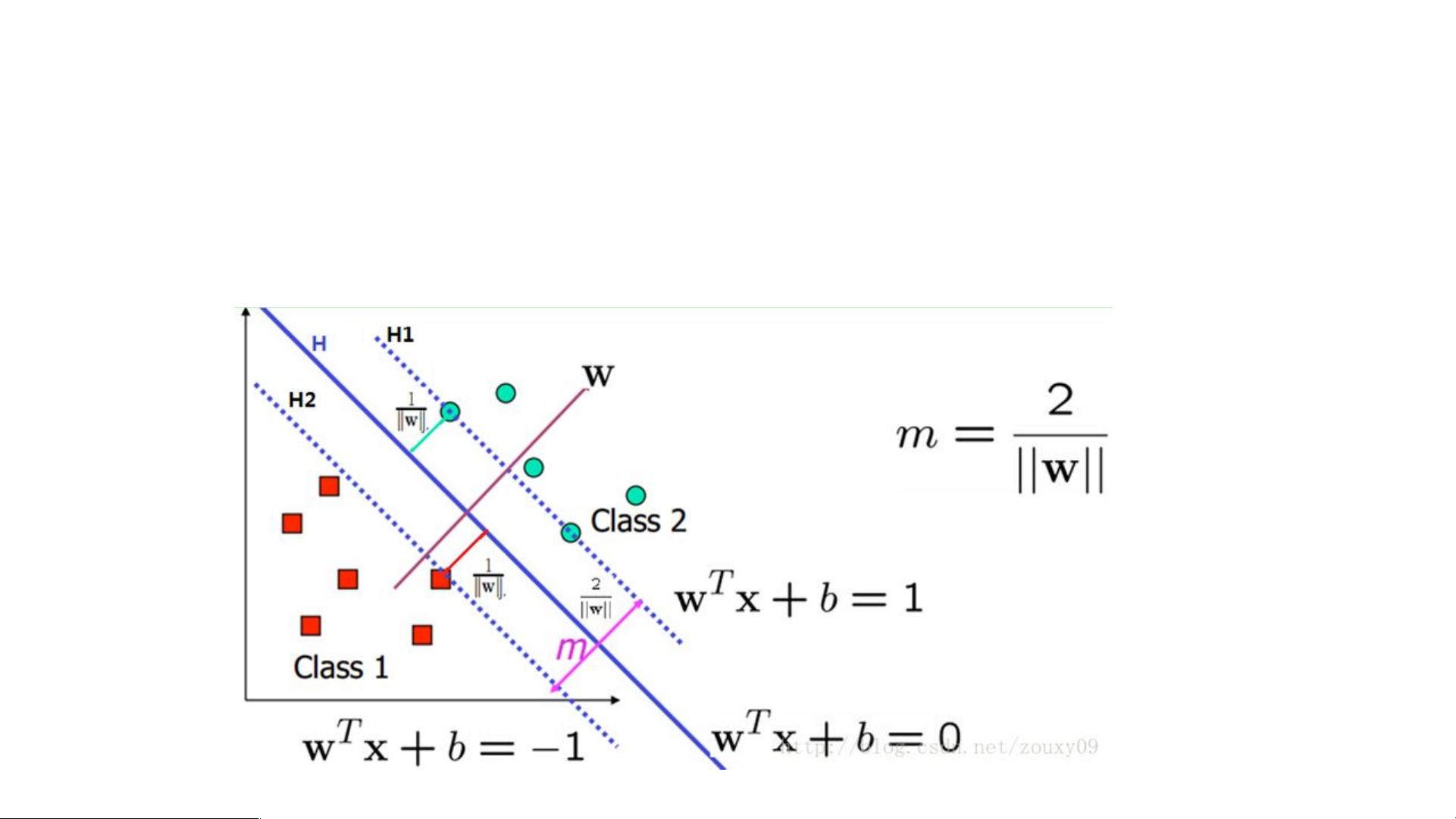

2. **支持向量机(Support Vector Machine, SVM)**: SVM是一种强大的二分类模型,其目标是找到一个能最大化类别间间隔(称为“间隔最大化”或“硬间隔”)的超平面。对于线性可分数据,SVM能构建清晰的决策边界。对于非线性问题,SVM可以通过核函数(如多项式、径向基函数等)将数据映射到高维空间,使得数据变得线性可分。在实践中,存在软间隔(允许少数样本错误)的概念,这引入了松弛变量,使得模型更具鲁棒性。

3. **SVM的优化与决策边界**:

- SVM通过凸二次规划求解最优的分类面,确保最大化间隔。对于线性不可分的情况,使用核函数可以找到非线性的决策边界。

- 当数据集中存在outlier(异常点)时,SVM需要考虑软间隔,即允许部分样本在决策边界附近,以避免因个别异常值影响整个模型的性能。

4. **决策边界与间隔调整**: SVM的决策边界由支持向量决定,这些是离决策边界的点,它们决定了分类的精度和模型的泛化能力。当数据集中有远离决策边界的outlier时,允许一定的“软间隔”可以帮助模型更好地适应噪声和复杂性。

总结来说,分类算法合集包括KNN的简单直观,SVM的间隔最大化和优化策略,以及对异常情况的处理方法。理解并掌握这些算法及其优缺点,是机器学习实践者必备的技能。在实际应用中,选择合适的分类算法取决于问题的特性、数据的分布和所需的性能。

2024-06-21 上传

2014-11-10 上传

2018-08-27 上传

2015-12-25 上传

2022-11-14 上传

SaulZhang

- 粉丝: 117

- 资源: 19

最新资源

- Raspberry Pi OpenCL驱动程序安装与QEMU仿真指南

- Apache RocketMQ Go客户端:全面支持与消息处理功能

- WStage平台:无线传感器网络阶段数据交互技术

- 基于Java SpringBoot和微信小程序的ssm智能仓储系统开发

- CorrectMe项目:自动更正与建议API的开发与应用

- IdeaBiz请求处理程序JAVA:自动化API调用与令牌管理

- 墨西哥面包店研讨会:介绍关键业绩指标(KPI)与评估标准

- 2014年Android音乐播放器源码学习分享

- CleverRecyclerView扩展库:滑动效果与特性增强

- 利用Python和SURF特征识别斑点猫图像

- Wurpr开源PHP MySQL包装器:安全易用且高效

- Scratch少儿编程:Kanon妹系闹钟音效素材包

- 食品分享社交应用的开发教程与功能介绍

- Cookies by lfj.io: 浏览数据智能管理与同步工具

- 掌握SSH框架与SpringMVC Hibernate集成教程

- C语言实现FFT算法及互相关性能优化指南