解决Hadoop集群磁盘利用率不均衡问题

版权申诉

91 浏览量

更新于2024-09-10

收藏 486KB PDF 举报

"Hadoop集群datanode磁盘不均衡的解决方案"

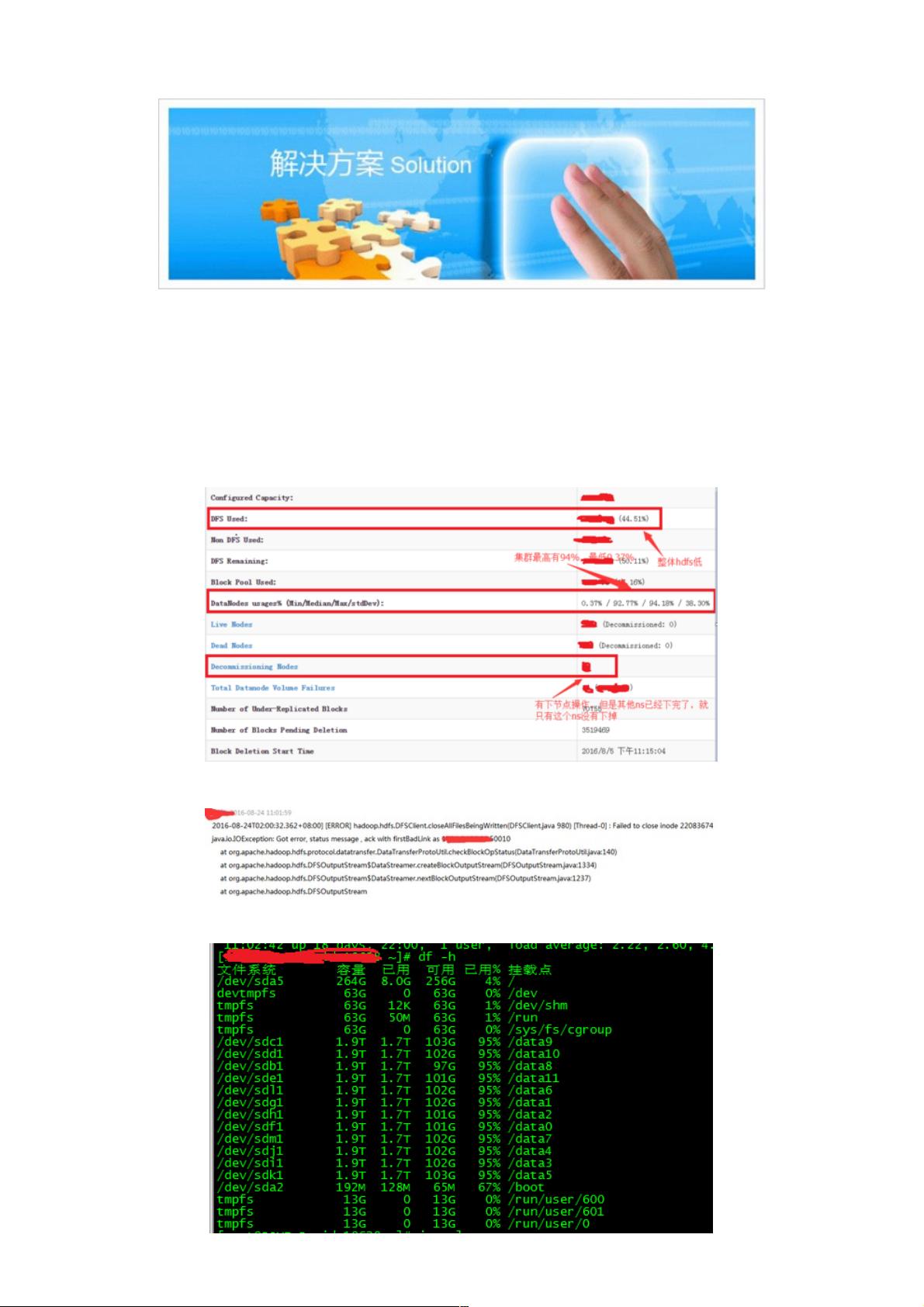

在Hadoop的分布式文件系统(HDFS)集群中,磁盘利用率不均衡是一个常见的问题,尤其在新增或移除DataNode节点时,不同节点的磁盘空间利用率可能会相差巨大。这可能导致MapReduce程序无法充分利用本地计算资源,网络带宽得不到有效利用,甚至导致某些节点的磁盘空间过满,从而影响整个集群的稳定性和性能。

问题的核心在于,当磁盘利用率差距过大,某些节点接近满载,而其他节点则有大量空闲空间时,NameNode在调度数据块复制时可能无法做出最优决策,导致数据访问效率下降,甚至引发错误。例如,MapReduce任务可能会在磁盘已满的节点上运行,从而导致任务失败。

例如,描述中提到的情况是,集群中有600多台DataNode的磁盘利用率高达94.18%,而有的只有0.37%。这种不均衡状态不仅影响了MapReduce作业的执行,还可能由于`dfs.datanode.du.reserved`配置设置,使得即使磁盘看似还有空间,但实际可用空间已经非常有限。这个配置项用于保留一部分磁盘空间供非HDFS使用,当磁盘空间达到预留值时,DataNode将不再接受新的数据,从而可能导致错误。

为了解决这个问题,通常可以采取以下几种策略:

1. **Balancer工具**:

Hadoop自带的Balancer工具旨在平衡集群内的数据分布,通过从空间充足的节点移动数据到空间不足的节点,使得所有DataNode的存储利用率保持在一个合理的范围内。然而,Balancer在执行时会占用大量网络带宽,因此需要在低峰时段进行,并且需要谨慎调整其阈值,以避免不必要的数据迁移。

2. **手动调整数据**:

可以通过手动的方式,如移动或删除部分文件,来调整各节点的负载。这种方法需要精确的规划和执行,可能不适合大规模集群。

3. **动态调整Block Replication策略**:

修改NameNode的默认策略,使其更倾向于将新数据块分配给磁盘空间充裕的节点,同时减少在满载节点上的复制操作。

4. **监控与预警**:

建立完善的监控系统,实时跟踪各节点的磁盘利用率,一旦发现不均衡情况,及时采取措施。

5. **容量规划**:

在集群设计阶段,尽可能保证每个节点的磁盘容量一致,或者在添加新节点时,根据当前集群的使用情况进行合理扩容。

6. **定期维护**:

定期进行集群平衡检查和维护,确保磁盘空间的持续均衡。

7. **优化配置参数**:

调整`dfs.datanode.balance.bandwidthPerSec`等参数,控制Balancer的数据传输速度,以适应不同的网络环境。

通过以上方法,可以有效地解决Hadoop集群中DataNode磁盘利用率不均衡的问题,确保集群的高效稳定运行。然而,每种策略都有其适用场景和限制,应结合实际情况选择合适的方法。同时,良好的集群管理和监控体系也是预防和解决这类问题的关键。

2018-11-15 上传

2015-12-04 上传

2023-03-17 上传

2023-06-06 上传

2023-04-04 上传

2023-10-09 上传

2023-08-07 上传

2023-04-29 上传

2023-06-08 上传

weixin_38665162

- 粉丝: 1

- 资源: 927

最新资源

- C++标准程序库:权威指南

- Java解惑:奇数判断误区与改进方法

- C++编程必读:20种设计模式详解与实战

- LM3S8962微控制器数据手册

- 51单片机C语言实战教程:从入门到精通

- Spring3.0权威指南:JavaEE6实战

- Win32多线程程序设计详解

- Lucene2.9.1开发全攻略:从环境配置到索引创建

- 内存虚拟硬盘技术:提升电脑速度的秘密武器

- Java操作数据库:保存与显示图片到数据库及页面

- ISO14001:2004环境管理体系要求详解

- ShopExV4.8二次开发详解

- 企业形象与产品推广一站式网站建设技术方案揭秘

- Shopex二次开发:触发器与控制器重定向技术详解

- FPGA开发实战指南:创新设计与进阶技巧

- ShopExV4.8二次开发入门:解决升级问题与功能扩展