深度解析:过拟合、欠拟合对策与梯度问题,RNN进阶技术

167 浏览量

更新于2024-07-14

收藏 695KB PDF 举报

本资源主要探讨了在深度学习中的三个关键主题:过拟合与欠拟合的解决策略、梯度消失与梯度爆炸问题,以及循环神经网络的进阶理解。

1. **过拟合与欠拟合及其解决方案**

- 过拟合与欠拟合是机器学习中的关键概念。过拟合是指模型在训练数据上表现得非常好,但在未见过的数据上表现差,因为它过度适应了噪声。欠拟合则是模型无法捕捉数据的主要特征,导致在训练集和测试集上的误差都较高。

- 解决方法包括:

- **训练误差与泛化误差**:区分这两者,目标是降低泛化误差而非仅优化训练误差,因为后者容易受到噪声影响。

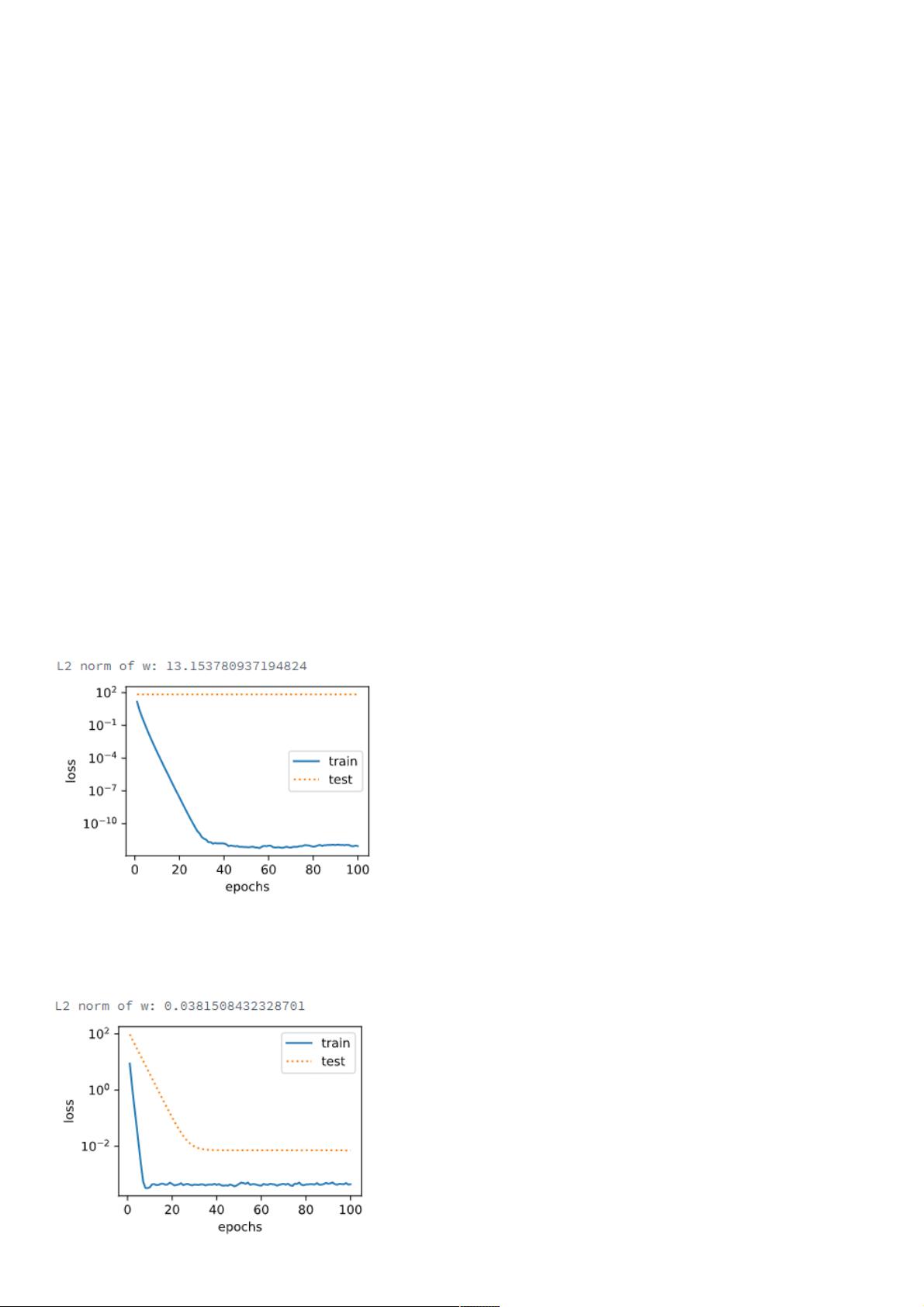

- **权重衰减(正则化)**:通过在损失函数中添加模型参数的L1或L2范数,限制参数过大,防止过拟合。

- **丢弃法(Dropout)**:在训练过程中随机忽略一部分神经元,强制模型学习更鲁棒的表示,减少对特定输入的依赖。

2. **梯度消失与梯度爆炸**

- 梯度消失/爆炸是深度神经网络中常见的问题,特别是在激活函数(如sigmoid或tanh)可能导致梯度接近于0或无穷大的情况下。

- 解决措施包括:

- **随机初始化模型参数**:适当的初始化有助于梯度流动,避免陷入局部极小值。

- **考虑环境因素**:选择合适的激活函数,如ReLU,它解决了梯度消失问题;同时,使用归一化技术如Batch Normalization也有助于稳定梯度。

3. **循环神经网络进阶**

- 本部分深入探讨了三种常见的循环神经网络结构:

- **门控循环单元(GRU)**:结合了简单和复杂门控机制,减少了 LSTM 的复杂性,提高了训练速度。

- **长短期记忆(LSTM)**:通过门控机制(输入门、遗忘门和输出门)处理长期依赖,有效解决了传统RNN的梯度消失问题。

- **深度循环神经网络**:增加网络深度,增强模型的表达能力,但需注意防止过拟合。

- **双向循环神经网络**:前馈和反馈信息相结合,提升对序列数据的理解。

本资源提供了关于深度学习中常见问题的深入解析,强调了理论背后的实践应用,特别是如何有效地管理过拟合、优化梯度流程以及选择和使用不同的循环神经网络结构。

相关推荐

weixin_38575536

- 粉丝: 3

最新资源

- Java抽奖系统后台高并发解决方案

- 深入分析KCF视觉跟踪算法的源码实现

- Script Expert V7.23脚本编程软件发布

- 易语言实现城市经纬度数据高效压缩工具

- webrtc 回声消除模块在 android 平台的移植

- 串口编程源代码完整分享,章节详解

- STC89C52图库文件Protel99se缺失解决方案

- 快速有效的bin转txt文件转换工具

- 探索ApexJxc云峰多用户网络进销存系统

- Flex技术实现DataGrid到Excel的数据导出

- 掌握易语言实现圆形进度条的绘制方法

- VideoView简单示例:SD卡mp4文件全屏横屏播放

- jQueryPad: 最佳jQuery学习辅助工具

- 纪念日数显电路的设计与实现

- Java课程设计:学生信息管理系统实现与答辩体会

- webp-imageio: Java图像格式处理库的使用与编译指南