最大化边距:SVM理论与Python实现详解

版权申诉

42 浏览量

更新于2024-06-29

收藏 2.24MB PDF 举报

支持向量机(Support Vector Machine, SVM) 是一种经典的监督学习算法,尤其在深度学习兴起之前,它在机器学习领域占有重要地位。SVM的核心理念是通过构建决策边界(超平面),最大化数据点到该超平面的间隔(margin),以此来提升模型的泛化能力和预测精度。在面临非线性可分问题时,SVM可以通过核函数将数据映射到高维空间,使得线性不可分的问题在高维空间中变得线性可分。

在Python中实现SVM时,通常使用Scikit-learn库,它提供了丰富的接口和多种核函数选项。首先,理解SVM的优化问题是关键,目标是同时最小化错误分类的代价(误分类点)和最大化间隔,即找到离分类器最近的数据点(支持向量)。这个优化问题可以转化为求解双优化问题:

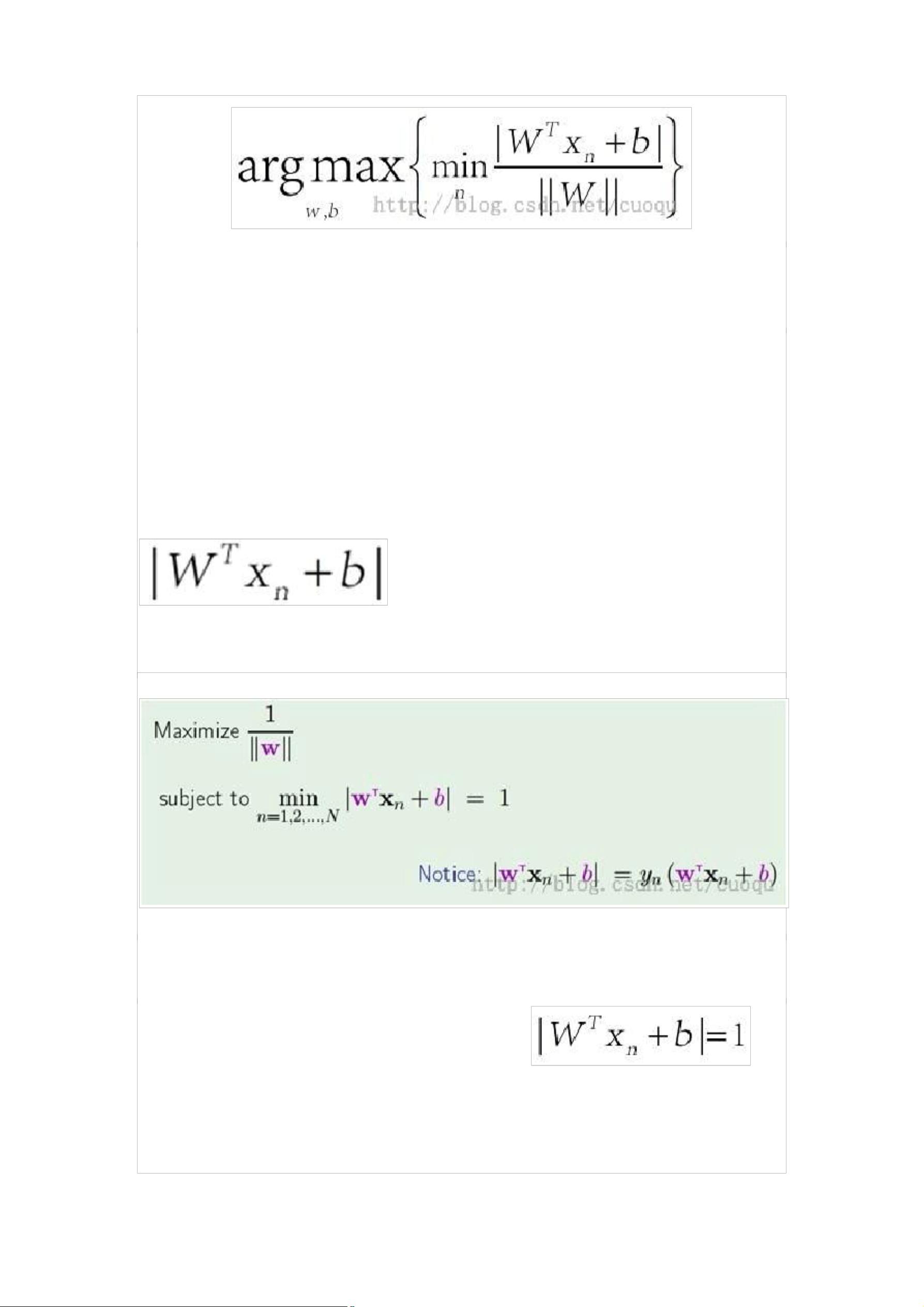

1. 寻找离分类器最近的支持向量:这通常通过最大化间隔来实现,即找到使得样本点到分类器的最小距离,数学上可以表示为:

\[ \min_{\mathbf{w}, b, \xi} \frac{1}{2} \|\mathbf{w}\|^2 + C \sum_{i=1}^{n} \xi_i \]

其中,$\mathbf{w}$是超平面的法向量,$b$是偏置项,$\xi_i$是误分类点的惩罚项,$C$是正则化参数控制误分类代价与间隔的权衡。

2. 最大化间隔:即支持向量到超平面的距离,对于线性可分的情况,可以用公式(公式一)表示距离,而对于非线性情况,核函数会被用到。

\[ d(\mathbf{x}_i) = \frac{\mathbf{w}^T \phi(\mathbf{x}_i) + b}{||\mathbf{w}||} \]

在实际计算中,SVM会找到使间隔最大化的一组支持向量,而不是所有样本点。

实现过程中,我们需要进行以下步骤:

- 数据预处理和特征工程

- 选择合适的核函数(如线性、多项式、径向基函数RBF等)

- 拟合模型(训练集上优化参数)

- 验证和评估模型性能(交叉验证、测试集)

- 使用支持向量识别新样本

Python代码示例可能包括导入必要的库,定义数据集,选择SVM模型,调整参数,训练模型,以及使用模型进行预测。具体代码如下:

```python

from sklearn import svm

from sklearn.model_selection import train_test_split

import numpy as np

# 假设 X_train, y_train 是训练数据,X_test, y_test 是测试数据

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2)

# 创建SVM分类器,可以选择线性或非线性核

clf = svm.SVC(kernel='linear' or 'rbf', C=1.0) # C值需根据数据调整

clf.fit(X_train, y_train)

# 预测

predictions = clf.predict(X_test)

# 评估性能,如准确率、精确率、召回率等

accuracy = accuracy_score(y_test, predictions)

```

总结来说,支持向量机是一种强大的分类工具,通过最大化间隔来提高模型的鲁棒性。在Python中利用Scikit-learn库,可以方便地实现SVM的训练和应用,但需注意选择合适的核函数和调整参数以适应具体问题。

2019-07-11 上传

2022-11-11 上传

2023-05-06 上传

2021-11-27 上传

2023-05-12 上传

2022-10-19 上传

2019-08-17 上传

2023-06-18 上传

春哥111

- 粉丝: 1w+

- 资源: 6万+

最新资源

- mattgirdler.github.io

- cloudinary_public:Dart包装器,可将媒体文件上传到cloudinary

- ulabel:基于浏览器的图像批注工具

- lickwolf.github.io

- .NET在线二手交易系统的ASP毕业设计(源代码+论文).zip

- mern-react:使用Javascript创建Staycation前端(ReactJS)

- Accuinsight-1.0.24-py2.py3-none-any.whl.zip

- js-algorithms:各种算法的 JavaScript 实现

- WebCursos

- workers-forms

- ajalabs_placeholder:AJAlabs.com当前的占位符网站

- 基于web的实验室管理系统毕业设计(自动排课功能的实现).zip

- fbfgbfqq

- 博客

- Qt6可进行录像录音代码特性

- voxel_survival