ELK实战:构建高效日志管理系统

需积分: 10 185 浏览量

更新于2024-07-05

收藏 11.92MB PDF 举报

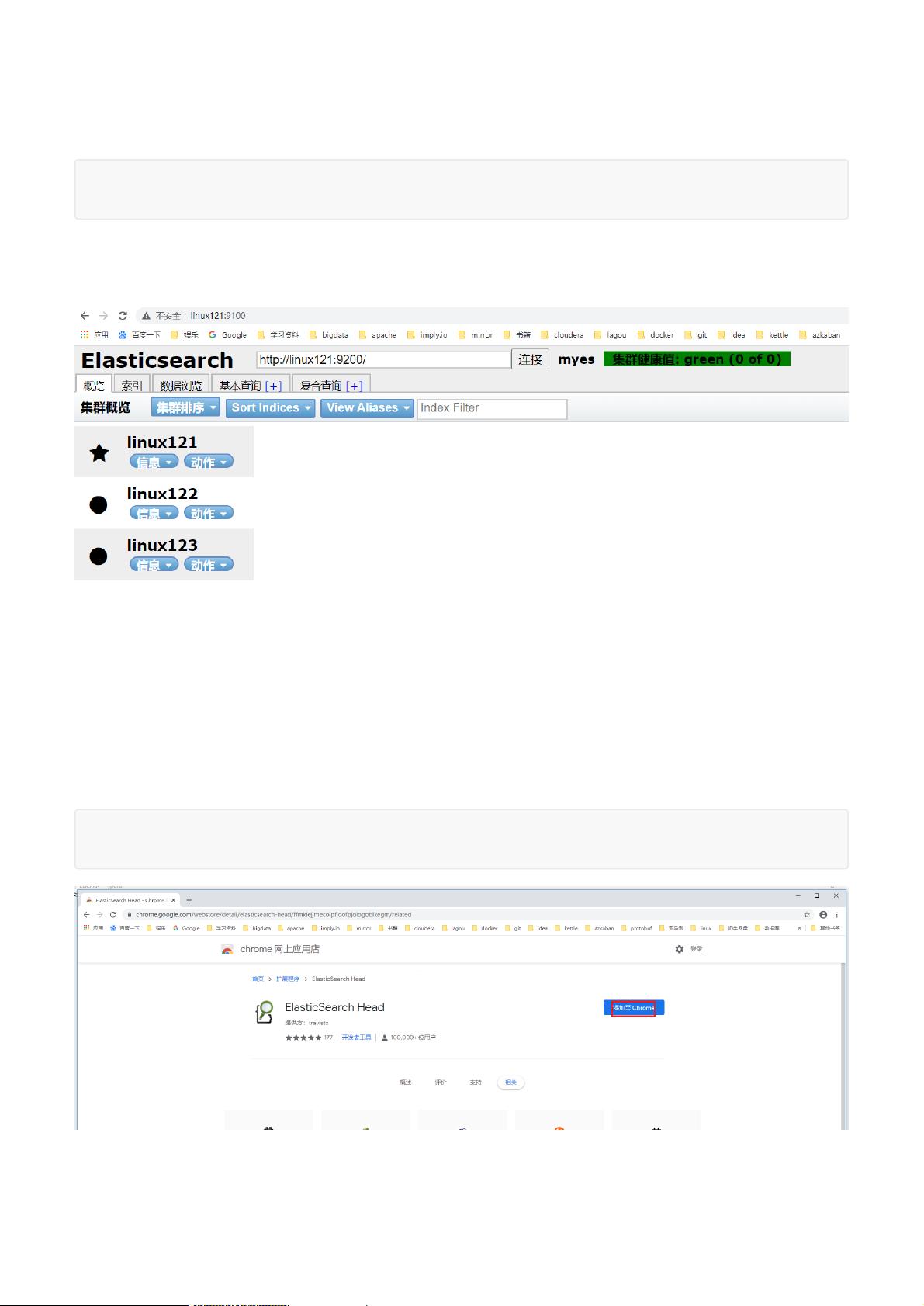

ELK实战文档深入探讨了在大数据时代,如何通过Elasticsearch、Logstash和Kibana这一组合实现高效、集中的日志管理和数据分析。首先,集中式日志系统的重要性在于处理海量、分散的数据源,提高信息检索效率,避免了传统方法的低效和局限。该系统的关键要素包括:

1. **收集**:Elasticsearch作为基础,能够集成多种来源的日志,如操作系统、应用服务和业务逻辑等,通过实时性和分布式特性,确保数据的全面捕获。

2. **传输**:Logstash作为数据管道,扮演数据采集和传输的角色,支持连接各种外部应用,确保数据稳定地流入Elasticsearch。

3. **存储**:Elasticsearch本身具备分布式文件存储能力,每个字段都被索引,提供了高可用性和可扩展性,支持集群、分片和复制,确保数据的持久化和备份。

4. **分析**:Elasticsearch的强大搜索功能允许实时和结构化的数据分析,支持用户界面进行直观查询和可视化。

5. **预警与监控**:Elasticsearch还提供了错误报告和监控机制,帮助检测潜在问题并及时发出警告。

ELK协议栈中的三个核心组件进一步加强了这套解决方案的功能:

- **Elasticsearch (ES)**:基于Lucene的实时搜索和分析引擎,支持全文搜索、结构化查询,以及文档导向设计,易于扩展。

- **Logstash (LS)**:用JRuby编写的实时数据管道,能够处理大量异构数据源,具备弹性扩展能力,由Shipper(数据发送)、Broker(数据收集,内嵌Redis)和Indexer(数据写入)构成。

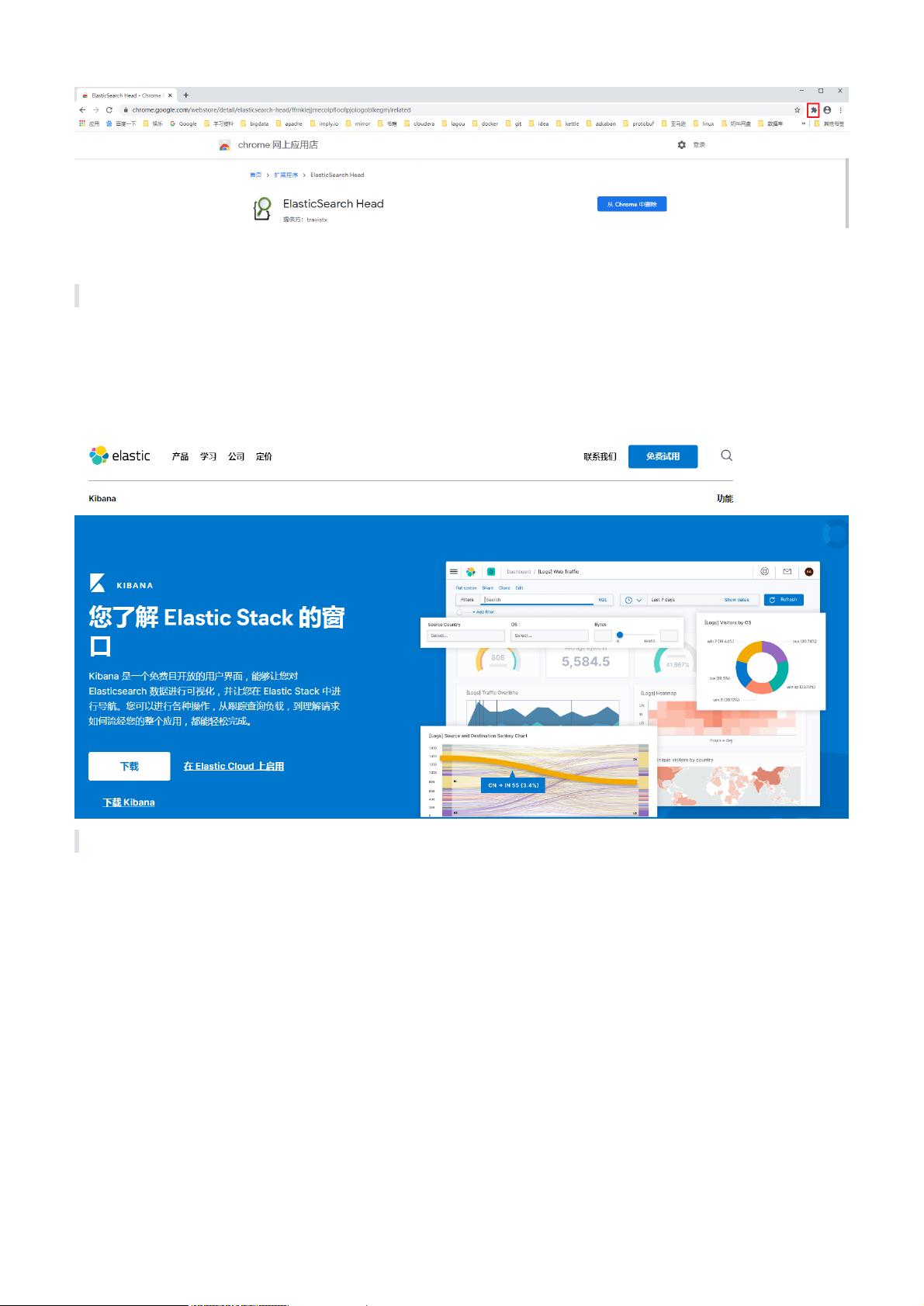

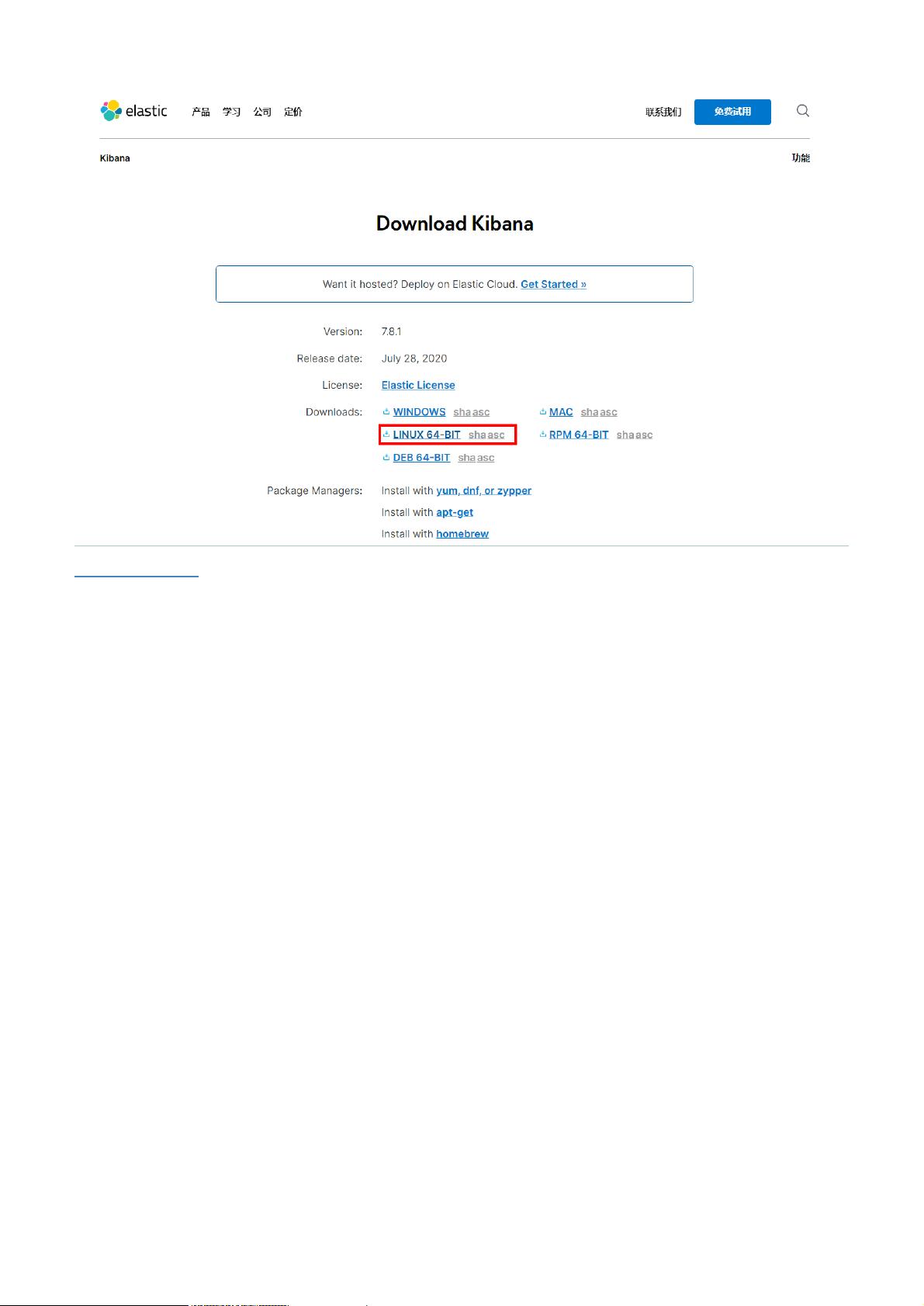

- **Kibana**:数据可视化工具,用户界面友好,允许用户通过图形化界面探索和管理ES中的数据,方便异常检测和性能优化。

总结来说,ELK协议栈为大规模日志管理和数据分析提供了一种强大且灵活的解决方案,帮助企业有效地处理和利用大数据,提高运营效率和决策支持。通过这三个组件的协同工作,企业可以构建出一个高度适应性强、扩展性良好的集中式日志分析平台。

251 浏览量

131 浏览量

380 浏览量

525 浏览量

283 浏览量

974 浏览量

冷酷无情小帅哥

- 粉丝: 4

- 资源: 5

最新资源

- 对ASP.NET MVC项目中的视图做单元测试.txt

- java面试题 面试 java

- AJAX and java(英文)

- java程序员面试题

- Java最著名的开源项目

- Java领域的十大产品

- U盘 硬盘 文件夹自定义图标及背景

- IDL用戶培訓教程(初級入門)

- 屏蔽浏览器的后退按钮

- 如何在虚拟机安装Linux

- GEC2410开发板实战手册

- CCNA Boson NetSim 入门实战

- ps技巧,使用的一些常用技巧

- Configuring_FICO_Lawrence_Rebello

- Eclipse in Action A Guide for the Java Developer.pdf

- Struts快速学习指南