理解LSA与PLSA:模型解析与应用

需积分: 10 112 浏览量

更新于2024-09-16

收藏 254KB DOC 举报

"PLSA和LSA的调研"

在信息检索和自然语言处理领域,PLSA(概率潜在语义分析)和LSA(潜在语义分析)是两种重要的技术,它们都致力于理解和揭示文本数据中的隐藏语义结构。本文主要探讨了这两种方法的基本概念、特点和应用。

一、LSA(潜在语义分析)

LSA是一种统计方法,由S.T. Dumais等人在1988年提出,其目标是通过分析大量文本,找出词与词之间的潜在语义关系,以消除词汇的相关性,降低文本向量的维度。LSA的核心在于奇异值分解(SVD),它将高维的词-文档矩阵转换为低维的潜在语义空间。在这个空间中,词和文档的表示更能反映它们的语义相似性,而不是简单的词汇共现。LSA的应用广泛,包括信息过滤、文档索引、视频检索、文本分类与聚类、图像检索和信息抽取等。

二、LSA的工作原理

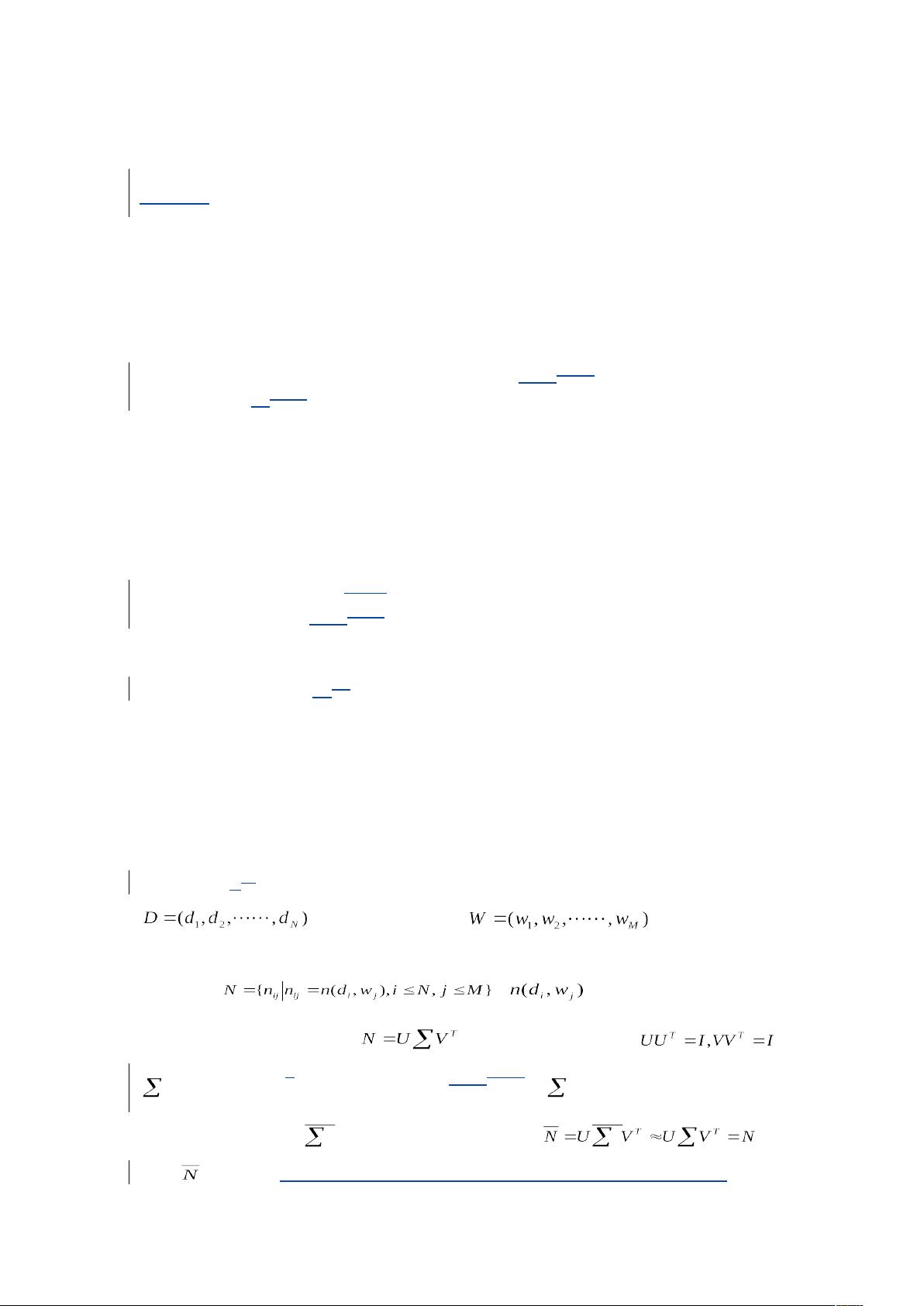

LSA的基本步骤包括:

1. 创建词-文档矩阵,记录每个文档中每个词的频率。

2. 对该矩阵进行奇异值分解(SVD),分解成三个矩阵的乘积:U * Σ * V^T。

3. 保留最大的K个奇异值,形成一个低秩近似,以降低维度。

4. 重构矩阵,获得文档在低维空间的表示。

5. 分析重构后的矩阵,提取出低维语义特征,这些特征可以用来计算文档之间的相似度。

三、PLSA(概率潜在语义分析)

PLSA是LSA的一个概率解释,它引入了主题(topics)的概念,认为每个文档都是由多个主题混合生成的,而每个词的出现则与这些主题有关。在PLSA模型中,每个文档被视为由一系列隐藏主题的概率分布组合而成,每个主题又有一系列词的概率分布。PLSA的目标是通过最大似然估计找到这些隐藏的主题分布,以解释观察到的词频数据。与LSA不同,PLSA的优化通常采用EM(期望最大化)算法。

四、PLSA与LSA的区别

虽然两者都试图捕捉文本的潜在语义,但它们的出发点和方法有所不同:

1. LSA是基于线性代数的矩阵分解,而PLSA是基于概率模型。

2. LSA的输出是静态的低维空间,而PLSA可以提供主题的动态解释。

3. PLSA可以解释为什么某些词出现在特定文档中,而LSA则不能。

总结,PLSA和LSA都是强大的工具,用于挖掘文本数据的深层结构。LSA更侧重于降维和相似性计算,而PLSA则提供了对主题分布的洞察,有助于理解文本内容的生成过程。在实际应用中,选择使用哪种方法取决于具体任务的需求和数据的特性。

279 浏览量

108 浏览量

2021-02-10 上传

174 浏览量

2021-09-11 上传

413 浏览量

322 浏览量

jihaifeng137211

- 粉丝: 0

最新资源

- 易二维码签到系统:会议活动签到解决方案

- Ceres库与SDK集成指南:C++环境配置及测试程序

- 深入理解Servlet与JSP技术应用与源码分析

- 初学者指南:掌握VC摄像头抓图源代码实现

- Java实现头像剪裁与上传的camera.swf组件

- FileTime 2013汉化版:单文件修改文件时间的利器

- 波斯语话语项目:实现discourse-persian配置指南

- MP4视频文件数据恢复工具介绍

- 微信与支付宝支付功能封装工具类介绍

- 深入浅出HOOK编程技术与应用

- Jettison 1.0.1源码与Jar包免费下载

- JavaCSV.jar: 解析CSV文档的Java必备工具

- Django音乐网站项目开发指南

- 功能全面的FTP客户端软件FlashFXP_3.6.0.1240_SC发布

- 利用卷积神经网络在Torch 7中实现声学事件检测研究

- 精选网站设计公司官网模板推荐