Sqoop导入与导出详解:从RDBMS到Hadoop

需积分: 9 192 浏览量

更新于2024-09-01

收藏 315KB DOCX 举报

Sqoop 是Apache Hadoop项目中的一个重要工具,专门用于在关系型数据库(如MySQL)和Hadoop生态系统(如HDFS和Hive)之间进行数据迁移。本文档是关于Sqoop的学习资料,主要关注两个关键功能:Sqoop import 和 Sqoop export。

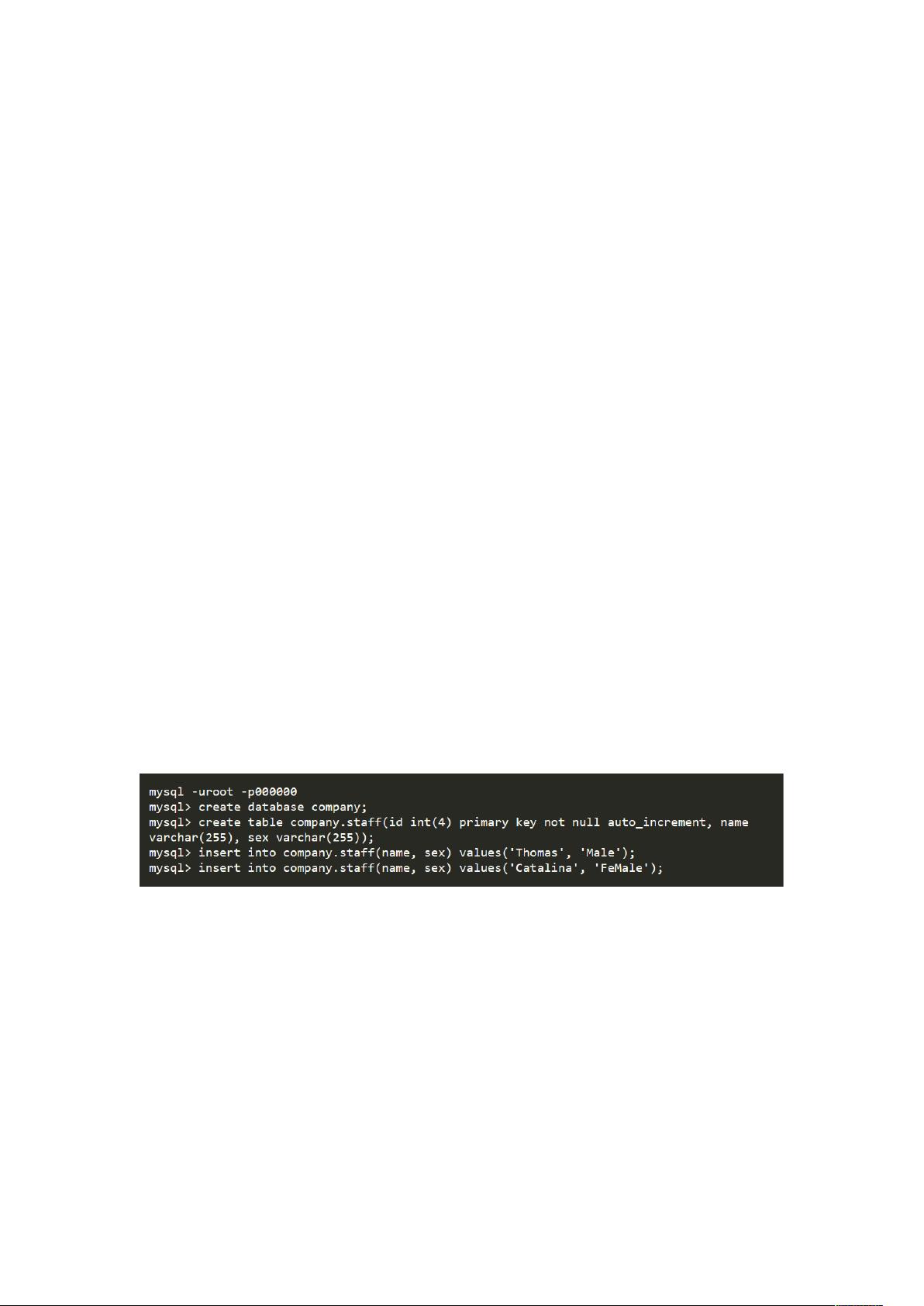

Sqoop import 是用于将数据从关系型数据库导入Hadoop集群的过程。首先,确保MySQL服务已正常运行,并创建一个测试表并填充数据。在执行导入操作时,有多种参数可供调整:

1. 基本参数:

- `--connect`:用于指定与数据库的JDBC连接字符串。

- `--username`和`--password`:数据库的用户名和密码。

- `--table`:导入的特定表名。

- `--target-dir`:HDFS的目标存储路径。

- `-m` 或 `--num-mappers`:设置并行导入的map任务数量。

- `--fields-terminated-by`:指定字段之间的分隔符。

2. 查询导入:

- `--query`:允许导入满足特定SQL查询的结果,如`SELECT * FROM staff WHERE id <= 1 AND $CONDITIONS`,其中`$CONDITIONS`是一个可传递的参数。

- 如果SQL查询中含有特殊字符,如美元符号,需使用转义或额外的选项。

3. 选择性导入:

- `--columns`:只导入表中的特定列,列名之间用逗号分隔。

4. 使用关键字筛选数据:

- `--where`:用于指定导入的行条件。

对于将数据导入Hive,由于Hive不直接支持数据导入,通常会先将数据导入HDFS,然后通过`--hive-import`选项将数据加载到Hive表中。这个过程涉及两个步骤:首先将数据复制到HDFS的临时目录(默认为`/user/用户名/表名`),然后调用Hive的`LOAD DATA INPATH`语句完成数据加载。

Sqoop export 用于从Hadoop到关系型数据库导出数据,但本文档并未详细介绍这部分内容。整体而言,学习和掌握Sqoop的关键在于理解其工作原理,熟悉命令行参数,以及如何根据实际需求灵活配置和使用,以便高效地在不同数据存储系统间进行数据交换。

最后,作者鼓励读者在学习过程中提出问题和建议,保持交流,共同提升对Sqoop的理解。在引用或借鉴内容时,应确保注明出处,尊重他人的劳动成果。

2020-07-28 上传

2022-11-24 上传

2020-10-10 上传

2020-06-12 上传

2021-05-20 上传

2015-11-10 上传

2017-08-28 上传

2021-10-12 上传

2024-07-24 上传

fy_1852003327

- 粉丝: 198

- 资源: 44

最新资源

- JavaScript实现的高效pomodoro时钟教程

- CMake 3.25.3版本发布:程序员必备构建工具

- 直流无刷电机控制技术项目源码集合

- Ak Kamal电子安全客户端加载器-CRX插件介绍

- 揭露流氓软件:月息背后的秘密

- 京东自动抢购茅台脚本指南:如何设置eid与fp参数

- 动态格式化Matlab轴刻度标签 - ticklabelformat实用教程

- DSTUHack2021后端接口与Go语言实现解析

- CMake 3.25.2版本Linux软件包发布

- Node.js网络数据抓取技术深入解析

- QRSorteios-crx扩展:优化税务文件扫描流程

- 掌握JavaScript中的算法技巧

- Rails+React打造MF员工租房解决方案

- Utsanjan:自学成才的UI/UX设计师与技术博客作者

- CMake 3.25.2版本发布,支持Windows x86_64架构

- AR_RENTAL平台:HTML技术在增强现实领域的应用