Spark 2.4.0编程入门教程:快速掌握Dataset API

需积分: 9 122 浏览量

更新于2024-09-06

收藏 624KB PDF 举报

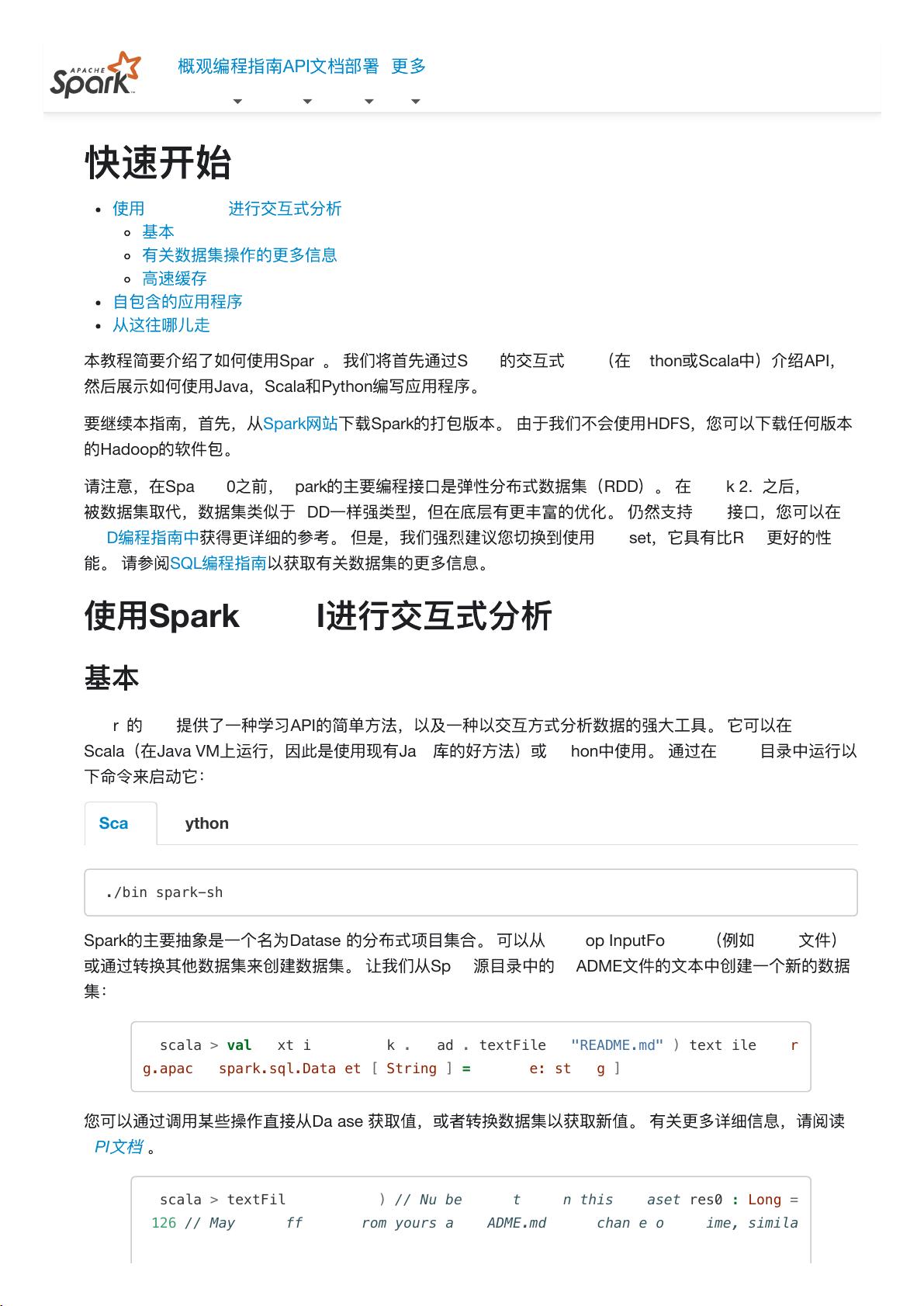

"Spark 2.4.0的编程指南快速入门文档,涵盖了Spark的基本概念、API使用、交互式分析和数据集操作等核心内容。文档旨在帮助开发者快速熟悉Spark的使用,包括通过SparkShell进行交互式分析,理解数据集的操作,以及如何编写基于Java、Scala和Python的应用程序。"

在Spark 2.4.0版本中,编程指南主要分为以下几个部分:

1. **概览**:这部分简要介绍Spark的核心功能和主要组件,包括SparkShell、编程API和部署选项。

2. **快速开始**:为初学者提供了快速了解和使用Spark的路径。首先推荐使用SparkShell,它是Spark提供的一个交互式环境,可用于学习API并进行数据分析。SparkShell支持Scala和Python,启动命令为`./bin/spark-shell`。

3. **数据集**:Spark 2.0以后,数据集成为主要的编程接口,它提供了强类型和更丰富的优化,相比RDD有更好的性能。数据集可以从HadoopInputFormats创建,例如从HDFS文件读取,也可以通过转换其他数据集得到。例如,使用`spark.read.textFile("README.md")`可以从文件创建一个文本数据集。

4. **RDD**:虽然RDD(弹性分布式数据集)不再是主要接口,但仍然支持,并且在RDD编程指南中有详细的参考。RDD是Spark的基础,它是一组不可变、分区的数据元素,可以在集群中并行操作。

5. **高速缓存**:Spark支持将数据集缓存到内存中,以便后续操作可以更快地访问,这是实现高性能的关键特性。使用`cache()`或`persist()`方法可以将数据集保存在内存中。

6. **自包含的应用程序**:开发Spark应用程序时,需要确保所有依赖项都包含在构建文件中,以便在不同环境中正确运行。

7. **API文档**和**部署**:Spark提供了详细的API文档,覆盖了所有编程语言的接口。此外,部署部分指导用户如何在不同的集群配置上安装和运行Spark。

8. **学习路径**:文档最后会指引用户如何进一步学习Spark,包括深入理解数据集的使用和SQL编程,以及如何扩展到更高级的主题。

Spark 2.4.0编程指南是学习和掌握Spark基础功能的重要资源,它通过实例和清晰的解释,帮助开发者快速上手,从而高效地利用Spark处理大规模数据。

237 浏览量

243 浏览量

2023-03-06 上传

2023-03-15 上传

2023-03-06 上传

2023-03-13 上传

2023-03-08 上传

2023-03-12 上传

wlcdcy

- 粉丝: 2

最新资源

- Ubuntu/Mac工作站的Ansible自动化配置手册

- 掌握核心,JAVA初级面试题解析大全

- 自我测试指南:成功方法与技巧大公开

- ReactSortableHOC实现动画化可排序的触摸友好列表

- SAE开源平台:整合Spring与SMS通讯功能

- 温尼伯公交信息实时查询系统开发

- JAVA实现的可部署仓储管理信息系统详解

- ArquitecturaClass软件:探讨JavaScript的架构设计

- 掌握React项目构建与部署的capstone3指南

- 详细解读车辆购置附加费征收办法

- Java实现学生成绩管理系统的设计与功能

- 易语言实现的MDB网络数据库模块源码解析

- 艺佰设计提供清新企业Discuz模板下载

- 掌握Python中的MLEnsemble实现高效集成学习

- Java实现读取搜狗细胞词库scel文件教程

- 探索城市星球的崛起:Nature & Science精选论文