知识图谱驱动的可解释机器学习:2021 KGC大会深度解析

需积分: 10 92 浏览量

更新于2024-07-10

收藏 92.86MB PDF 举报

知识图谱(Knowledge Graph, KG)在可解释机器学习(Explainable Machine Learning, XAI)中的角色日益受到关注。在2021年5月的 Knowledge Graph Conference (KGC)上,加拿大CortAIx的首席人工智能科学家Freddy Lecue发表了一篇名为《On the Role of Knowledge Graphs in Explainable Machine Learning》的报告。该会议是一个全球性的平台,汇聚了业界专家、研究人员和供应商,共同探讨知识图谱技术的发展及其在人工智能领域的应用,特别是与XAI的结合。

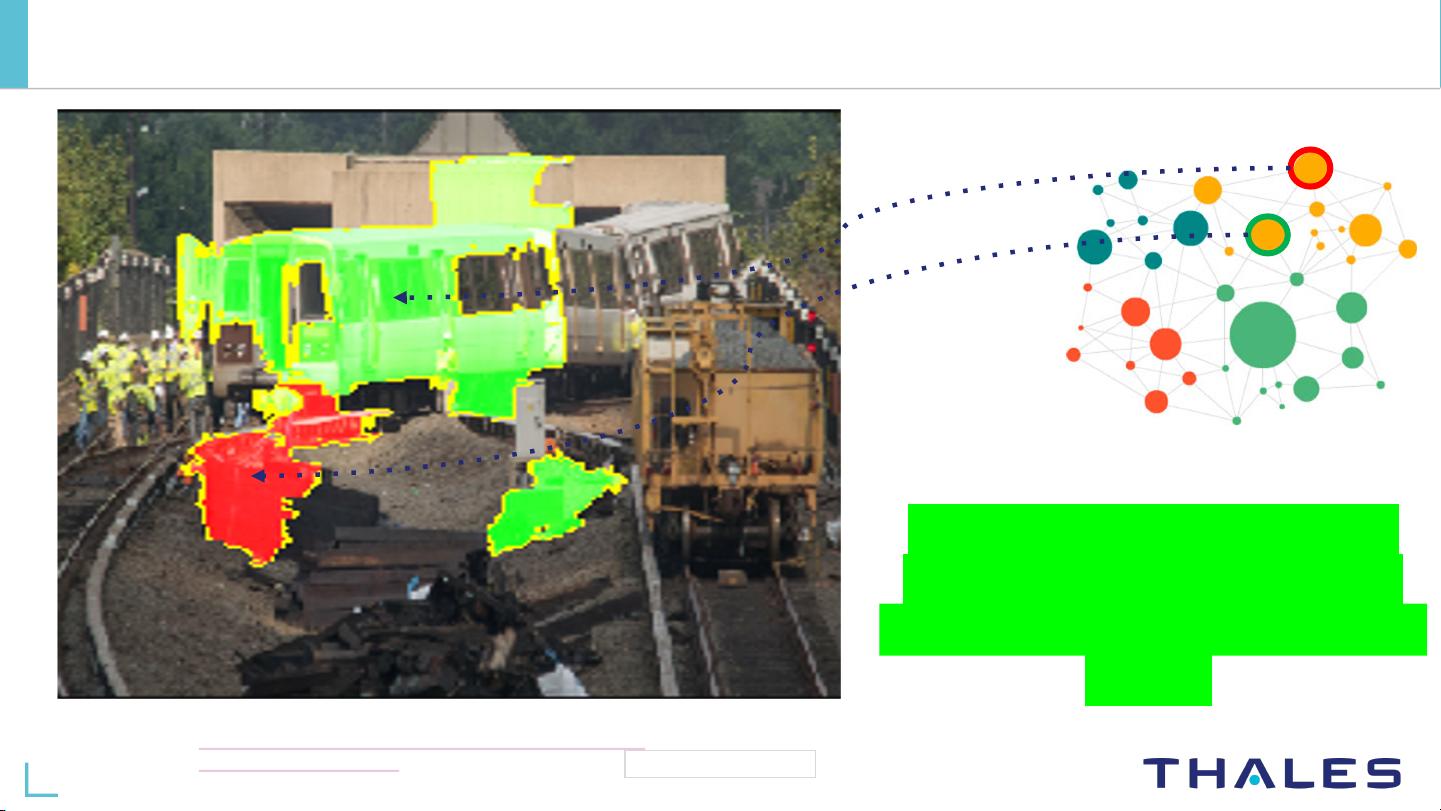

Lecue的报告指出,尽管机器学习(ML)在许多领域取得了显著成果,如Thales Group这样的企业可能在其关键系统中采用深度学习模型(如人工神经网络),但这些模型往往缺乏透明度,难以解释其决策过程。这是因为它们处理的信息超出了传统ML系统对常识和逻辑推理的理解范围。知识图谱作为一种结构化的知识表示方式,有助于解决这一问题,它能够整合大量的结构化和半结构化数据,提供一个更易于理解和解释的决策背景。

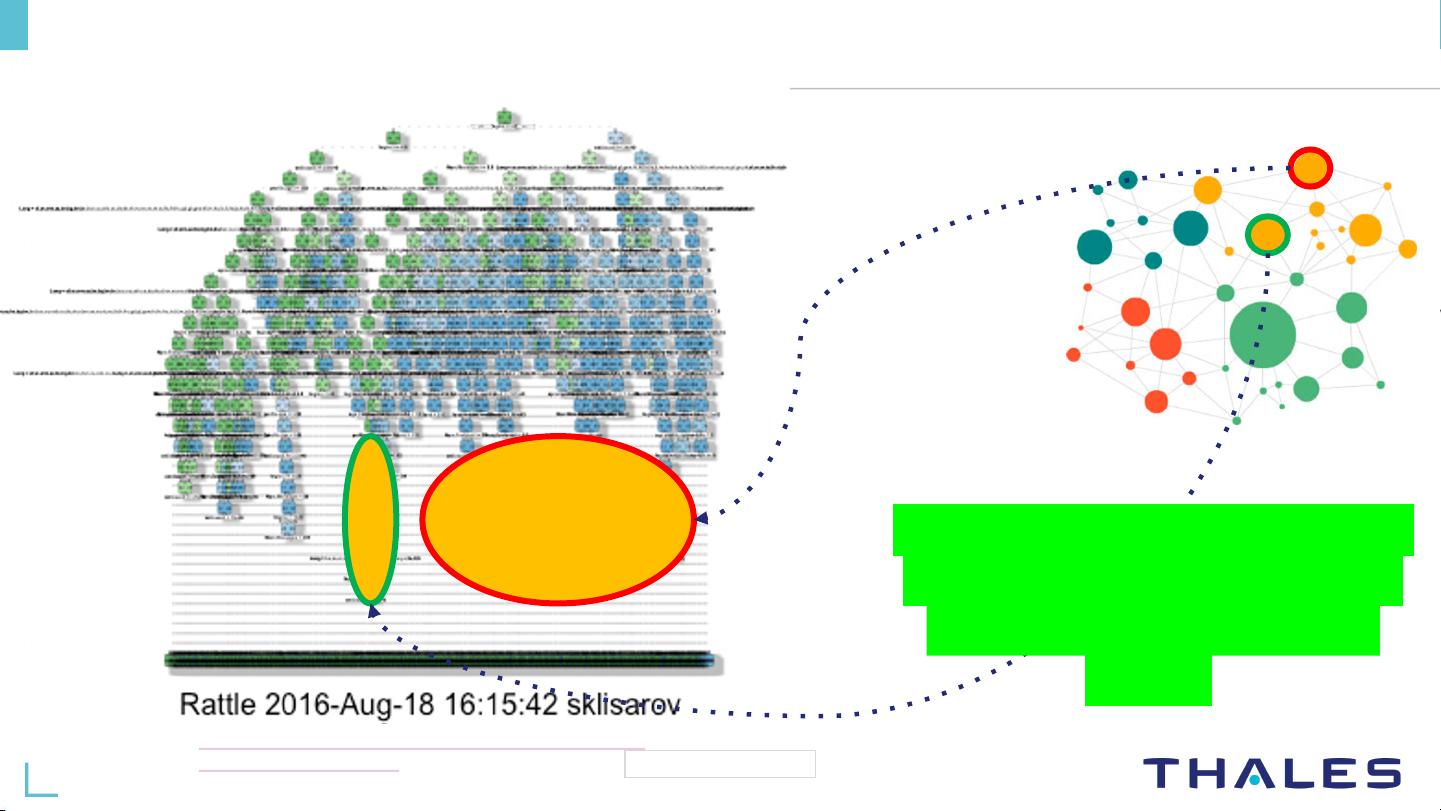

通过将机器学习与知识图谱相结合,Lecue展示了如何利用知识图谱来生成人类可理解的解释。例如,当一个ML模型在识别资源类别时,知识图谱可以作为上下文,揭示模型依据哪些具体信息做出决策,这有助于增强用户对模型决策的信任。在KGC2021的虚拟会议上,Lecue分享了构建这样一个框架的详细方法,该框架能够在处理大量数据(4,233,000个资源)时,给出接近人类水平的解释,这对于提高人工智能系统的可信度至关重要。

报告强调了知识图谱在关键应用中的核心价值,尤其是在那些需要高度透明度和可解释性的场景中,如军事、医疗、金融等。在处理涉及隐私和法规的复杂决策时,确保机器学习的透明性和责任是至关重要的。通过知识图谱的支持,机器学习模型不仅能提升性能,还能增进用户对模型决策的信心,从而推动AI技术在更多领域实现稳健和可靠的应用。Lecue的研究成果为知识图谱在可解释机器学习中的发展提供了有价值的方向和策略。

152 浏览量

点击了解资源详情

点击了解资源详情

302 浏览量

171 浏览量

2022-07-14 上传

2021-11-21 上传

114 浏览量

144 浏览量

四季小葱

- 粉丝: 0

最新资源

- 易语言实现URL进度下载的源码示例

- JDK1.8版本详解:适合高版本软件的Java环境配置

- Ruby版Simple Code Casts项目部署与运行指南

- 大漠插件C#封装技术详解与应用

- 易语言实现Base64编解码的汇编源码解读

- Proyecto KIO网络中间件getContact深入解析

- 微软PowerShell自定义学习项目介绍

- ExtJS 3.3中文教程:前端开发指南

- Go语言在VR领域的新突破:集成OVR Linux SDK

- Python Kivy实现的Google服务客户端入门指南

- 微软Visual C++ 2008 Express版下载发布

- MATLAB开发实现球形投影数字化工具

- 掌握JavaScript实现待办事项清单应用

- inmarketify项目:TypeScript应用实践指南

- 俪影2005 v1.28:图像编辑与文件夹加密软件

- 基于MD5骨骼动画在Direct3D中的实现与核心算法解析