大数据特征工程:数据获取与预处理详解

需积分: 9 168 浏览量

更新于2024-07-18

收藏 3.89MB PPTX 举报

大数据特征是现代信息技术领域的重要概念,它涵盖了数据采集、预处理和特征工程等多个环节,特别是在电信和互联网行业中广泛应用。以下是关于大数据特征的深入解析:

1. 数据获取:

- 数据采集的关注点包括数据来源、质量和成本,以及数据的实时获取效率。例如,在预测用户业务行为时,需要收集套餐侧信息(如价格、功能)、用户侧信息(如消费习惯、地理位置),同时要考虑“幸存者偏差”,即仅关注那些成功或留存的用户数据,可能忽略了某些关键特征。

- 为了确保数据的有效性,数据采集通常涉及宽表数据的构建,通过ETL(提取、转换、加载)技术从多个数据源抽取相关数据,进行关联、转换和计算,形成统一的数据结构。

2. 数据预处理:

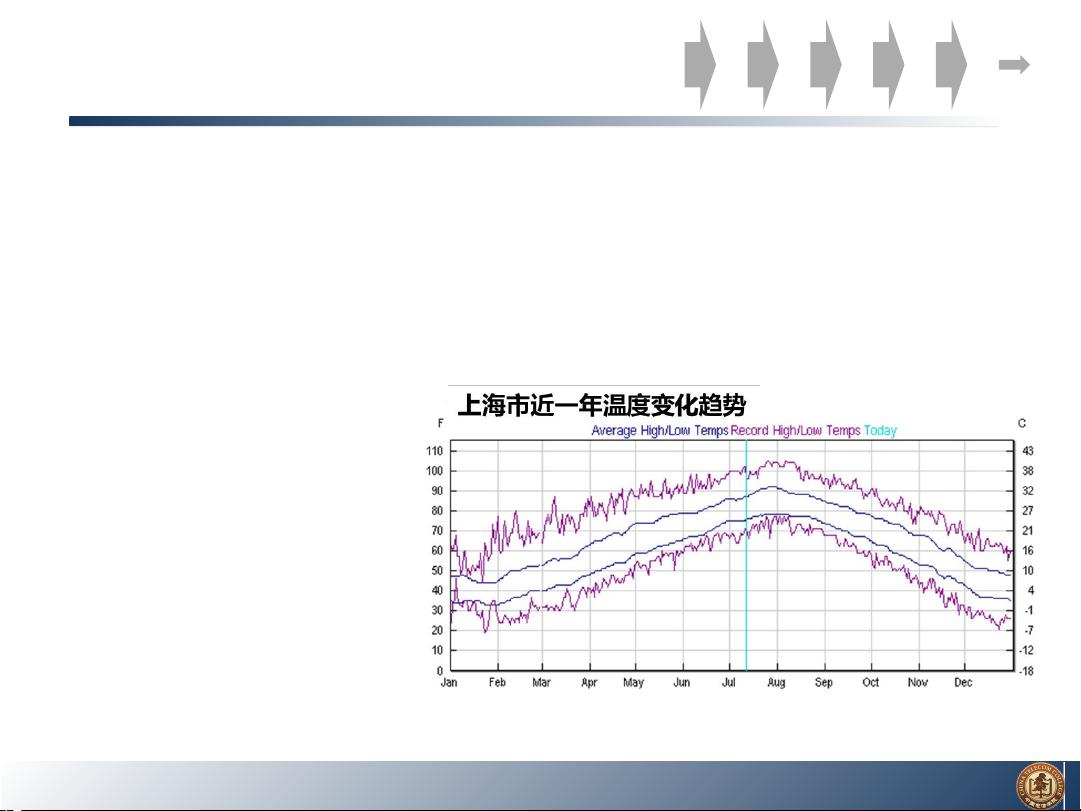

- 结构化数据类型主要包括时序变量(时间顺序上的数据)和序列变量(具有特定顺序的变量),如人口排名。

- 预处理过程包括样本选取(如随机采样和分层抽样,遵循代表性与无偏原则)、数据清洗(去除错误数据,如年龄负值或异常值),以及考虑时间序列数据的衰减效应。

3. 特征工程:

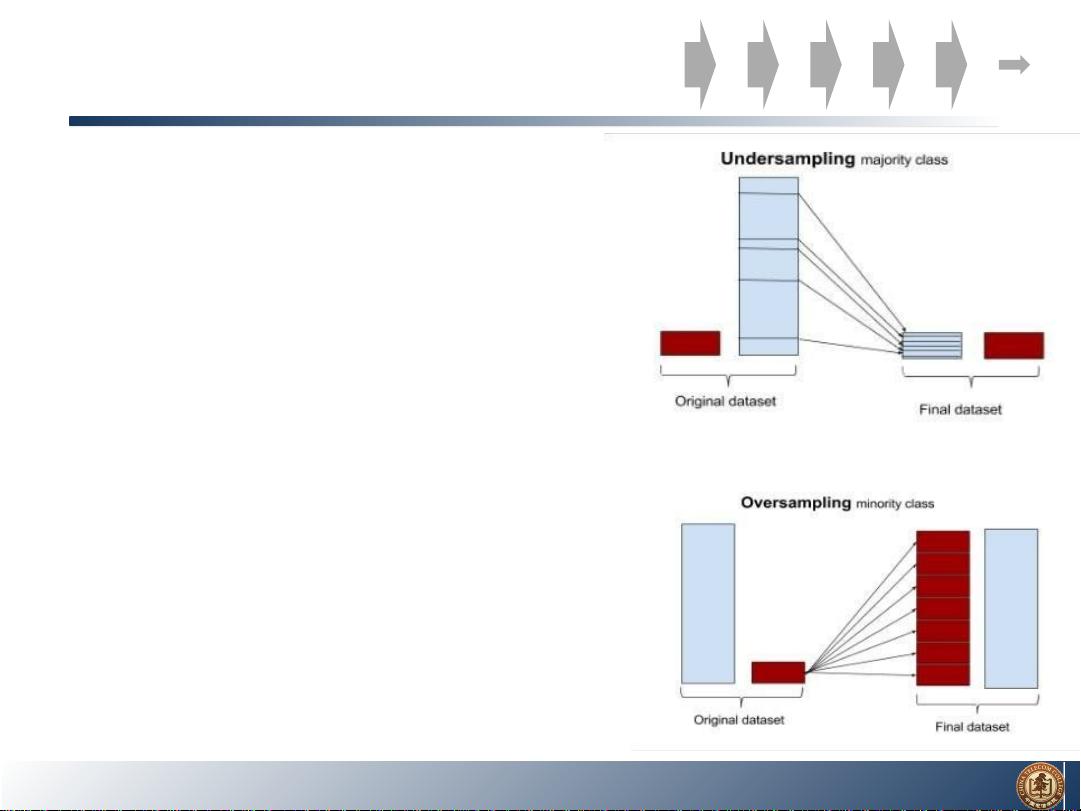

- 特征工程是关键步骤,需确定哪些数据对模型预测最为重要,并解决数据不平衡问题,如电商购买行为、疾病患者与健康人群的比例。常见的处理方法有下采样(减少多数类样本)、上采样(增加少数类样本)以及调整损失函数。

4. 数据清洗的重要性:

- 数据清洗是为了避免“Garbage in, Garbage out”现象,确保输入数据的质量直接影响到算法的输出。算法对输入数据的准确性要求极高,数据清洗可以消除简单错误、逻辑错误,以及纠正异常值,从而提高模型的性能。

5. 数据分段与评估:

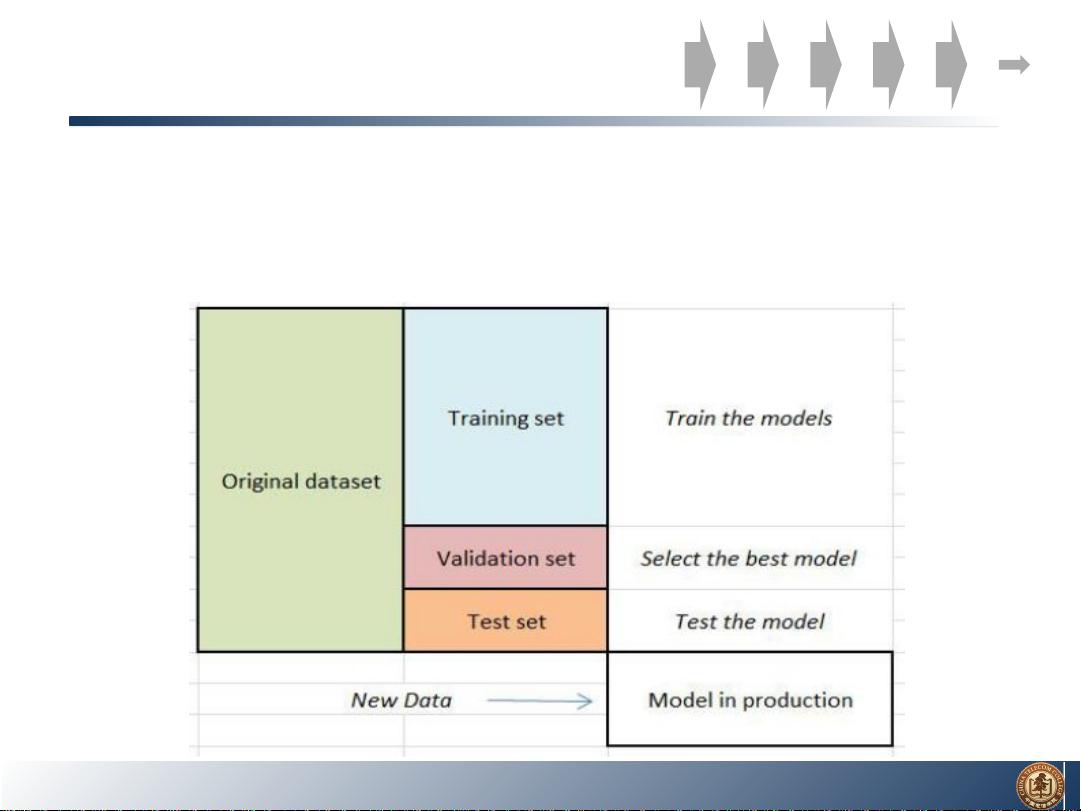

- 通常将数据划分为训练集、验证集和测试集,分别用于模型训练、模型选择和模型性能验证。训练集用于模型参数的学习,验证集用于模型调优,而测试集用于最终评估模型的泛化能力。

总结来说,大数据特征分析是基于数据驱动的决策支持过程,涉及数据获取的策略、数据预处理的技术以及特征选择和工程的技巧。理解并有效利用这些特征,有助于在电信和互联网行业中做出精准的预测和决策,提升业务效能。

608 浏览量

点击了解资源详情

199 浏览量

290 浏览量

285 浏览量

136 浏览量

2022-02-25 上传

2021-07-05 上传

2021-10-17 上传

zeewing

- 粉丝: 0

最新资源

- 32位TortoiseSVN_1.7.11版本下载指南

- Instant-gnuradio:打造定制化实时图像和虚拟机GNU无线电平台

- PHP源码工具PHProxy v0.5 b2:多技术项目源代码资源

- 最新版PotPlayer单文件播放器: 界面美观且功能全面

- Borland C++ 必备库文件清单与安装指南

- Java工程师招聘笔试题精选

- Copssh:Windows系统的安全远程管理工具

- 开源多平台DimReduction:生物信息学的维度缩减利器

- 探索Novate:基于Retrofit和RxJava的高效Android网络库

- 全面升级!最新仿挖片网源码与多样化电影网站模板发布

- 御剑1.5版新功能——SQL注入检测体验

- OSPF的LSA类型详解:网络协议学习必备

- Unity3D OBB下载插件:简化Android游戏分发流程

- Android网络编程封装教程:Retrofit2与Rxjava2实践

- Android Fragment切换实例教程与实践

- Cocos2d-x西游主题《黄金矿工》源码解析