基于无数据知识提取的非IID联邦学习:FedFTG算法

PDF格式 | 866KB |

更新于2025-01-16

| 95 浏览量 | 举报

无数据知识提取的非IID联邦学习

在联邦学习(FL)中,数据异构性是一个主要挑战,因为它导致收敛速度慢和性能下降。大多数实例方法只通过限制客户端局部模型更新来解决异构性问题,而忽略了直接全局模型聚集所带来的性能下降。为了解决这个问题,我们提出了无数据的知识蒸馏方法FedFTG,在服务器端,缓解了直接模型聚集的问题,以微调的聚集模型。FedFTG通过生成器探索局部模型的输入空间,并利用它将局部模型的知识传递到全局模型。此外,我们提出了一个硬样本挖掘方案,以实现整个训练过程中有效的知识提炼。我们的FedFTG显着优于国家的最先进的(SOTA)FL算法,可以作为一个强大的插件,用于增强FedAvg,FedProx,FedDyn和SCAFFOLD。

一、联邦学习概述

联邦学习(FL)是一种新兴的隐私约束下的分布式学习模式。FL的主要挑战之一是数据异质性,即客户端中的数据是不相同且独立分布的(非IID)。已经证实,香草FL算法FedAvg导致漂移的局部模型,并且在这种情况下灾难性地忘记全局知识,这进一步导致性能下降和收敛缓慢。

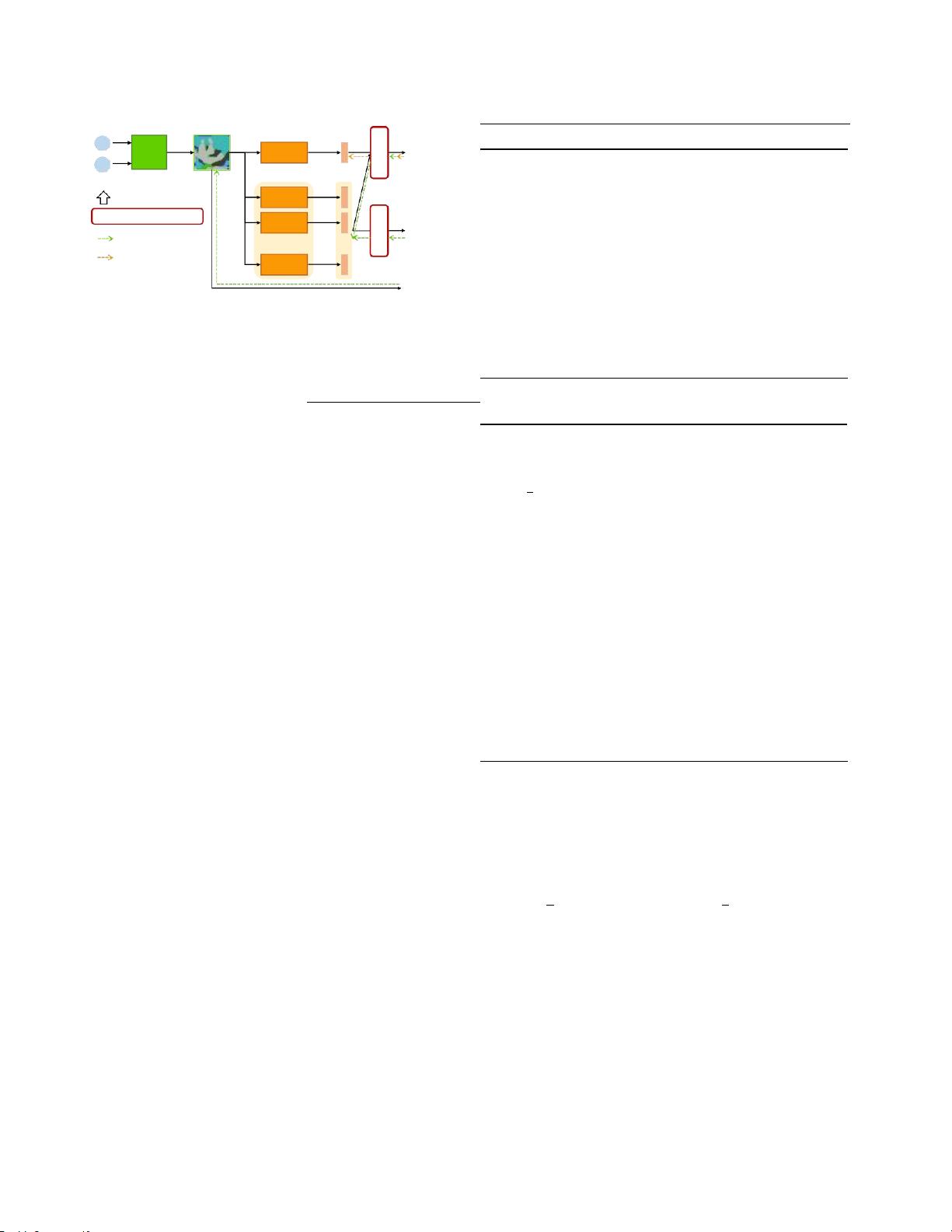

二、无数据知识提取方法FedFTG

FedFTG是一种无数据的知识蒸馏方法,在服务器端,缓解了直接模型聚集的问题,以微调的聚集模型。FedFTG通过生成器探索局部模型的输入空间,并利用它将局部模型的知识传递到全局模型。FedFTG可以缓解模型聚集后的性能下降问题,提高FL的性能。

三、硬样本挖掘方案

我们提出了一个硬样本挖掘方案,以实现整个训练过程中有效的知识提炼。该方案可以帮助FL模型更好地学习客户端的数据特征,提高FL的性能。

四、实验结果

大量的实验表明,FedFTG显着优于国家的最先进的(SOTA)FL算法,可以作为一个强大的插件,用于增强FedAvg,FedProx,FedDyn和SCAFFOLD。

五、结论

无数据知识提取的非IID联邦学习可以缓解FL中的数据异构性问题,提高FL的性能。我们的FedFTG方法可以作为一个强大的插件,用于增强FL算法,提高FL的性能和收敛速度。

相关推荐

cpongm

- 粉丝: 6

最新资源

- JavaScript在农作物管理中的应用分析

- iOS中使用alpha渐变数据提升动画切换平滑性

- 易语言实现的网页自动化填表注册教程

- 掌握MFC图形绘制:直线、椭圆、矩形的实现技巧

- QQ全能绿化工具magic01深度解析

- 小祝工作室截图展示与工作流程验证

- 华为路由器日常维护与监测的实践指南

- Pentaho大数据分析解决方案及代码实践(2013)

- 计算机维护中的实用bat脚本技巧

- SAP ERP教程全集:掌握企业资源规划精髓

- 深入理解HBase表设计与操作技巧

- 探索CAD格式转换器:高效版本互换

- JavaScript API时间表管理指南

- Qt虚拟键盘实现及测试报告

- 掌握SQL Server开发的终极指南

- SVN中文语言包1.5.3版本发布及下载指南