FedKC:联邦学习解决多语言自然语言理解的挑战

2 浏览量

更新于2024-06-19

收藏 1021KB PDF 举报

"联邦知识组合模块:解决多语言自然语言理解的联邦学习问题"

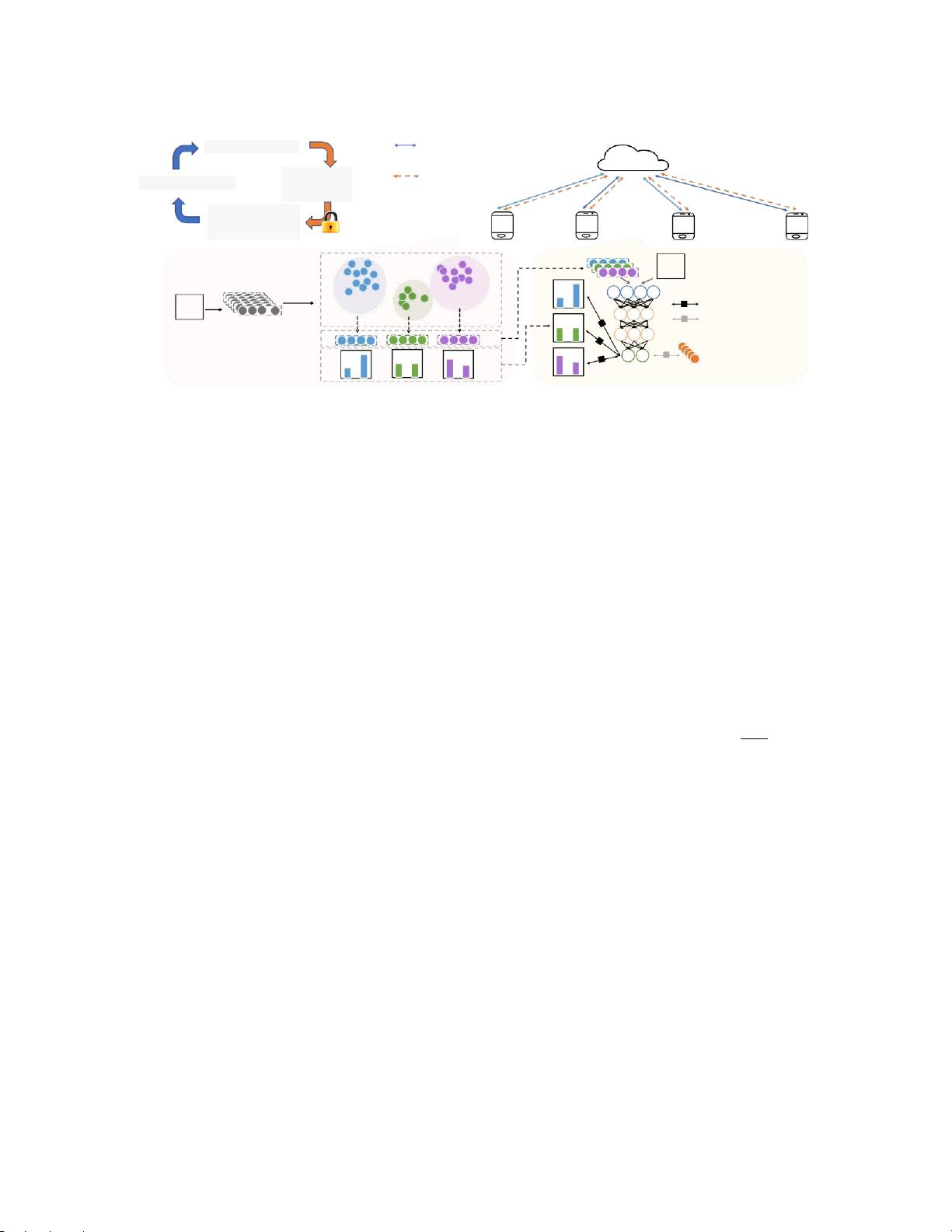

联邦学习是一种新兴的机器学习范式,旨在在保护数据隐私的同时,利用分布式数据进行模型训练。在自然语言理解(NLU)领域,多语言数据的处理是一项关键挑战,因为这些数据通常分散在不同的客户端,且具有非独立同分布(Non-IID)特性,尤其是语言分布的不平衡。现有的联邦学习方法主要针对IID数据设计,无法有效地处理多语言环境。

针对这一问题,研究人员提出了FedKC,这是一个联邦学习框架下的知识组合模块,特别为多语言NLU任务设计。FedKC的核心思想是在各客户端之间交换知识,而不是直接共享原始数据,这样可以在保护隐私的同时提升模型的性能。它通过计算基于跨客户端共享知识定义的一致性损失,使不同客户端上的模型能够在相似数据上做出一致的预测,从而促进模型的协同训练。

FedKC的设计考虑了非IID数据的特性,如数据分布的倾斜和语言资源的不均衡。对于只包含单语或双语数据的客户端,FedKC能够帮助它们学习其他语言的信息,以提高对低资源语言的理解能力。此外,FedKC的理论分析显示,它对原始数据具有较强的隐私保护,难以从损坏的数据中恢复原始信息。

实验部分,FedKC在三个公共多语言数据集上进行了验证,涵盖了释义识别、问答匹配和新闻分类等典型NLU任务。结果显示,FedKC在所有数据集上都显著优于传统的基线算法,证明了其在处理多语言联邦NLU任务上的优越性能。

FedKC的创新之处在于它的即插即用性质,可以方便地集成到现有的联邦学习框架中,为解决多语言环境下的隐私保护和高效学习提供了一个有效的解决方案。同时,它对教育和研究的开放许可也促进了学术界的交流与合作,推动了联邦学习和自然语言理解领域的进一步发展。

2021-01-06 上传

2021-05-17 上传

2023-03-31 上传

2023-06-10 上传

2024-04-08 上传

2023-05-12 上传

2023-03-25 上传

2023-09-08 上传

2023-07-29 上传

cpongm

- 粉丝: 5

- 资源: 2万+

最新资源

- 磁性吸附笔筒设计创新,行业文档精选

- Java Swing实现的俄罗斯方块游戏代码分享

- 骨折生长的二维与三维模型比较分析

- 水彩花卉与羽毛无缝背景矢量素材

- 设计一种高效的袋料分离装置

- 探索4.20图包.zip的奥秘

- RabbitMQ 3.7.x延时消息交换插件安装与操作指南

- 解决NLTK下载停用词失败的问题

- 多系统平台的并行处理技术研究

- Jekyll项目实战:网页设计作业的入门练习

- discord.js v13按钮分页包实现教程与应用

- SpringBoot与Uniapp结合开发短视频APP实战教程

- Tensorflow学习笔记深度解析:人工智能实践指南

- 无服务器部署管理器:防止错误部署AWS帐户

- 医疗图标矢量素材合集:扁平风格16图标(PNG/EPS/PSD)

- 人工智能基础课程汇报PPT模板下载