Hadoop实战:HDFS环境配置与Eclipse使用指南

需积分: 0 163 浏览量

更新于2024-06-18

收藏 3.23MB PDF 举报

"该资源是一个关于Hadoop分布式文件系统(HDFS)的实验指导,主要介绍了如何在Ubuntu操作系统中使用Hadoop环境进行开发工作,包括设置用户环境、部署Eclipse IDE以及创建和运行Java项目。"

在Hadoop生态系统中,HDFS是一个关键组件,它设计用于存储和处理大规模数据集。这个实验PDF文档似乎是为了帮助初学者熟悉Hadoop开发环境的搭建和使用。以下是根据描述和部分内容提炼出的相关知识点:

1. **Hadoop用户与Ubuntu环境**:

- 在进行Hadoop相关操作时,建议使用专门的Hadoop用户,这有助于保持系统的权限管理和安全性。

- 将文件传输到Ubuntu的`/home/hadoop/Downloads`目录下,这是Hadoop用户的默认工作空间。

2. **软件安装**:

- 解压缩文件到`/usr/local`,这是一个常见的Linux目录,用于存放用户安装的应用程序。

- 使用`cd`命令进入解压后的文件夹,并启动Eclipse IDE,通过执行`./eclipse`指令来运行。

3. **Eclipse与Hadoop开发**:

- Eclipse作为Java开发IDE,也是Hadoop应用开发的常用工具。必须在Hadoop用户环境下启动,以确保Java环境变量正确设置。

- 默认的工作空间对Hadoop开发至关重要,因为它将包含项目的源代码和配置文件。

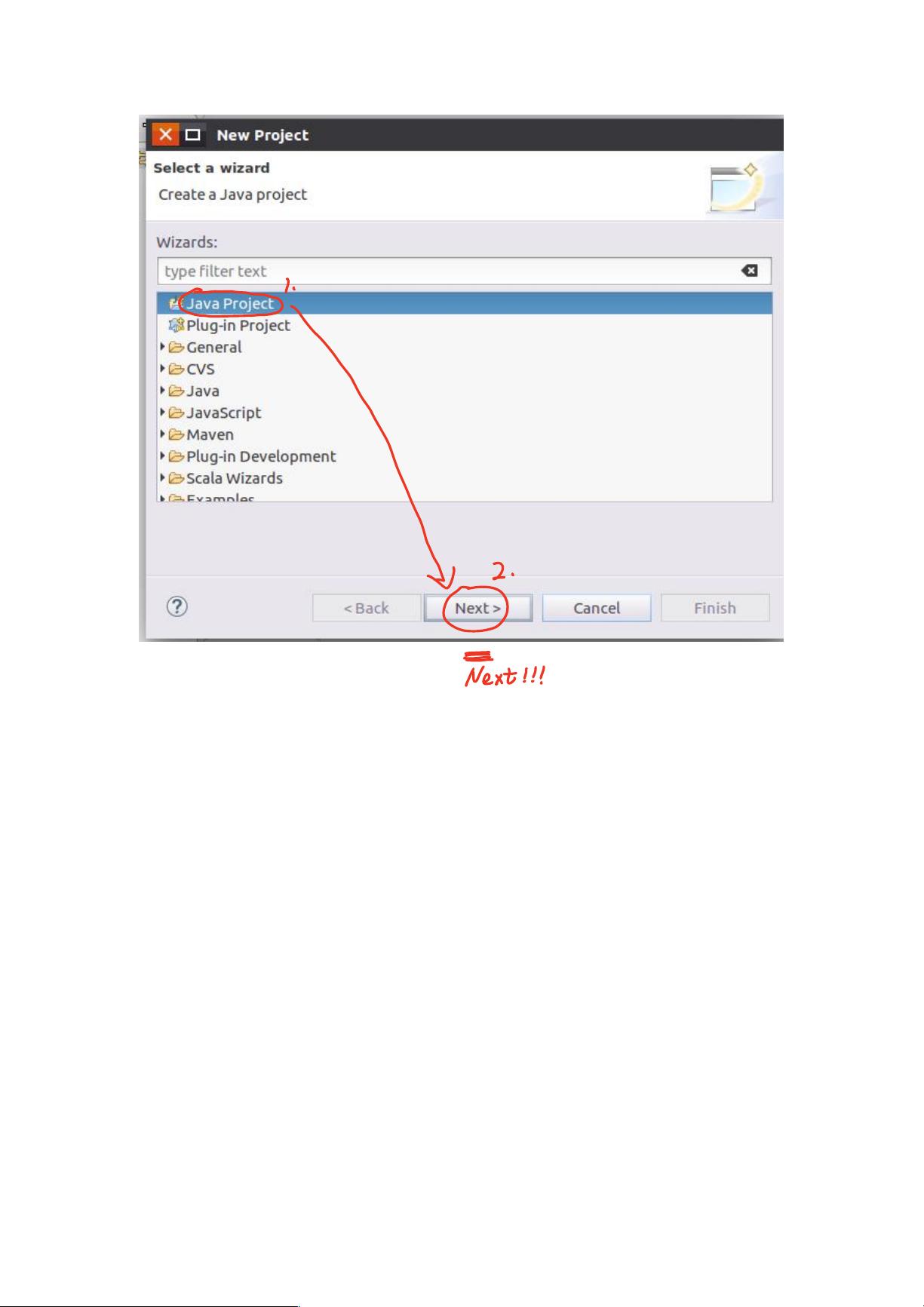

4. **创建Java项目**:

- 在Eclipse中新建Java项目,选择`Java Project`,并提供项目名称。

- 添加项目所需的库,这里可能指的是Hadoop相关的jar包,这对于编译和运行依赖Hadoop的Java代码是必要的。

5. **代码编写与运行**:

- 创建新的Java类,命名并使用默认配置。

- 编写案例代码,这可能涉及到读写HDFS文件、MapReduce操作或其他Hadoop API的使用。

6. **使用视角(Perspective)**:

- 当出现提示时,选择`Open Perspective`,这允许开发者在Eclipse中切换不同的视图,如Java视图或Hadoop视图,以适应不同的开发需求。

7. **编写与运行Java类**:

- 完成代码编写后,可以右键点击项目,选择编译和运行选项,以测试Hadoop程序。

通过这个实验,学习者可以逐步了解Hadoop开发环境的配置和使用,以及如何在Eclipse中创建和运行一个简单的Java项目。这对于理解和掌握Hadoop生态系统的基础知识至关重要。同时,这也强调了在正确环境中管理开发工作的重要性,特别是对于使用分布式系统的项目来说。

2022-01-09 上传

2022-12-23 上传

2022-12-23 上传

2022-12-23 上传

2022-12-23 上传

ZShiJ

- 粉丝: 1w+

- 资源: 55

最新资源

- diagwiz:ASCII图作为代码

- userscripts:一些改善UI的用户脚本

- bsu:FAMCS BSU(专业计算机安全)上用于大学实验室的资料库

- krip:彻底的简单加密,在后台使用WebCrypto

- 费用追踪器应用

- 111.zip机器学习神经网络数据预处理

- 财务管理系统

- NNet:用于手写识别的神经网络

- 加州阳光咖啡书吧创业计划书.zip

- Pricy - Amazon Price Watch-crx插件

- AMONG_py-0.0.3-py3-none-any.whl.zip

- MIUI12.5-其他:MIUITR Beta其他语言翻译

- SnowCat:薛定谔的猫

- AMD-1.2.1-py3-none-any.whl.zip

- Slider popover(iPhone源代码)

- 实现一个3D转盘菜单效果