CPU、GPU与CUDA、CuDNN详解:从概念到应用

需积分: 50 177 浏览量

更新于2024-07-16

收藏 3.41MB PDF 举报

"这篇文章是关于CPU、GPU以及与之相关的CUDA和CuDNN技术的简介。作者 FrankJingle 在2016年12月30日发布,讨论了CPU和GPU的不同特性以及它们在计算任务中的应用。"

在计算机硬件领域,CPU(中央处理器)和GPU(图形处理器)扮演着至关重要的角色。CPU作为系统的核心,通常具有较少但功能强大的核心,配备大容量的缓存,擅长处理复杂的计算任务和逻辑控制,如分布式计算、人工智能和物理模拟。相反,GPU拥有大量的简单核心,设计初衷是为了处理图形渲染任务,尤其擅长执行大规模并行计算,如在视频游戏中对大量像素进行相同的处理。

随着技术的发展,GPU逐渐发展成为通用计算设备,即GPGPU(通用图形处理器)。例如,NVIDIA的Fermi架构就包含了512个核心,适合处理需要大量数据吞吐的任务,通过增加并行处理能力来减少整体计算时间,而非优化单个任务的延迟。

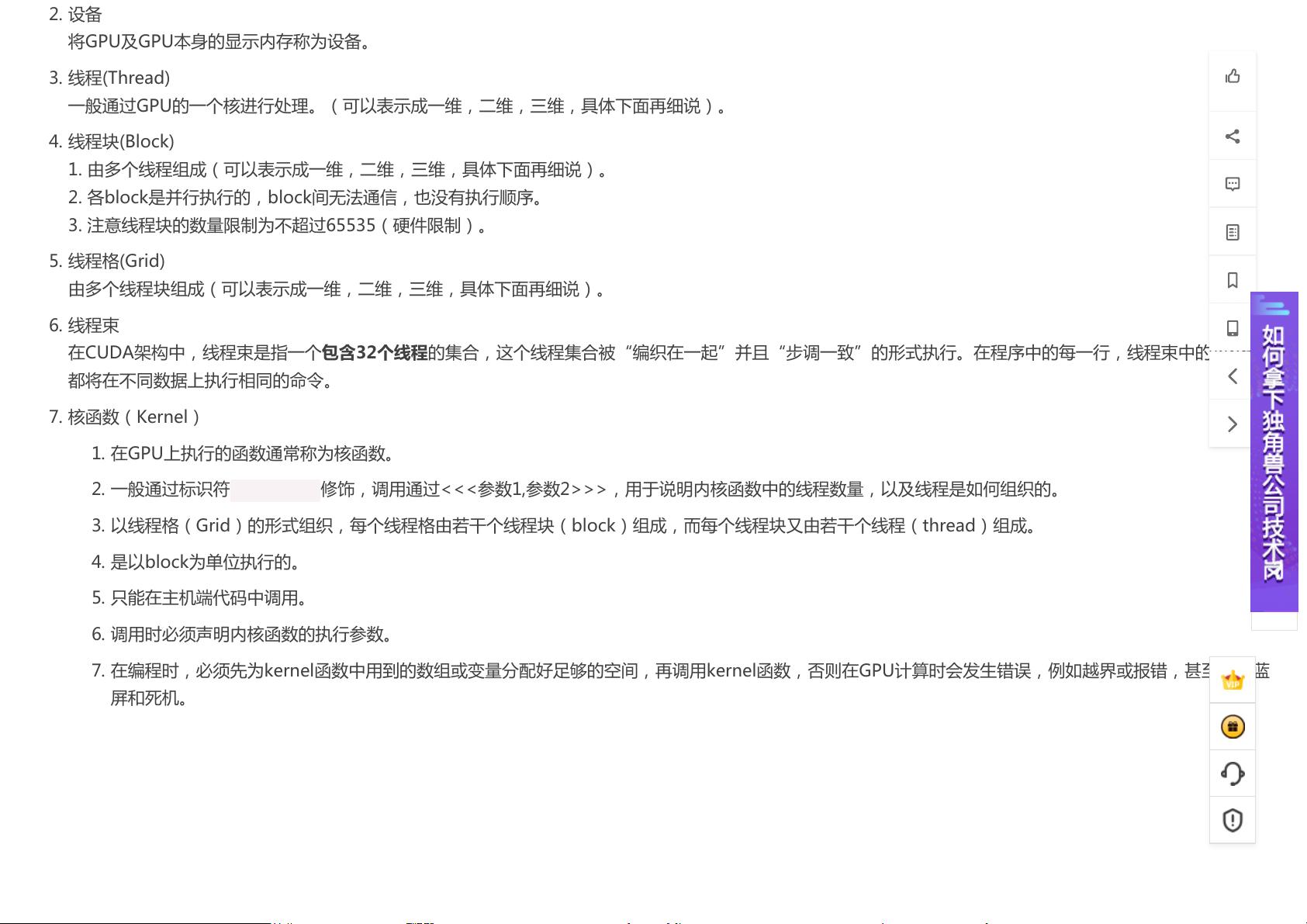

CUDA(Compute Unified Device Architecture)是由NVIDIA开发的一种并行计算平台和编程模型,它允许开发者使用C、C++、Fortran等语言直接编写能够充分利用GPU计算能力的程序。CUDA提供了对GPU硬件的低级访问,使得科学家和工程师能够在科学计算、机器学习、图像处理等领域实现性能的大幅提升。

CuDNN(Convolutional Neural Network Library)是NVIDIA为深度学习专门设计的库,它是CUDA生态系统的一部分。CuDNN加速了卷积神经网络(CNN)的计算过程,包括卷积、池化、激活和归一化等操作。这使得在GPU上训练和部署深度学习模型变得更加高效,极大地推动了人工智能和计算机视觉的进步。

CPU和GPU各有优势,CPU擅长逻辑控制和复杂计算,而GPU则在并行处理和大数据吞吐方面表现出色。CUDA和CuDNN这样的工具进一步拓宽了GPU的应用范围,尤其是在高性能计算和深度学习领域。理解这些概念对于任何想要深入研究计算机硬件性能和优化计算效率的IT专业人士来说都是至关重要的。

2017-03-21 上传

2020-11-11 上传

2023-02-08 上传

137 浏览量

2023-09-21 上传

2024-04-13 上传

huxizhong2017

- 粉丝: 3

- 资源: 96

最新资源

- PureMVC AS3在Flash中的实践与演示:HelloFlash案例分析

- 掌握Makefile多目标编译与清理操作

- STM32-407芯片定时器控制与系统时钟管理

- 用Appwrite和React开发待办事项应用教程

- 利用深度强化学习开发股票交易代理策略

- 7小时快速入门HTML/CSS及JavaScript基础教程

- CentOS 7上通过Yum安装Percona Server 8.0.21教程

- C语言编程:锻炼计划设计与实现

- Python框架基准线创建与性能测试工具

- 6小时掌握JavaScript基础:深入解析与实例教程

- 专业技能工厂,培养数据科学家的摇篮

- 如何使用pg-dump创建PostgreSQL数据库备份

- 基于信任的移动人群感知招聘机制研究

- 掌握Hadoop:Linux下分布式数据平台的应用教程

- Vue购物中心开发与部署全流程指南

- 在Ubuntu环境下使用NDK-14编译libpng-1.6.40-android静态及动态库