深度学习性能提升:初始化策略与Python实现

需积分: 0 42 浏览量

更新于2024-08-05

收藏 818KB PDF 举报

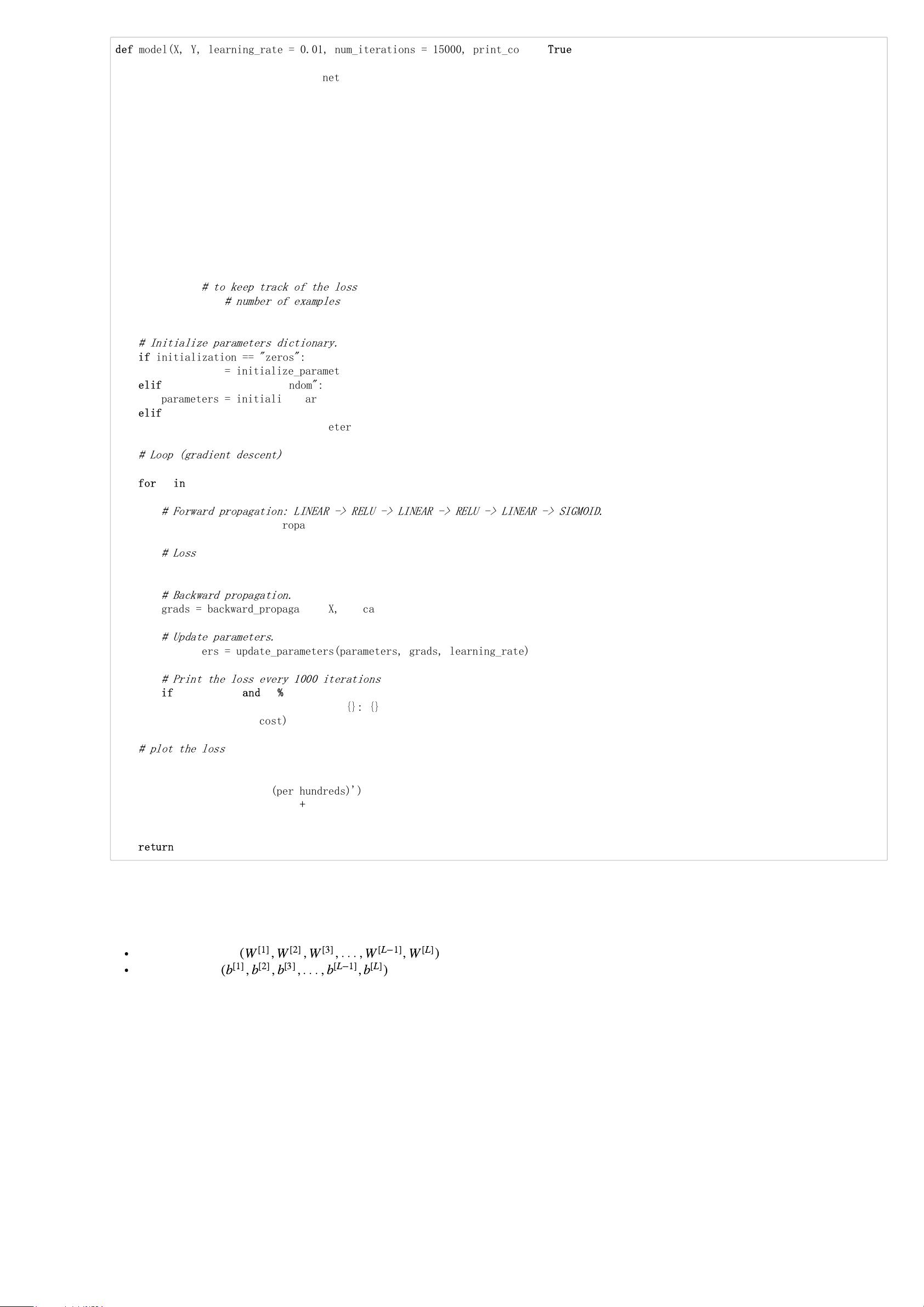

"本文介绍了提高深度神经网络性能的关键因素之一——权重初始化,并详细讲解了零初始化、随机初始化、He初始化和Xavier初始化等方法的原理及其优缺点。"

在深度学习中,权重初始化对于网络的训练效果至关重要。不同的初始化策略会影响到神经网络的训练速度和最终的模型性能。首先,我们来探讨零初始化。零初始化所有权重,虽然简单,但会导致前向传播和反向传播过程中对称性的问题,使得神经元间的差异消失,从而减弱了网络的学习能力。

接下来是随机初始化,它通过赋予权重随机值打破对称性,允许网络进行有效的学习。然而,当网络层次加深,随机初始化可能会引发梯度消失或梯度爆炸的问题。梯度消失主要与sigmoid等激活函数有关,它们的导数在饱和区接近于零,导致深层网络的梯度非常小,影响浅层权重的更新。相反,梯度爆炸则是因为初始权重过大,导致前向传播过程中各层变化过快,权重更新过于剧烈。

为了解决这些问题,He初始化和Xavier初始化应运而生。He初始化是由He等人提出的,特别针对ReLU激活函数设计。它建议权重初始化为随机值后除以输入维度的平方根,这有助于保持每一层的输入激活值在适当范围内,减少梯度爆炸的风险,同时保持足够的梯度流过深层网络。

Xavier初始化,又称为均匀初始化,是由Glorot和Bengio提出的。它与He初始化类似,不过考虑的是输入和输出维度的平均值,即权重初始化为随机值后除以输入和输出维度的均值的平方根。这种初始化方法旨在保持前向传播和反向传播的信号强度稳定,适用于非线性激活函数,如tanh和sigmoid。

在实际应用中,选择哪种初始化方法通常取决于网络结构和激活函数。对于使用ReLU的网络,He初始化通常表现更好,而对于sigmoid或tanh,Xavier初始化可能更为合适。当然,随着深度学习研究的发展,还有其他如Kaiming初始化、Orthogonal初始化等方法,它们都是为了优化网络训练的效率和效果。

权重初始化是深度学习中不可忽视的一部分,合理的初始化策略能够有效缓解梯度消失和梯度爆炸问题,提高网络的训练能力和泛化性能。在实践中,需要根据具体任务和网络架构来选择最合适的初始化方法。

2023-06-24 上传

2022-08-03 上传

2021-03-18 上传

2023-07-19 上传

2024-04-22 上传

2021-07-06 上传

2021-05-30 上传

2023-12-28 上传

2021-07-06 上传

有只风车子

- 粉丝: 38

- 资源: 329

最新资源

- ES管理利器:ES Head工具详解

- Layui前端UI框架压缩包:轻量级的Web界面构建利器

- WPF 字体布局问题解决方法与应用案例

- 响应式网页布局教程:CSS实现全平台适配

- Windows平台Elasticsearch 8.10.2版发布

- ICEY开源小程序:定时显示极限值提醒

- MATLAB条形图绘制指南:从入门到进阶技巧全解析

- WPF实现任务管理器进程分组逻辑教程解析

- C#编程实现显卡硬件信息的获取方法

- 前端世界核心-HTML+CSS+JS团队服务网页模板开发

- 精选SQL面试题大汇总

- Nacos Server 1.2.1在Linux系统的安装包介绍

- 易语言MySQL支持库3.0#0版全新升级与使用指南

- 快乐足球响应式网页模板:前端开发全技能秘籍

- OpenEuler4.19内核发布:国产操作系统的里程碑

- Boyue Zheng的LeetCode Python解答集