多模态综述:从VQA到Transformer的演进

需积分: 0 79 浏览量

更新于2024-06-30

收藏 4.56MB PDF 举报

"从VQA到多模态综述 Survey v21,这是一个关于视觉问答(VQA)任务的深入调研,涵盖了VQA的发展、数据集、主要模型和Transformer的最新应用。作者对VQA任务进行了全面概述,并引用了多个相关的论文和资料。"

在计算机视觉(CV)和自然语言处理(NLP)的交叉领域,VQA任务显得尤为重要。它旨在构建一种智能系统,能够针对输入的图像提供准确的问题答案。VQA的答案形式多样,可以是单个词、短语、二选一的答案、多项选择或填空。这个任务的核心挑战在于理解和整合两种不同模态的信息,即图像和文本。

在CV领域,卷积神经网络(CNN)是图像处理的基础,它的发展催生了如VGGNet、Inception和ResNet等一系列先进模型。这些模型在图像识别和特征提取方面表现出色,为VQA任务提供了强大的图像理解能力。而NLP领域,随着RNN、LSTM和GRU等序列模型的发展,再到Transformer的出现,语言模型的性能得到了显著提升,尤其是Transformer,其自注意力机制在处理序列数据时展现出强大优势,不仅在机器翻译、文本生成等领域取得了突破,也逐渐被引入到VQA任务中。

Transformer的引入极大地改善了模型处理多模态信息的能力。Transformer的并行计算特性使其在处理长序列时比RNN更高效,同时,其自注意力机制能有效地捕捉到图像和文本之间的远距离依赖关系。例如,在VQA任务中,Transformer可以同时关注到图像的各个区域和问题的每个词,从而更精确地理解问题和寻找答案。

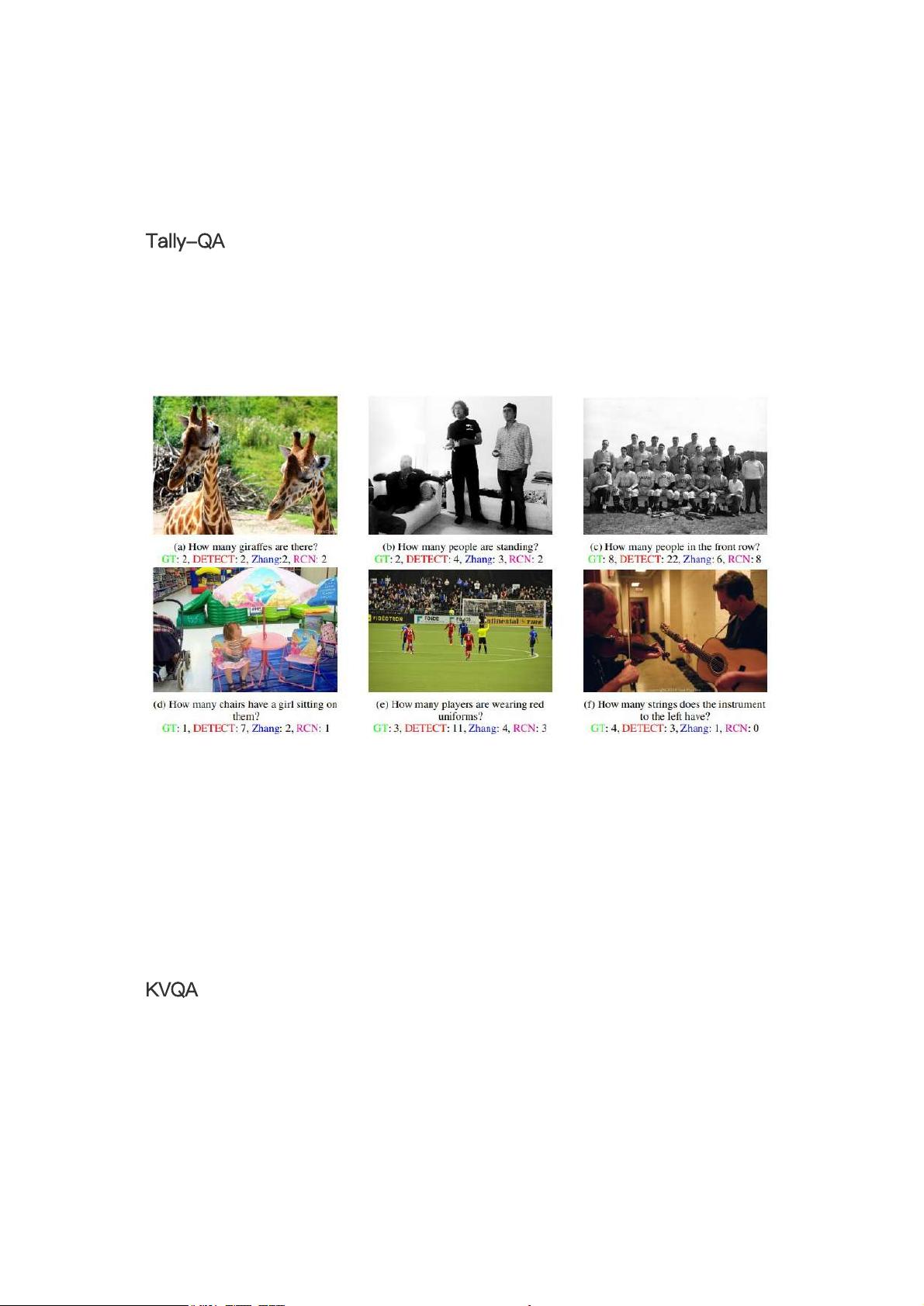

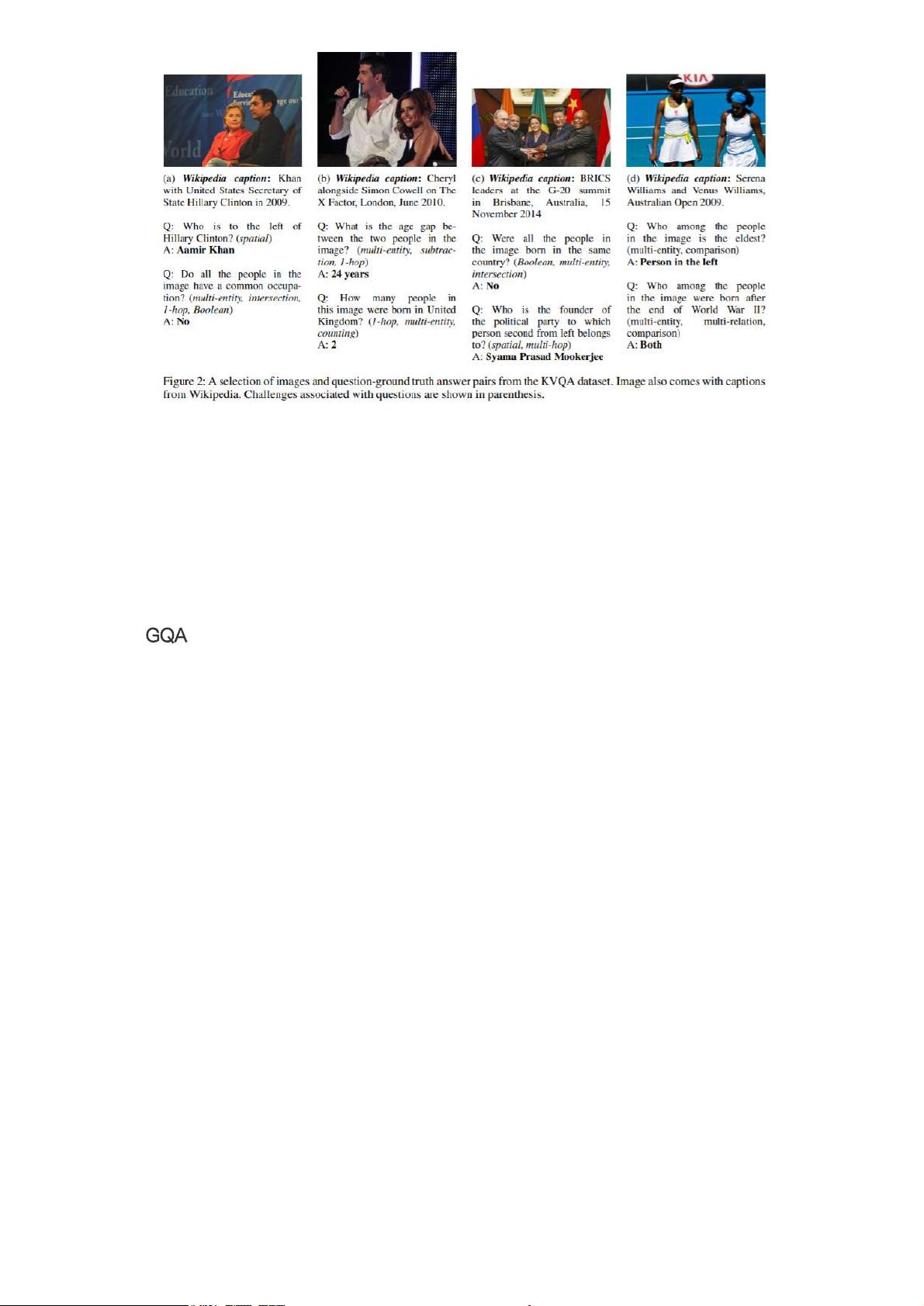

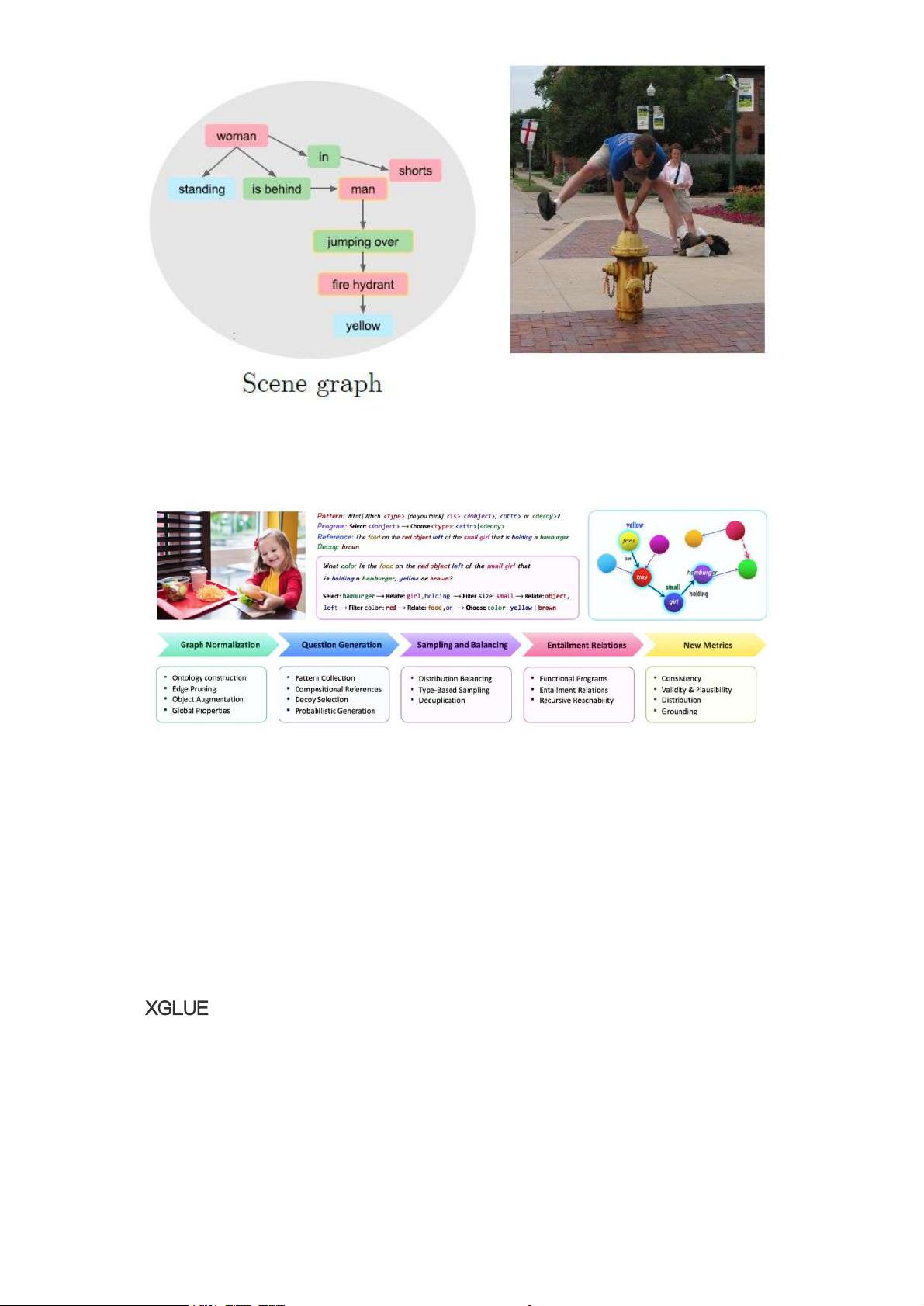

VQA任务的相关数据集是推动研究的关键。早期的数据集如MS COCO、DAQUAR等促进了VQA的初期研究。随着时间的推移,数据集变得更为复杂,如VQAv2引入了更多的开放性问题,GQA则强调了逻辑推理能力。这些数据集不仅增加了任务的挑战性,还推动了模型从简单记忆向深度理解转变。

此外,随着XGLUE等多模态任务集合的出现,VQA不再局限于单一的任务形式,而是扩展到包含视觉推理、图像文本匹配等多个相关领域,这进一步推动了多模态研究的发展。

VQA任务的进展反映了CV和NLP领域的融合,Transformer等技术的引入则为解决这一跨学科问题提供了新的视角和工具。未来,随着更多复杂数据集的出现和模型的优化,VQA及其相关的多模态研究将继续推动人工智能向着更高级别的认知理解迈进。

2024-12-25 上传

2024-12-25 上传

乐居买房

- 粉丝: 25

- 资源: 311

最新资源

- ROCKKE

- ghidra-r2web:Ghidra插件启动r2网络服务器以使r2与之交互

- 3943621,c语言挂号系统文件源码,c语言

- chromedriver-mac-arm64-V124.0.6367.91 稳定版

- 黑色模块化企业网站模板

- 1000km Fund Status-crx插件

- webpages

- bssg:用bash编写的静态站点生成器。 您可以在以下网址中查看结果

- MenuChef::hamburger:像厨师一样制作汉堡菜单

- Python库 | compost-0.2.4.zip

- bqezdls,c语言mp3播放器源码,c语言

- chromedriver-mac-V124.0.6367.91 稳定版

- [removed]我学习JavaScript时的一些项目

- Pigeon_Infinity_django

- Banking-System:基本银行系统,具有一些基本功能,包括创建用户,汇款和交易历史记录。 它也包括数据库

- gmailbackup:备份您的Gmail InboxArchive