RedHat Linux 9.0中Hadoop单机配置教程

版权申诉

171 浏览量

更新于2024-08-16

收藏 145KB PDF 举报

"RedHat Linux 9.0 下的 Hadoop 单机配置指南主要涵盖了 Hadoop 的获取、安装前提以及详细安装步骤。这份文档适用于在 Red Hat Linux 9.0 环境中进行 Hadoop 的单机配置,旨在帮助用户理解并执行必要的配置工作。"

在开始配置 Hadoop 之前,你需要了解以下几个关键知识点:

1. Hadoop 获取:

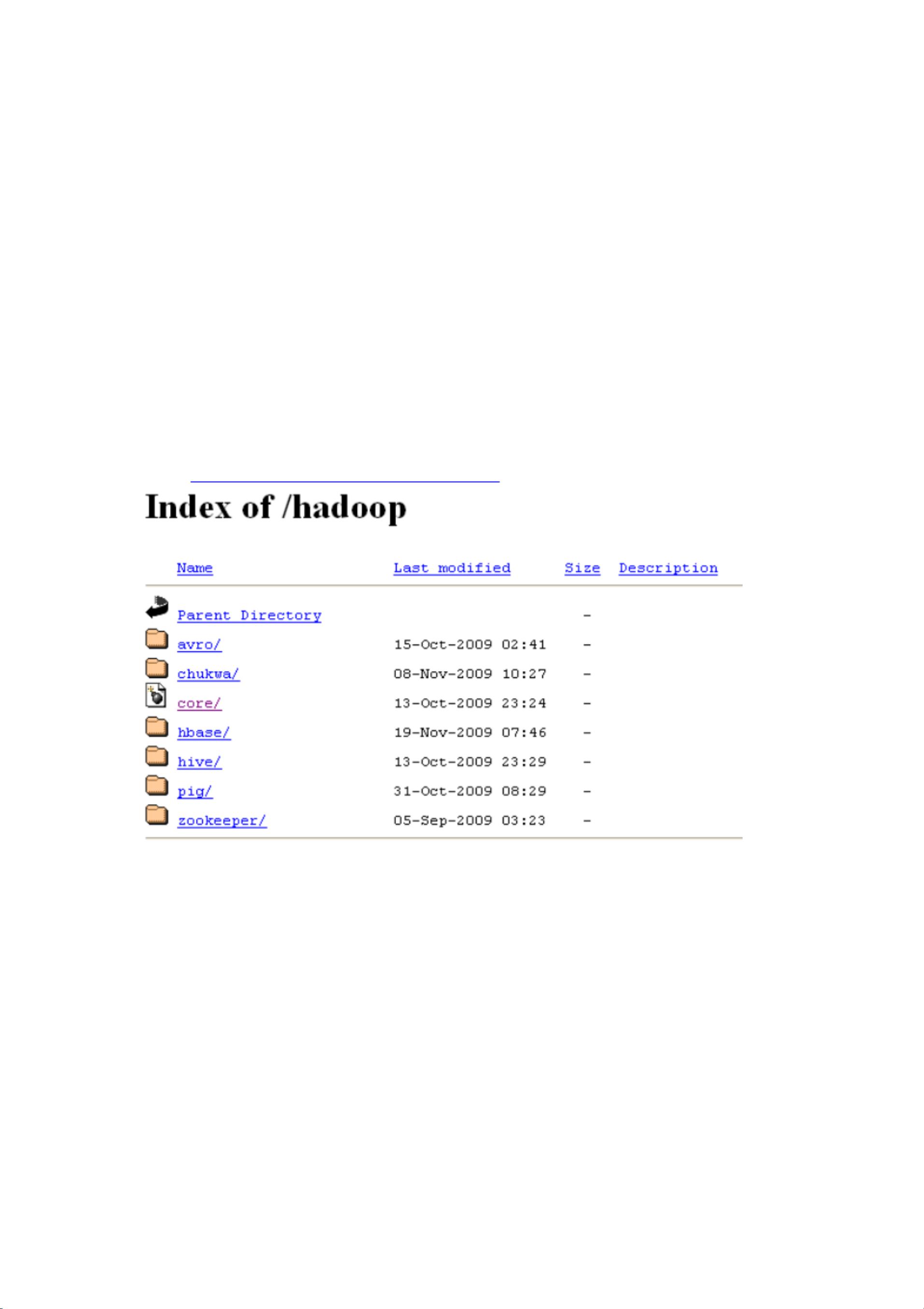

Hadoop 是一个分布式计算框架,包括核心组件和其他子项目如 HBase 和 Hive。你可以从 Apache 官方网站(http://apache.freelamp.com/hadoop/)下载 Hadoop,该网站提供了不同版本的 Hadoop 供用户选择。

2. Hadoop 安装前提:

- Java:Hadoop 运行的必备条件是 Java 1.5.x 或更高版本。建议使用 Sun 公司的官方版本,并确保它与你的操作系统(32/64 位)兼容。

- SSH (Secure Shell):SSH 用于远程节点之间的通信。在 Red Hat Linux 9.0 中,SSH 通常是预装的,可以通过 `rpm -q openssh-server` 命令检查版本。同时,需要设置 SSH 在系统启动时自动启动,这可以通过 `ntsysv` 命令实现。启动和停止 SSH 服务的命令分别是 `/etc/init.d/sshd start` 和 `/etc/init.d/sshd stop`。对于非 Red Hat Linux 系统的用户,可以在 OpenSSH 网站上找到相应的安装指南。

- Cygwin:如果你在 Windows 上运行 Hadoop,需要先安装 Cygwin,然后再安装 openssh 包,以模拟 Unix-like 环境。

3. 网络要求:

由于 Hadoop 需要在节点间通过 SSH 进行通信,所以所有参与 Hadoop 集群的节点之间必须有畅通的网络连接。

4. 详细安装过程:

虽然具体的安装步骤未在摘要中详细列出,但通常包括以下几个阶段:

- 解压 Hadoop 压缩包到指定目录。

- 配置环境变量,如 `HADOOP_HOME` 和 `PATH`。

- 修改 Hadoop 配置文件,例如 `core-site.xml`、`hdfs-site.xml` 和 `yarn-site.xml`,设置相关的参数,如数据存储路径、名称节点等。

- 初始化 HDFS 文件系统,可能需要运行 `hdfs namenode -format` 命令。

- 启动 Hadoop 服务,如 DataNode、NameNode 和 NodeManager。

5. 注意事项:

在配置过程中,务必根据自己的具体环境调整配置文件中的参数。例如,如果是单机配置,Hadoop 可能需要运行在伪分布式模式(`-local` 或 `-fs本地`)。此外,确保所有的配置文件正确无误,避免出现权限或路径错误。

这份文档将引导你在 Red Hat Linux 9.0 系统上完成 Hadoop 的安装和配置,这对于学习和实践 Hadoop 分布式计算框架至关重要。请仔细遵循指南中的步骤,并随时准备解决可能出现的问题。

655 浏览量

点击了解资源详情

点击了解资源详情

2021-11-23 上传

2021-10-08 上传

2021-12-01 上传

2022-01-07 上传

2021-10-01 上传

dtd13961139571

- 粉丝: 1

- 资源: 6万+

最新资源

- chat-app-master

- MAST-MOBILE:MAST Android应用程序源代码-Android application source code

- nanodegree-p3-classic-arcade-game:nanodegree-p3-classic-arcade-game

- Just_Java-app:这是我的第一拳Android项目,通过该项目,我通过Just Java应用程序了解了android的各种基础知识

- SIXSIGMA六标准差——教练级黑带师、黑带、绿带培训方案

- 数据营项目

- tool-conventions:支持使用WebAssembly的工具之间的互操作性的约定

- learn-bootstrap:这个 repo 是为我创建的,用于通过 tutorialls 学习引导程序

- FitJournal:Fit Journal应用程序的源代码-Android application source code

- 计时器

- 金融筹资管理

- thunderboard-android:这是Android的Thunderboard应用程序的源代码-Android application source code

- 网址缩短API登陆页面

- silverstripe-email_reminder:Silverstripe CMS的模块。 在用户的成员资格(或类似权限)即将到期时向用户发送提醒

- nodeschool.io:我对 NodeSchool.io 练习的解决方案

- ASCII-ART:产生与图像相对应的ASCII符号