Python实现KNN算法与Kd树详解

17 浏览量

更新于2024-08-31

收藏 395KB PDF 举报

"Python语言描述KNN算法与Kd树,主要介绍了如何在Python中实现KNN算法以及利用Kd树优化搜索过程,适用于数据分析和机器学习领域的初学者参考。"

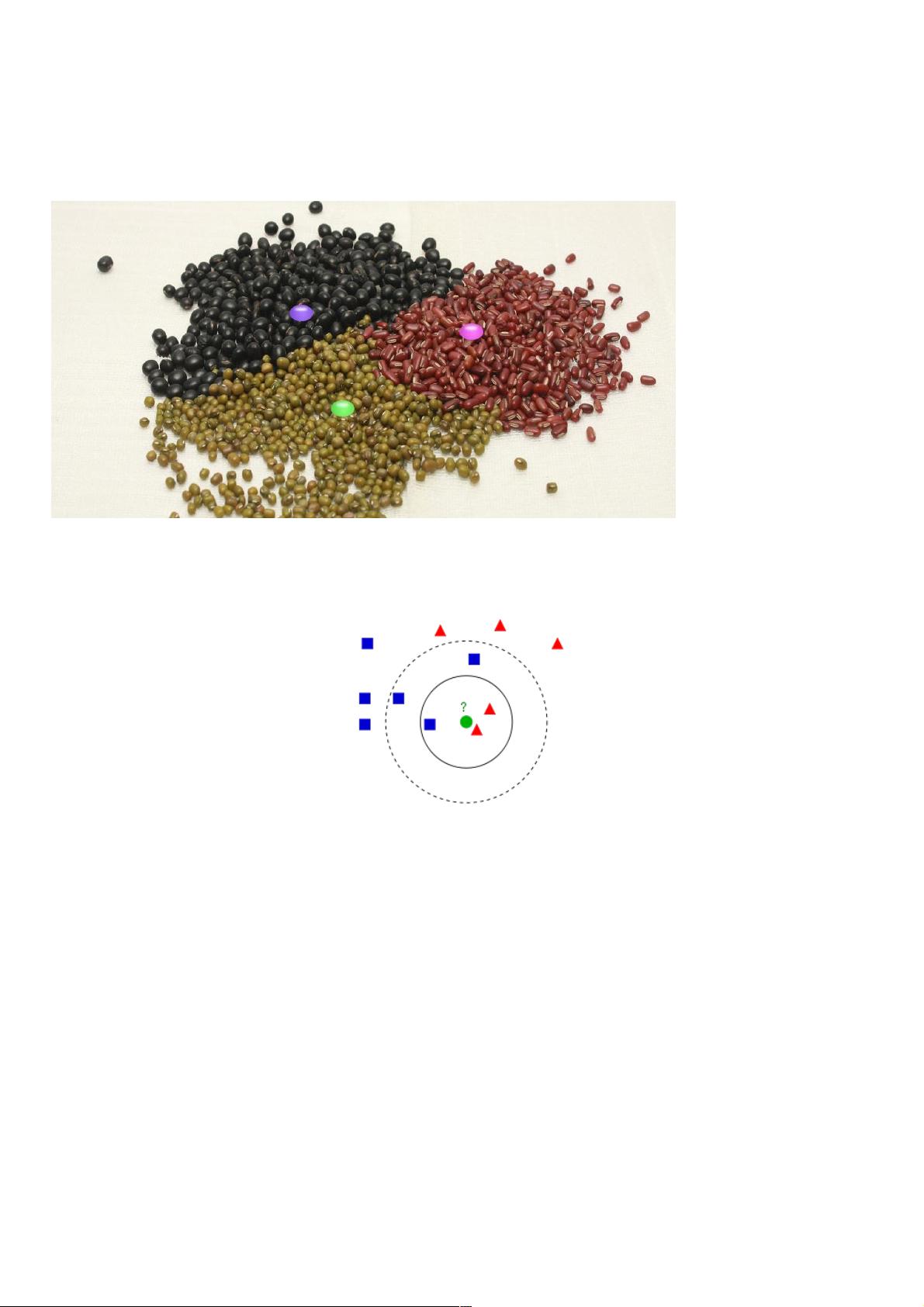

KNN(K-Nearest Neighbors)算法是一种基础且实用的监督学习方法,常用于分类和回归任务。它的核心思想是基于“物以类聚”的原则,通过寻找测试样本最接近的K个训练样本,然后根据这K个样本的类别进行投票来决定测试样本的类别。在Python中,KNN算法可以通过scikit-learn库轻松实现。

KNN算法的主要步骤如下:

1. 计算距离:计算测试样本与训练集中每个样本之间的距离。常用的度量方式有欧几里得距离、曼哈顿距离和余弦相似度等。

2. 选择K值:选择一个合适的K值,K值的大小会直接影响分类效果。较小的K值可能导致过拟合,而较大的K值可能会使模型过于保守,对噪声不敏感。

3. 找到最近邻:根据距离排序,选择距离测试样本最近的K个训练样本。

4. 类别投票:统计这K个样本的类别,选择出现次数最多的类别作为测试样本的预测类别。

在实际应用中,KNN算法面临的一个问题是计算效率,特别是当数据集非常大时,计算所有样本的距离可能会非常耗时。这时,可以引入数据结构如Kd树(K-dimensional tree)来优化这个过程。Kd树是一种空间分割数据结构,特别适合在高维空间中快速查找最近邻。通过构建Kd树,可以将搜索时间从O(n)降低到O(log n),大大提高算法的效率。

在Python中实现KNN算法和Kd树,可以使用scikit-learn库的`KNeighborsClassifier`或`KDTree`类。例如:

```python

from sklearn.neighbors import KNeighborsClassifier, KDTree

# 假设X是特征数据,y是对应的类别

X_train, y_train = create_dataset()

X_test = predict_samples()

# 创建KNN分类器,设置K值

knn = KNeighborsClassifier(n_neighbors=K)

# 使用KDTree加速KNN

tree = KDTree(X_train)

# 训练模型

knn.fit(X_train, y_train)

# 预测

distances, indices = tree.query(X_test, k=K)

predicted_labels = knn.predict_proba(indices)

# 输出预测结果

print(predicted_labels)

```

在上述代码中,`KNeighborsClassifier`用于创建KNN分类器,`KDTree`则用于构建Kd树并进行最近邻搜索。`query`方法用于在Kd树中查找最近邻,返回距离和对应的训练样本索引。

KNN算法结合Kd树的使用,可以在保持预测准确性的同时提高处理大规模数据的效率,是Python中进行分类任务时的一种重要工具。理解KNN的工作原理以及如何在Python中高效实现,对于从事数据科学和机器学习工作的人来说是必备的技能之一。

2022-10-10 上传

点击了解资源详情

点击了解资源详情

2020-12-24 上传

2020-09-20 上传

2016-10-13 上传

2018-02-21 上传

2020-09-20 上传

weixin_38607088

- 粉丝: 5

- 资源: 920

最新资源

- discBot

- accesslist:在渗透测试中使用的多种类型的列表的集合,收集在一个地方。 列表类型包括用户名,密码,组合,单词列表等等。

- Technologieplauscherl-Steyr:在斯太尔展示 Technologieplauscherl

- practice-code:来自各种竞争平台的Java中用于设计模式的代码

- 2021“昇腾杯”遥感影像智能处理算法大赛——语义分割赛道,冠军方案.zip

- spate141

- PositioningandFloatingElements:一种使用HMTL和CSS知识以及最近学习的float元素的实践

- Learn-Chess-Commentary

- Python库 | genomedata-1.1.0-py2.5.egg

- areddy831.github.io:按建筑风格对图像进行分类

- seash:Rust中的最小外壳

- 课程测试

- gatsby-starter-styleguide:根据您的主题UI配置立即创建样式指南页面。 零配置-只需安装主题并查看以精美的方式显示的主题UI配置

- 使用循环【迭代】来进行转化数字为中文

- ArduinoPlusPlus:无需编程即可编程arduino

- snappy:Ruby的libsnappy绑定