视觉SLAM基础:从原理到实践

需积分: 0 10 浏览量

更新于2024-07-07

3

收藏 7.02MB PDF 举报

"2-高翔:视觉SLAM基础知识.pdf"

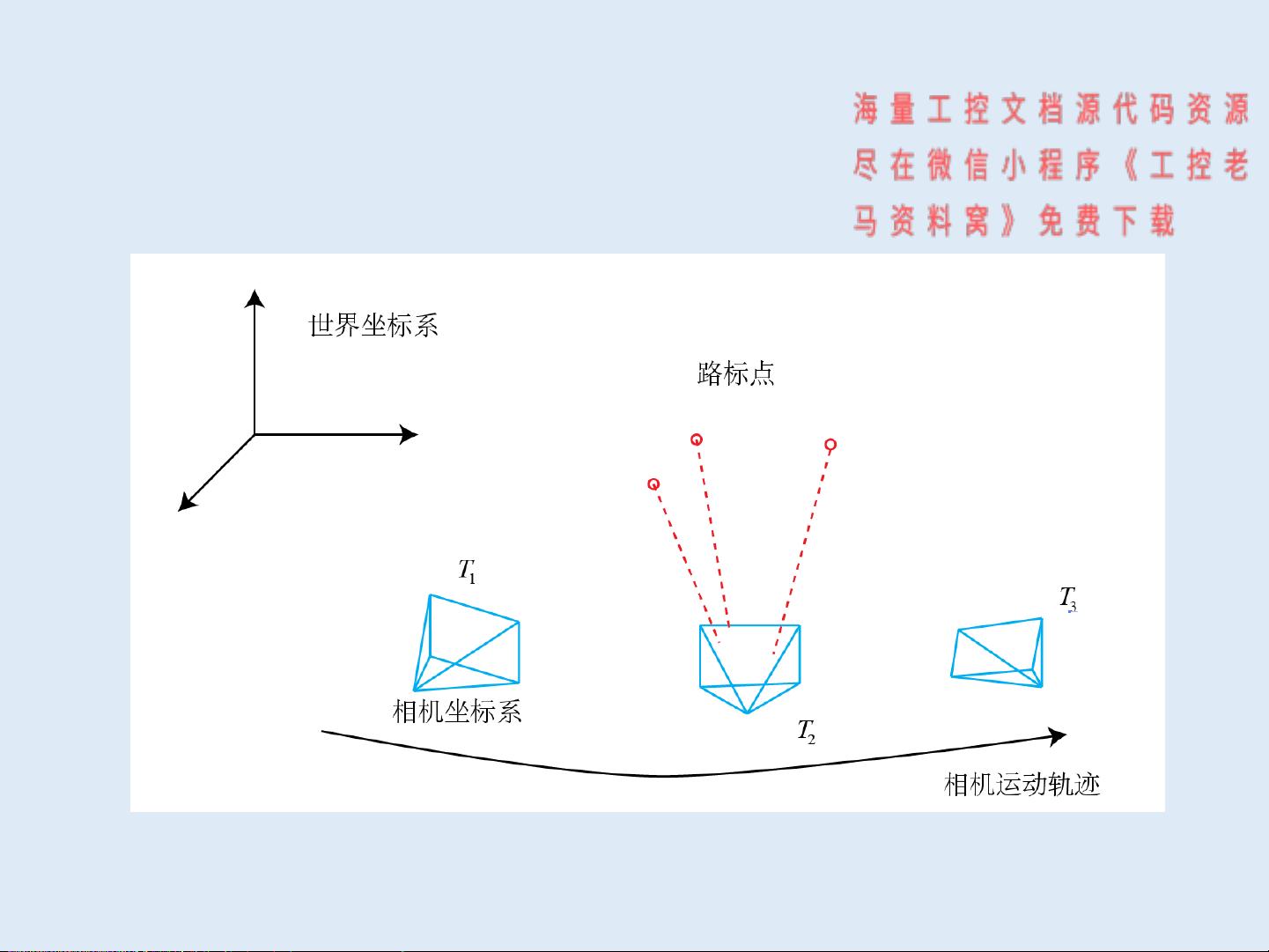

本文主要介绍了视觉SLAM(Simultaneous Localization and Mapping)的基础知识,由清华大学自动化系的高翔(半闲居士)于2016年8月撰写。视觉SLAM是机器人技术、无人机、AR/VR和智能硬件等领域中的关键问题,它涉及到机器人如何同时定位自身和构建环境地图。

1. 视觉SLAM概述

SLAM是指机器人在未知环境中同时进行自我定位和地图构建的过程。这一过程可以分为两个方面:内在的自我定位(Where am I?)和对外部环境的理解(Where am I?)。为了实现SLAM,机器人通常利用内部传感器,如激光、视觉、IMU(惯性测量单元)、轮速计等,以及外部传感器,如GPS、导轨、标志物等。内部传感器虽有较大噪声,但不依赖特定环境,而外部传感器则更直接,但可能受到环境因素的影响。视觉SLAM因其传感器的便携性、信息丰富度和较低的成本而受到重视,但也面临计算量大、环境干扰等问题。

2. 视觉传感器类型

视觉SLAM根据使用的传感器类型可分为单目、双目、RGB-D等。单目视觉SLAM成本低,但存在尺度不确定性及初始化问题;双目视觉SLAM能计算深度信息,但计算量大且配置复杂;RGB-D传感器能主动测量深度,重建效果好,但测量范围有限且易受日光和材质干扰。

3. 视觉SLAM过程

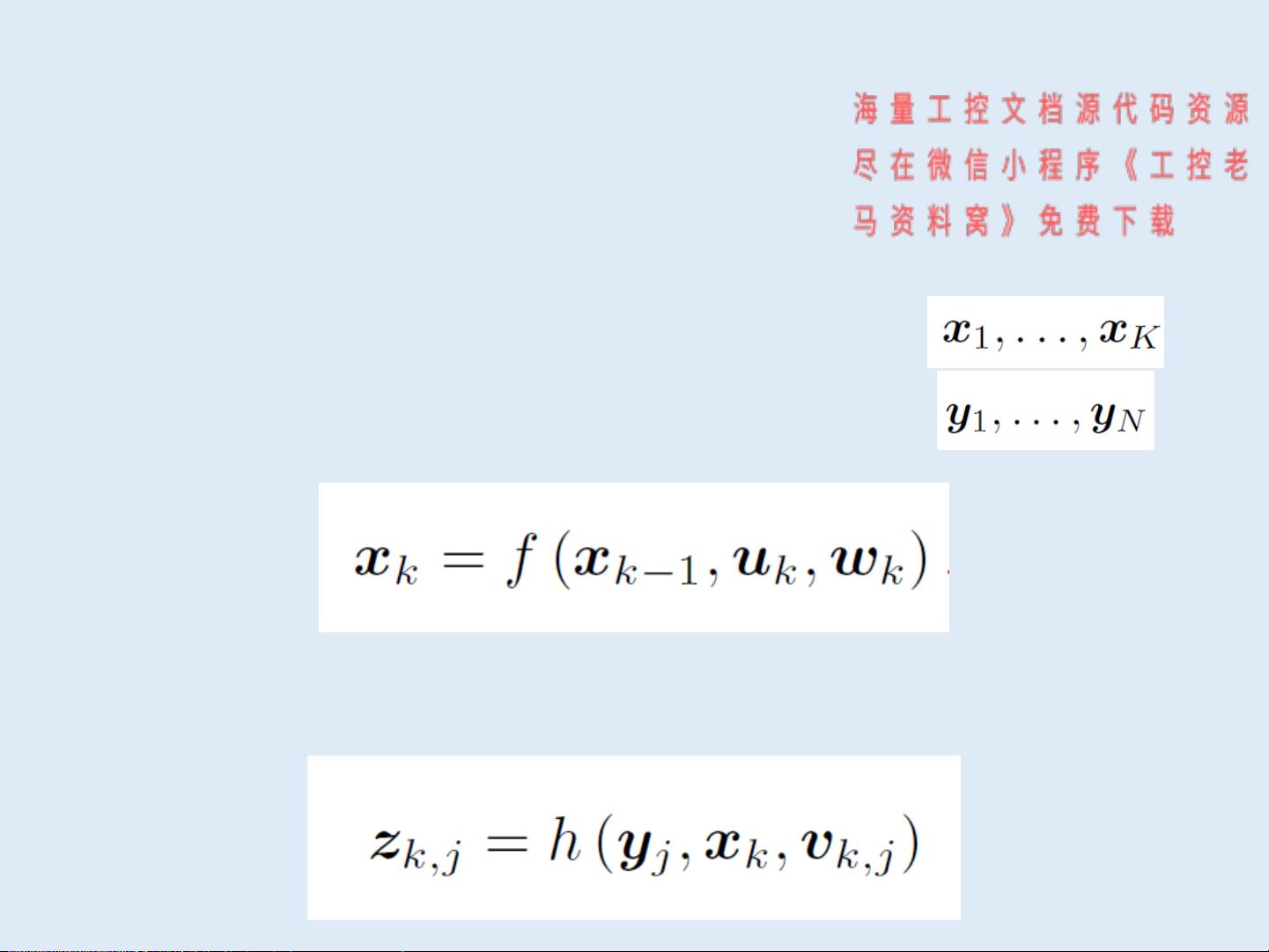

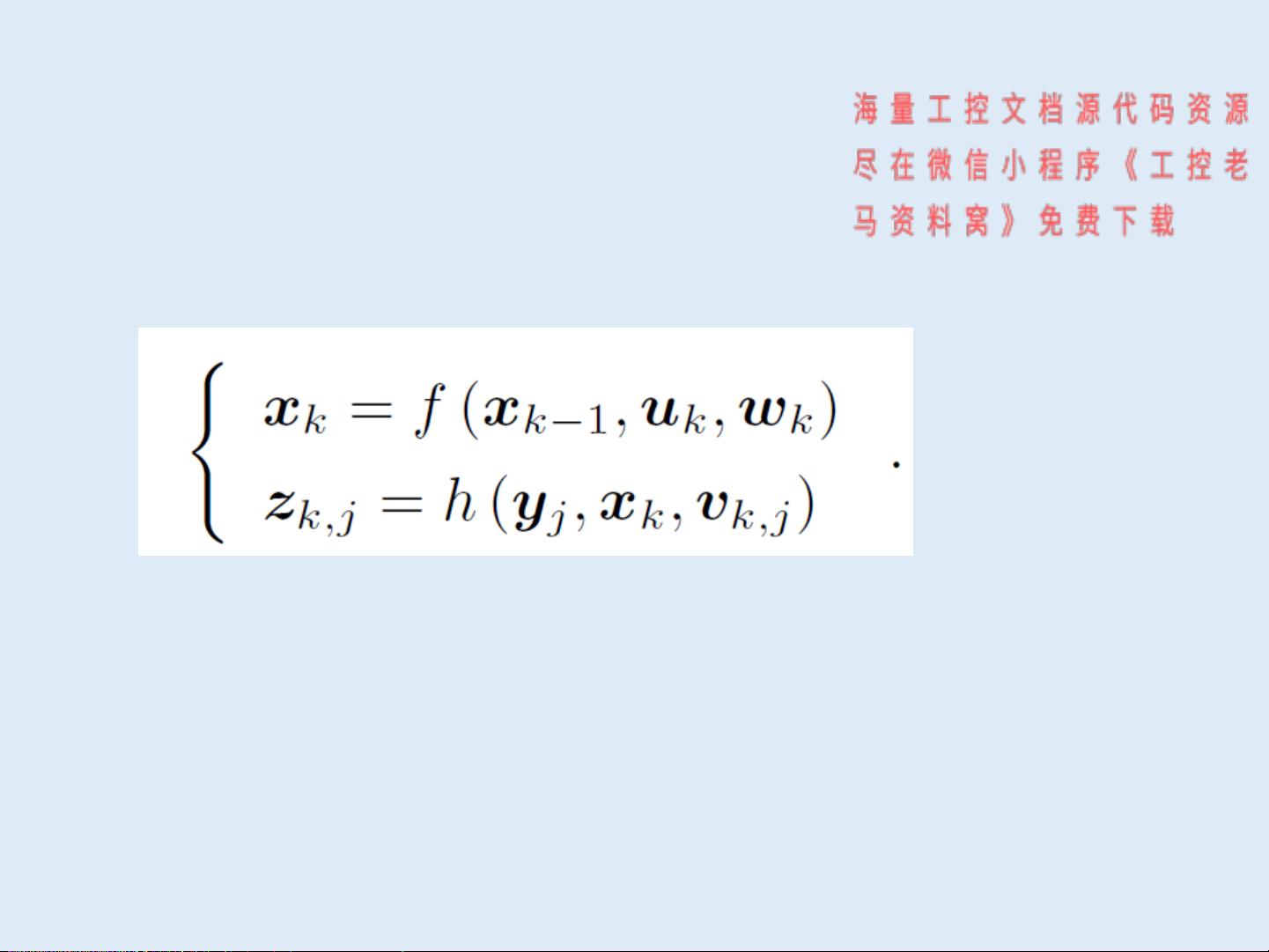

视觉SLAM的基本流程包括传感器获取图像、特征提取、运动估计、地图构建和后端优化等步骤。经典的SLAM数学模型涉及运动模型和观测模型,其中相机位姿用三维空间的旋转和平移表示,观测模型则基于相机投影原理。

4. SLAM数学模型

SLAM的数学模型涉及到机器人轨迹、路标点、运动输入和观测数据。视觉SLAM的特点在于,位姿表示需要用到李群与李代数,而观测模型基于相机投影模型,这使得视觉SLAM在理论和算法实现上比一般SLAM更为复杂。

5. 其他关键概念

除了上述内容,视觉SLAM还包括视觉里程计(用于连续估计机器人位姿)、后端优化(对前期估计进行全局优化,减少累积误差)、回环检测(识别和纠正重复场景引起的定位错误)等关键环节。这些组件共同构成了一个完整的视觉SLAM系统,旨在提供准确、鲁棒的机器人定位和环境映射能力。

视觉SLAM是机器人自主导航的关键技术,它融合了计算机视觉、传感器融合、概率推理等多个领域的知识,对于理解机器人如何在未知环境中行动具有重要意义。随着技术的发展,视觉SLAM的研究将继续推动无人驾驶、增强现实等前沿领域的发展。

2022-08-04 上传

2021-05-13 上传

255 浏览量

2018-12-15 上传

2018-11-29 上传

2023-10-27 上传

2024-12-18 上传

工控老马

- 粉丝: 697

- 资源: 2561

最新资源

- PureMVC AS3在Flash中的实践与演示:HelloFlash案例分析

- 掌握Makefile多目标编译与清理操作

- STM32-407芯片定时器控制与系统时钟管理

- 用Appwrite和React开发待办事项应用教程

- 利用深度强化学习开发股票交易代理策略

- 7小时快速入门HTML/CSS及JavaScript基础教程

- CentOS 7上通过Yum安装Percona Server 8.0.21教程

- C语言编程:锻炼计划设计与实现

- Python框架基准线创建与性能测试工具

- 6小时掌握JavaScript基础:深入解析与实例教程

- 专业技能工厂,培养数据科学家的摇篮

- 如何使用pg-dump创建PostgreSQL数据库备份

- 基于信任的移动人群感知招聘机制研究

- 掌握Hadoop:Linux下分布式数据平台的应用教程

- Vue购物中心开发与部署全流程指南

- 在Ubuntu环境下使用NDK-14编译libpng-1.6.40-android静态及动态库