实时安全分析:基于Flink的异常检测技术

版权申诉

"这篇文档是关于基于Flink的实时安全数据分析与异常检测的分享,由汇付天下高级信息安全工程师贾林杰主讲。文档涵盖了安全领域数据的特点、处理流程,以及基于ELK的日志收集和分析方案,并介绍了Flink在数据分析中的应用。"

在安全领域,数据分析与异常检测具有独特的挑战。数据来源于各种不同的源头,如主机、网络、应用和安全设备,这些数据类型多样,结构复杂,关联性低。同时,数据流是无限的,持续生成,数据量庞大。因此,实时性要求非常高,以便尽早发现潜在威胁,降低危害。

数据处理流程通常分为四个阶段:数据收集、数据处理、数据分析和数据输出。在收集阶段,需要全面收集各种日志、告警和外部情报;处理阶段对数据进行标准化、字段扩展和关联;分析阶段执行多维度指标计算和条件判断;最后,输出阶段将分析结果用于可视化、规则检测和特征提取。

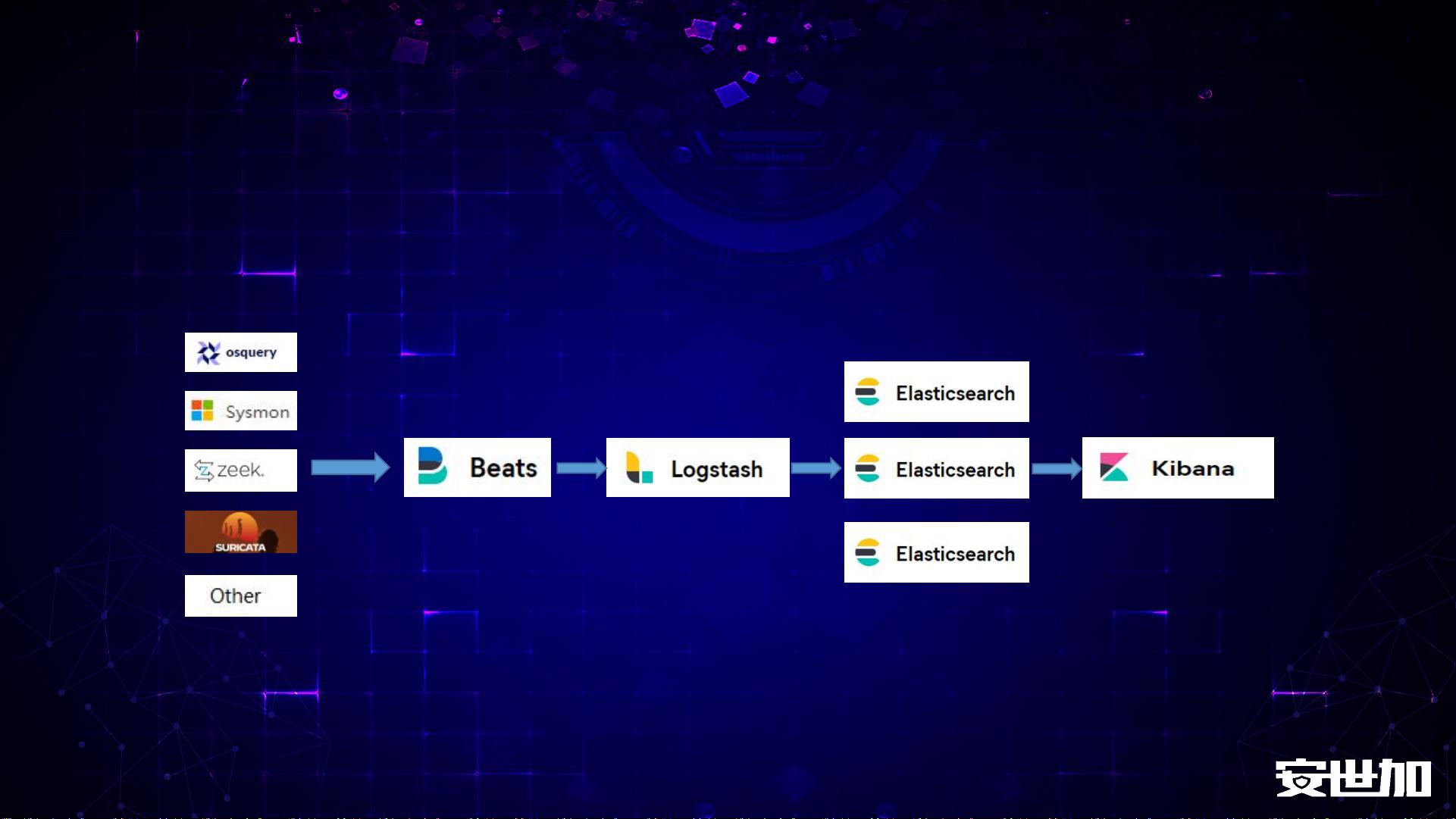

ELK(Elasticsearch、Logstash、Kibana)堆栈常用于日志收集和分析。Beats负责快速接入数据,Logstash进行初步清洗和扩展,Elasticsearch提供强大的分布式搜索功能,而Kibana则能展示详细的可视化图表。然而,ELK在数据清洗和转换方面能力有限,不具备事件驱动和有状态计算,对于长时间跨度和大规模数据存储也有局限。

Apache Flink是一个应对这些问题的解决方案。它是一个用于处理无界和有界数据流的分布式处理引擎,支持有状态计算,能处理无限流数据并提供高实时性。Flink适用于那些需要进行复杂数据关联和高级分析的场景,尤其是在实时安全检测中,它可以实现实时流处理和异常检测,满足安全领域对速度和精度的高要求。

Flink的优势在于其低延迟处理能力和对有状态计算的支持,使得它可以对数据流进行复杂的分析,例如窗口聚合、事件时间处理等,这对于实时安全分析至关重要。此外,Flink还具有容错机制和高度可扩展性,能够处理大量并发数据流,确保系统的稳定性和可靠性。

基于Flink的实时安全数据分析与异常检测方案结合了ELK的日志收集优势,通过Flink的强大计算能力,可以构建一个高效、实时的安全监控系统,及时发现并响应安全威胁。这对于现代支付公司或任何涉及敏感数据的企业来说,都是确保信息安全的重要手段。

2018-10-09 上传

2021-02-24 上传

2022-04-29 上传

174 浏览量

2021-09-20 上传

2024-04-11 上传

2021-08-15 上传

2023-08-26 上传

信息安全与企业管理

- 粉丝: 375

- 资源: 1317

最新资源

- Struts教程(doc版)

- SIP协议的NAT穿越研究

- 架构风格与基于网络的软件架构设计.pdf

- MATLAB图像分割 [附MATLAB源码]

- oracle数据库的备份研究总结

- BeginningCFromNovicetoProfessional

- The C++ Standard Library: A Tutorial and Reference

- MD231模块运用手册,非常详细

- AT指令集中文版,适合开发者或初学者

- 基于细胞神经网的快速图像分割方法

- oracle数据库的备份与恢复

- 基于GIS的饮水安全评价与预测系统研究

- Linux常用命令服务器配置

- EMIStream Tool操作手冊

- EMIStream分析工具

- JAVA面试题解惑系列