2016年Hadoop Summit:基于Docker的Hadoop/Spark集群规模优化框架

需积分: 9 65 浏览量

更新于2024-07-17

收藏 1.78MB PDF 举报

在2016年的Hadoop Summit会议上,Akiyoshi Sugiki和Phyo Thandar Thant,来自日本北海道大学的信息倡议中心,提出了一项名为"A Container-based Sizing Framework for Apache Hadoop/Spark Clusters"的研究。他们的报告聚焦于北海道大学的学术云基础设施及其在Hadoop和Spark集群规模化的关键应用。

首先,他们介绍了北海道大学的信息倡议中心,这是一所拥有悠久历史的国家超级计算机中心,隶属于HPCI(高性能计算基础设施)和JHPCN(跨学科大型信息基础设施联合使用/研究中心)两个组织。该中心致力于超级计算机和云计算等领域的研究,运营着双子星系统:一台性能强大的超级计算机(172万亿次浮点运算每秒,176个节点),以及一个学术云计算系统(43万亿次浮点运算每秒,约2000个虚拟机)。

北海道大学的学术云是日本最大的教育研究云平台,提供超过43万亿次浮点运算能力,支持大规模数据处理。该云系统由两部分组成:一部分是超级计算机系统,搭载了高性能的SR16000 M1和BS2000服务器,以及大容量的存储设备;另一部分是专门的数据科学云系统,配备有AMS2500文件系统和不同类型的硬盘配置。

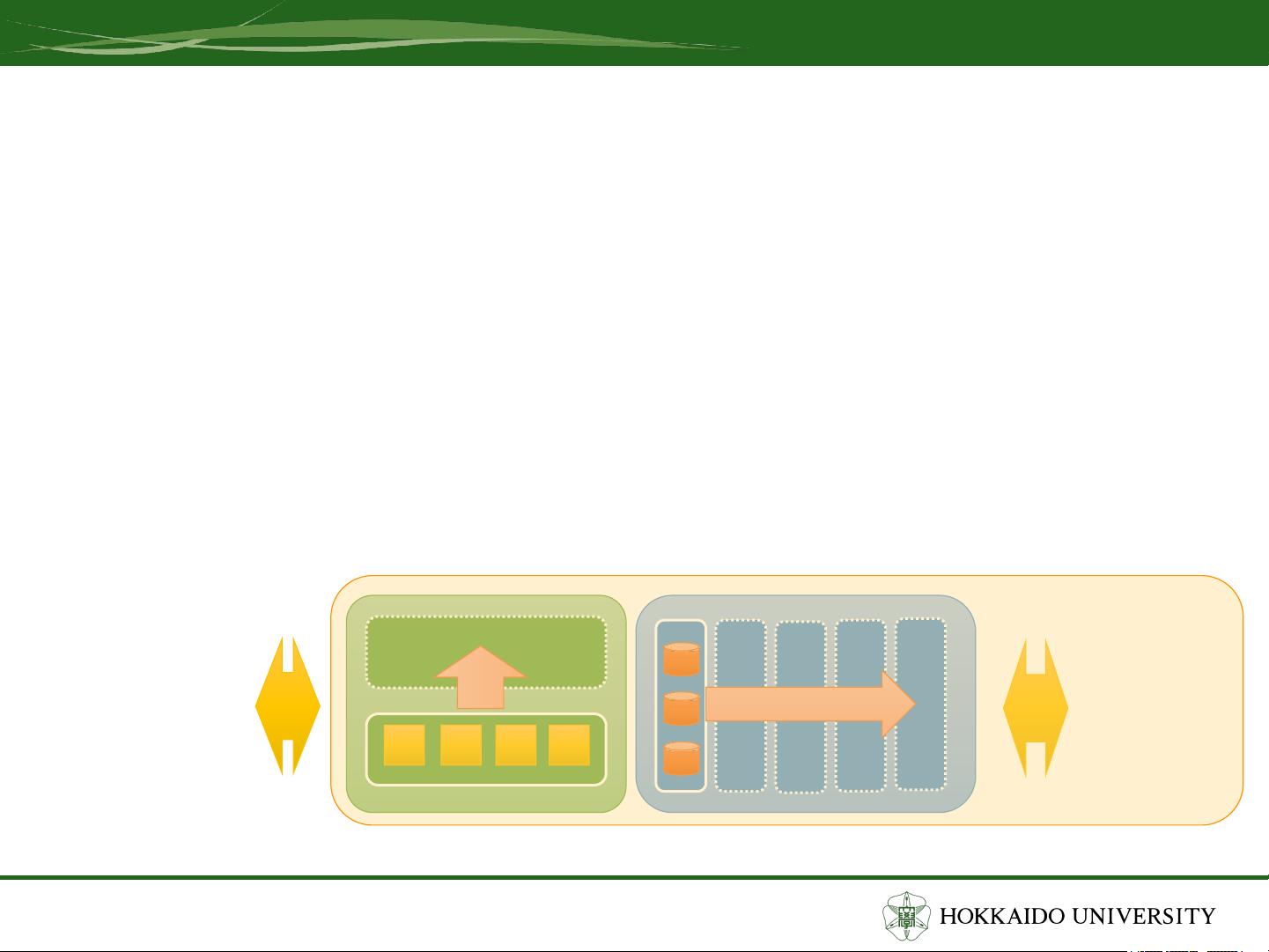

报告的核心是他们开发的基于Docker的Hadoop规模化框架。Docker容器技术在此处发挥了关键作用,它允许在不同环境中高效地部署和管理Hadoop集群,确保资源利用率最大化,同时保持应用的隔离性和一致性。通过容器化,可以简化集群的部署,减少配置复杂性,并且能够适应不断变化的工作负载需求。

此外,演讲者还探讨了Hadoop的多目标优化问题。在实际应用中,Hadoop集群需要同时考虑多个目标,如性能、成本、可用性等,这就需要一种动态的决策支持系统来平衡这些目标。通过采用多目标优化方法,他们旨在实现资源的最优分配,提升整个系统的效率和灵活性。

这项研究提供了将容器技术应用于Hadoop和Spark集群规模化的重要实践案例,展示了如何通过自动化和标准化的手段来应对大数据处理中的挑战,以及如何通过多目标优化策略实现集群性能和成本的协同优化。这对于云计算环境下的Hadoop集群管理和扩展具有重要的参考价值。

2025-03-13 上传

2025-03-13 上传

2025-03-13 上传

2025-03-13 上传

weixin_38743506

- 粉丝: 352

最新资源

- 彻底清除Office2003 安装残留问题

- Swift动画分类:深度利用CALayer实现

- Swift动画粒子系统:打造动态彗星效果

- 内存SPDTool:性能超频与配置新境界

- 使用JavaScript通过IP自动定位城市信息方法

- MPU6050官方英文资料包:产品规格与开发指南

- 全方位技术项目源码资源包下载与学习指南

- 全新蓝色卫浴网站管理系统模板介绍

- 使用Python进行Tkinter可视化开发的简易指南

- Go语言绑定Qt工具goqtuic的安装与使用指南

- 基于意见目标与词的情感分析研究与实践

- 如何制作精美的HTML网页模板

- Ruby开发中Better Errors提高Rack应用错误页面体验

- FusionMaps for Flex:多种开发环境下的应用指南

- reverse-theme:Emacs的逆向颜色主题介绍与安装

- Ant 1.2.6版本压缩包的下载指南