深度学习:人工神经网络参数配置与优化

需积分: 29 111 浏览量

更新于2024-07-17

1

收藏 2.66MB PPTX 举报

"该资源是关于人工神经网络参数设置的PPT,由胡浩基教授在浙江大学信息与电子工程学院讲解。内容涵盖了随机梯度下降、激活函数选择、训练数据初始化、权重和偏置初始化、批处理规范化、目标函数选择、参数更新策略以及训练过程中的建议。"

人工神经网络(ANN)的参数设置是训练过程中至关重要的环节,它直接影响到模型的学习能力和泛化性能。以下是关键知识点的详细说明:

1. 随机梯度下降(SGD):SGD是一种常用的优化算法,通过每次迭代取一批样本来更新网络参数,而不是全部样本。批量大小(batch_size)通常设置在50至200之间,这有助于平衡计算效率和收敛速度。在实际应用中,可以随机打乱样本顺序,避免因样本顺序导致的训练偏差。

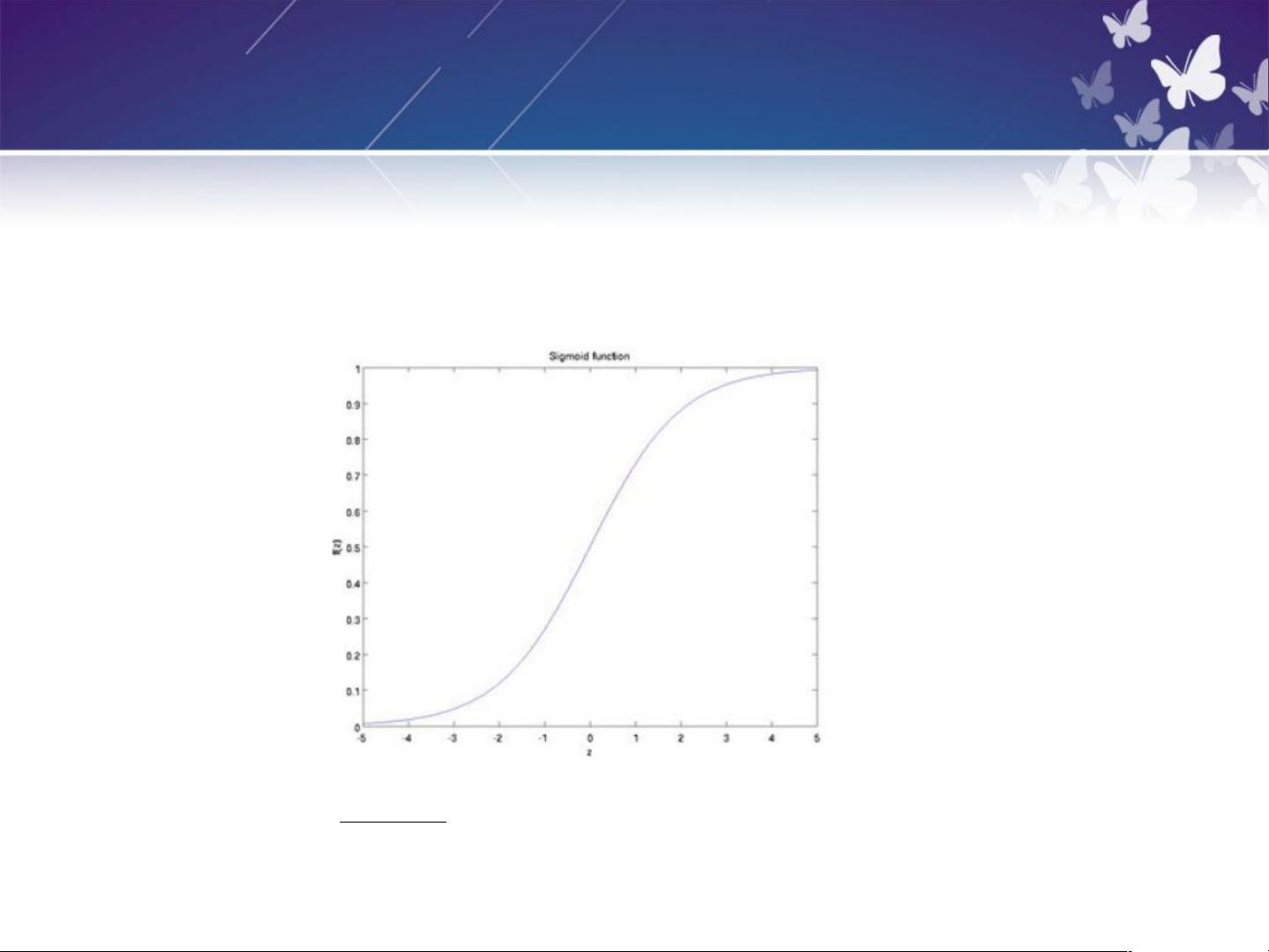

2. 激活函数:激活函数引入非线性,使神经网络能够解决复杂问题。常见的激活函数有Sigmoid和tanh。Sigmoid函数在0附近饱和,可能导致梯度消失问题;tanh函数范围在-1到1之间,但中心对称,可能会减缓训练速度。

3. 训练数据初始化:为了提高模型的训练效果,通常会进行数据预处理,如均值和方差归一化,这可以帮助模型更快地收敛并减少过拟合风险。

4. 权重和偏置(W, b)初始化:合理的权重和偏置初始化能确保网络各层的激活值分布均匀,有助于训练初始阶段的梯度传播。常用的方法有Xavier初始化和He初始化,它们考虑了输入节点数量来确定初始值。

5. 批处理规范化(Batch Normalization):BN在每一层的激活函数之前或之后应用,使得每一层的输入保持一定的均值和方差,从而加速训练并改善模型的泛化能力。

6. 目标函数选择:常见的目标函数有交叉熵损失函数和均方误差,用于衡量模型预测与真实值之间的差距。对于二分类问题,通常使用二元交叉熵;对于回归问题,使用均方误差。

7. 参数更新策略:除了SGD,还有其他优化器,如Adagrad、RMSprop、Adam等,它们自适应调整学习率,以应对不同参数的梯度大小。

8. 训练建议:在训练过程中,应监控损失函数的变化、验证集上的性能以及防止过拟合(例如使用早停法、正则化或dropout)。此外,可以采用学习率衰减策略,随着训练的进行逐渐降低学习率,以帮助模型更好地收敛。

通过理解并合理设置这些参数,可以更有效地训练人工神经网络,提高其在各种任务上的性能。

2023-04-02 上传

2023-02-20 上传

2023-02-26 上传

2023-05-26 上传

2023-05-26 上传

2023-03-21 上传

2024-10-30 上传

2024-11-08 上传

2023-05-29 上传