CentOS 6.0 Hadoop 2.0 完全指南:从设置到集群启动

需积分: 10 84 浏览量

更新于2024-07-18

收藏 3.88MB DOC 举报

本篇CentOS6.0-Hadoop安装手册详细介绍了在CentOS 6环境中安装和配置Hadoop 2.0版本的整个流程。以下是主要内容概要:

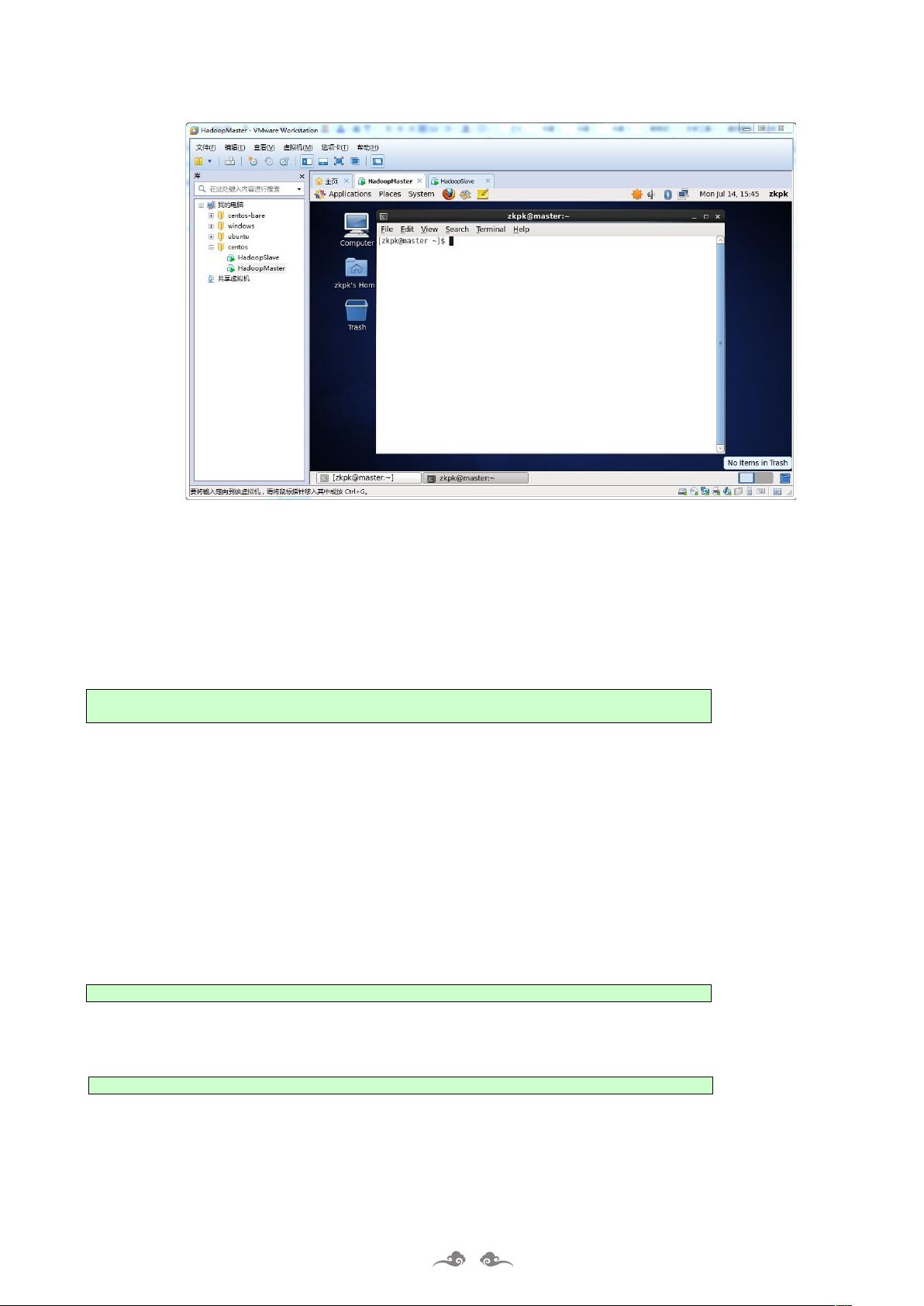

1. **启动虚拟客户机**:首先,用户需要启动两台虚拟机,HadoopMaster和HadoopSlave,通过VMware Workstation进行操作。若虚拟机未打开或有异常,用户需选择“否”并从安装包中加载。

2. **Linux系统配置**:在每个节点上,作为root用户进行操作,通过`su - root`命令切换身份,并确保在终端环境下进行。这包括:

- **软件包和数据包管理**:将名为"HadoopInActionExperiment"的完整软件包中的"software"文件夹以及"sogou-data"复制到HadoopMaster节点的桌面,以准备后续安装。

3. **系统基础配置**:

- **时钟同步**:确保所有节点的时钟同步,这对于Hadoop集群的稳定运行至关重要。

- **主机名配置**:设置适当的主机名,以便于内部通信和识别。

- **网络环境设置**:使用`setup`命令配置网络环境,允许Hadoop节点之间的通信。

- **防火墙关闭**:关闭防火墙,以避免对Hadoop服务的不必要的限制。

- **hosts列表**:配置hosts文件,包含集群中各节点的IP和主机名映射。

- **JDK安装**:安装Java Development Kit (JDK),因为Hadoop依赖于Java环境。

4. **Hadoop配置部署**:

- **安装包解压**:解压Hadoop安装包,为后续步骤做准备。

- **环境变量配置**:

- `hadoop-env.sh`:设置Hadoop环境变量,如JAVA_HOME、HADOOP_HOME等。

- `yarn-env.sh`:针对YARN(Yet Another Resource Negotiator)组件的环境变量配置。

- **核心组件配置**:

- `core-site.xml`:配置Hadoop的核心参数,如HDFS(Hadoop Distributed File System)配置。

- `hdfs-site.xml`:HDFS特定配置,如副本策略和命名空间设置。

- `yarn-site.xml`:YARN配置,涉及资源管理和调度。

- `mapred-site.xml`:MapReduce配置,负责处理任务执行逻辑。

- **从节点管理**:创建`slaves`文件,列出所有从节点,以及将配置复制到从节点。

5. **启动Hadoop集群**:

- **环境变量设置**:为系统环境变量设置Hadoop路径,确保Hadoop可用。

- **数据目录创建**:创建必要的数据存储目录,如HDFS的NameNode和DataNode数据目录。

- **集群启动**:执行启动命令,启动Hadoop Master和Worker节点,包括HDFS、YARN和MapReduce服务。

这篇手册细致地覆盖了从基础环境设置到Hadoop集群配置和启动的整个过程,旨在帮助读者在CentOS 6上成功搭建Hadoop 2.0环境。

2018-07-17 上传

2014-08-01 上传

2022-05-19 上传

2019-09-18 上传

2012-05-08 上传

2022-03-20 上传

2016-01-11 上传

chenyu7614

- 粉丝: 0

- 资源: 2

最新资源

- Angular实现MarcHayek简历展示应用教程

- Crossbow Spot最新更新 - 获取Chrome扩展新闻

- 量子管道网络优化与Python实现

- Debian系统中APT缓存维护工具的使用方法与实践

- Python模块AccessControl的Windows64位安装文件介绍

- 掌握最新*** Fisher资讯,使用Google Chrome扩展

- Ember应用程序开发流程与环境配置指南

- EZPCOpenSDK_v5.1.2_build***版本更新详情

- Postcode-Finder:利用JavaScript和Google Geocode API实现

- AWS商业交易监控器:航线行为分析与营销策略制定

- AccessControl-4.0b6压缩包详细使用教程

- Python编程实践与技巧汇总

- 使用Sikuli和Python打造颜色求解器项目

- .Net基础视频教程:掌握GDI绘图技术

- 深入理解数据结构与JavaScript实践项目

- 双子座在线裁判系统:提高编程竞赛效率