探索时间序列对比学习方法:Ts2vec、TLoss与TNC

需积分: 3 166 浏览量

更新于2024-08-04

1

收藏 1.42MB PDF 举报

对比学习在时间序列分析领域日益受到关注,因为它能够捕捉复杂的时间依赖关系,并为多模态数据提供强大的表示能力。本篇文献综述主要聚焦于几种重要的对比学习方法,包括TS2vec、Subseries Consistency、TLoss/ Subseries Consistency以及TNC/ Temporal consistency。

1. **TS2vec:**

Yue Z., Wang Y., Duan J.等人在《AAAI Conference on Artificial Intelligence》上提出了TS2vec,这是一种旨在获取时间序列通用表示的框架。该方法借鉴了词向量(Word2vec)的思想,通过随机抽取子序列作为正样本,与随机选取的其他序列作为负样本,构建三元损失函数。核心是使用扩展的因果卷积网络,确保模型仅使用前驱信息预测当前时间步,从而实现序列级别的信息传递和结构保留。

2. **TLoss/Subseries Consistency:**

Franceschi et al.在Neural Information Processing Systems会议上介绍了无监督可扩展的时间序列表示学习算法,重点关注子序列一致性。这里,正样本是由随机长度和位置选择的子序列,而负样本则是其他随机序列。模型目标是使正样本接近参考序列(ref),同时让负样本远离,形成一个区分正负样本的三元损失。研究者使用深度神经网络并集成指数扩张因果卷积,以处理时间序列数据。

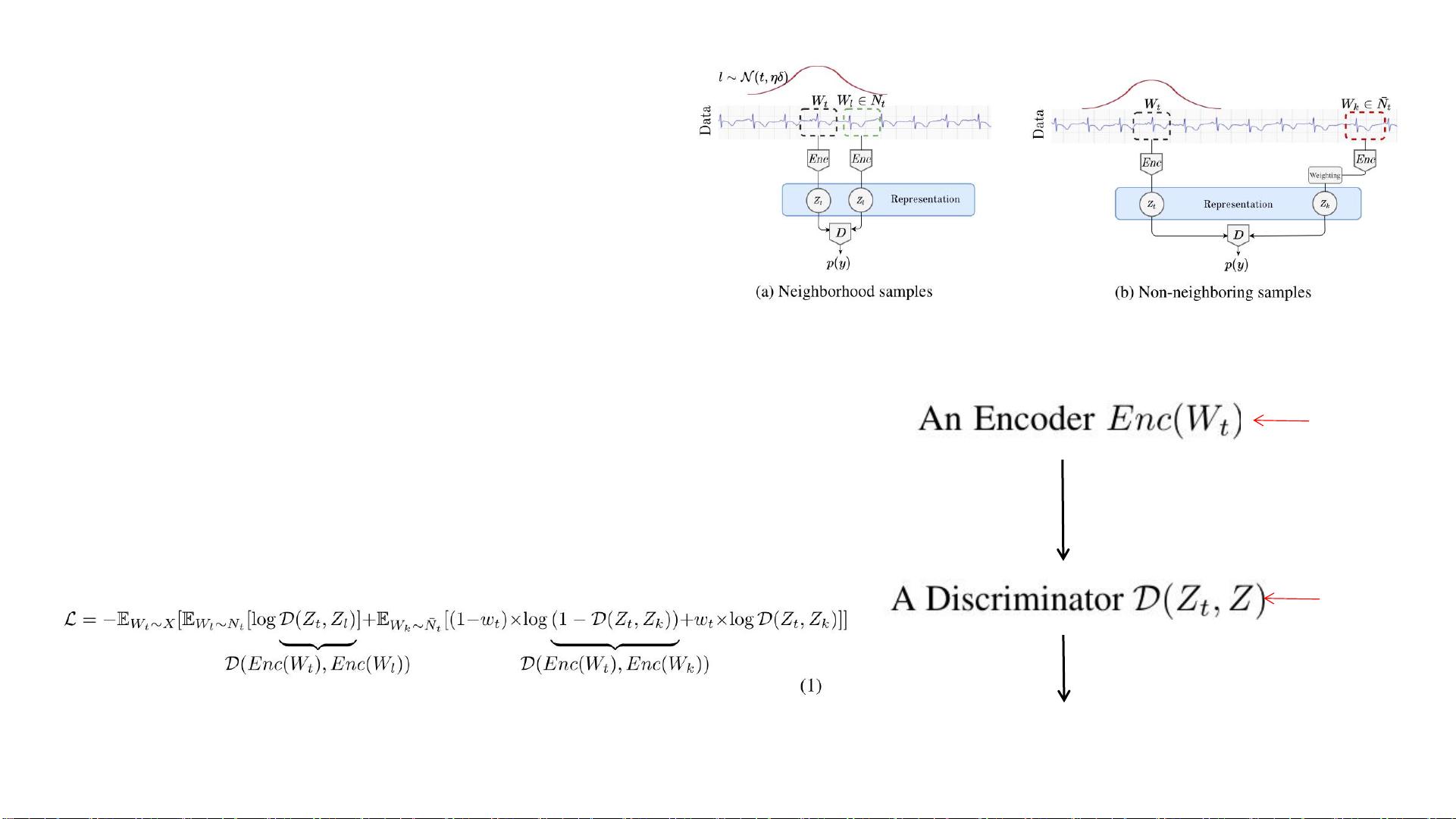

3. **TNC/Temporal Consistency:**

Tonekaboni等人提出的TNC(Temporal Neighborhood Coding)方法,利用时间邻域编码进行无监督学习,强调时间序列间的连续性和一致性。他们通过无监督训练,学习到的时间序列表示能够反映序列间的时空关系,这对于预测和理解时序数据很有帮助。

4. **TS-TCC/Transformer Consistency:**

Eldele, Ragab, and Chen等人的工作将Transformer模型应用于时间序列表示学习,结合了时空对比(Temporal and Contextual Contrasting)。这种方法通过Transformer架构处理时间序列,利用对比学习机制来增强模型对时间依赖性特征的捕获,尤其是在处理长序列时效果显著。

5. **关键特性总结:**

- 子序列一致性策略用于确保模型对时间序列内部结构的敏感性。

- 多元化的损失函数设计,如三元损失,有助于区分正负样本,提高学习的针对性。

- 基于深度学习架构,如因果卷积和Transformer,适应不同时间序列数据的处理需求。

- 无监督学习方法强调在没有标签的情况下也能学习到有效的时间序列表示,这对于实际应用中的大量未标记数据尤为有用。

这些方法展示了对比学习在时间序列分析中的潜力,未来可能在诸如异常检测、序列分类、预测等任务中发挥重要作用。通过比较和融合这些技术,研究人员可以进一步提升时间序列数据的理解和利用水平。

2018-05-22 上传

2024-02-29 上传

2022-08-03 上传

2021-05-18 上传

点击了解资源详情

点击了解资源详情

2023-04-21 上传

2023-04-11 上传

zzz_979

- 粉丝: 1291

- 资源: 7

最新资源

- node-silverpop:轻松访问Silverpop Engage API的Node.js实现

- 最小宽度网格图绘制算法研究

- 多数据源事务解决方案:统一管理单应用中的多数据库

- 利用Next.js匿名浏览Reddit子板块图片

- SpringBoot+H5官网模板,覆盖多种网页资源播放

- Gitshots-server:简化开源贡献的提交记录服务

- Scrapy-Dash工具:轻松生成Scrapy文档集

- Node.js v18.12.0发布,优化Linux PPC64LE服务器性能

- 蚂蚁设计专业版快速使用指南与环境配置

- Vue.js 2.3.4源码解读及开发环境配置指南

- LDBase:Lazarus开发者的dbf数据库管理开源工具

- 高效部署WordPress的VENISON脚本教程

- Saffron Bahraman-crx插件:控制产品线的栽培与培养

- Gitpod中运行前后端应用程序的指南

- Node.js v20.3.0新版本发布 - 开源跨平台JavaScript环境

- 掌握非线性方程根的迭代求解-Matlab方法实现