MongoDB索引效率问题:解决日志中SocketTimeoutException的分析

134 浏览量

更新于2024-08-30

收藏 236KB PDF 举报

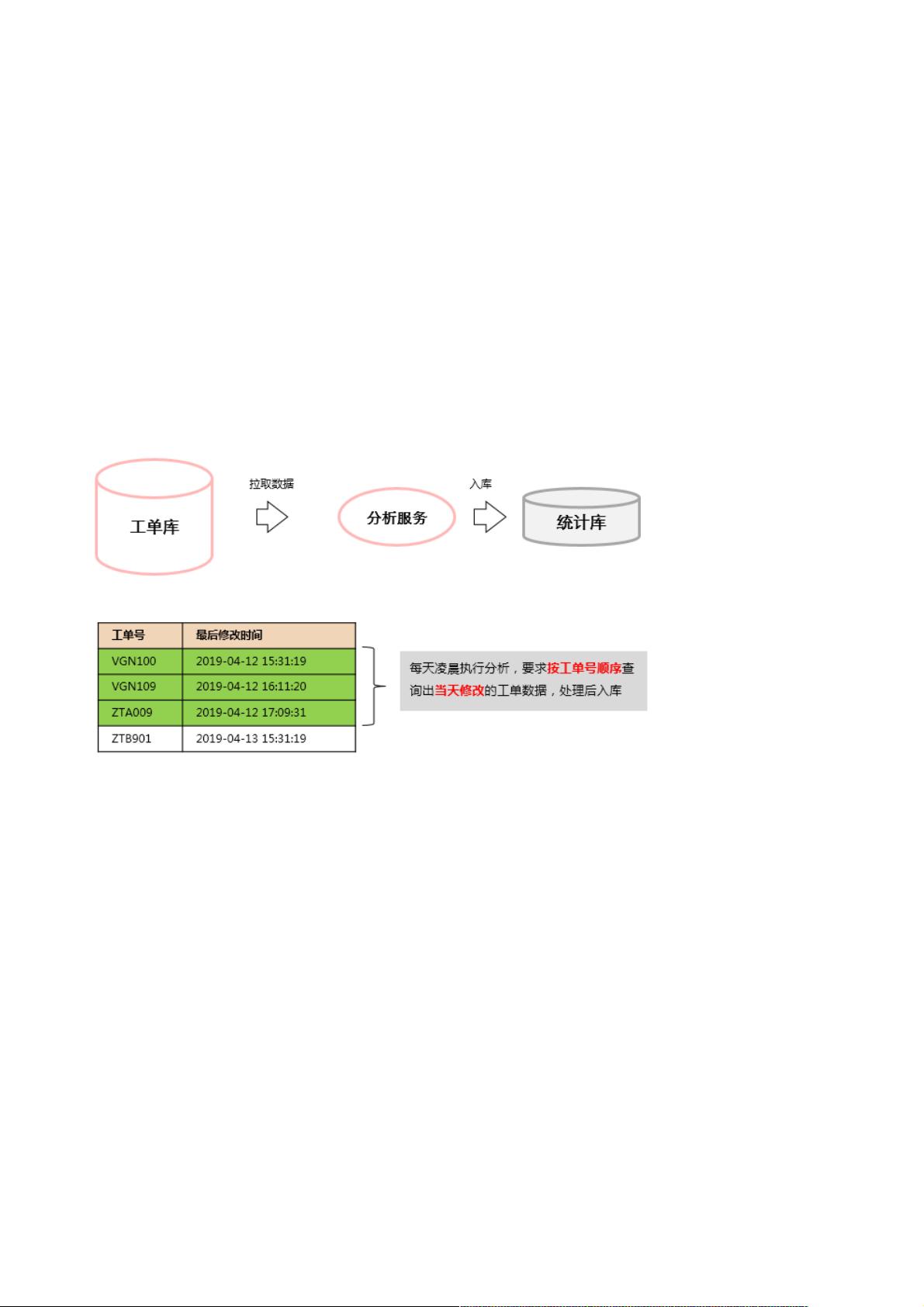

"文章主要探讨了MongoDB在执行特定查询时可能出现的索引seek效率问题,导致数据库操作超时的情况。问题源于一个日志分析服务,该服务在凌晨1点时遇到MongoDB操作超时的问题,尽管数据库监控没有显示明显异常。通过分析,发现问题是由于在大规模数据表上进行分页查询时,依赖于`oid`存在的查询和排序方式导致的效率低下。"

在MongoDB中,索引是提升查询性能的关键工具,但不恰当的使用方式可能导致相反的效果。在这个案例中,服务试图通过`lastModifiedTime`和`oid`字段进行分页查询。`oid`字段的`$exists`和`$gt`查询在有大量记录时可能触发大量的磁盘I/O,尤其是当`oid`是连续的排序查询时,如果没有针对`oid`建立适当的索引,MongoDB需要遍历大量数据以找到满足条件的记录。

初始索引设计如下:

```javascript

db.t_work_order.ensureIndex({ "lastModifiedTime": 1, "oid": 1 })

```

这个索引虽然支持`lastModifiedTime`的范围查询,但由于`oid`是按升序排序的,对于基于`oid`的分页查询,每次都需要从索引的开始部分查找,即`seek()`操作,这在数据量大时可能导致效率低下,尤其是在连续查询时,因为MongoDB无法利用索引来直接跳转到下一页的起始位置。

为了解决这个问题,可以优化索引策略,创建一个针对分页查询更高效的索引:

```javascript

db.t_work_order.createIndex({ "lastModifiedTime": 1, "oid": -1 })

```

将`oid`的排序改为降序,使得在进行`oid`的`$gt`查询时,MongoDB可以更快地定位到下一页的起点,从而减少`seek()`操作的次数和磁盘I/O。

此外,考虑到查询中`lastModifiedTime`的范围不变,可以考虑缓存这部分数据,减少对数据库的访问频率。同时,评估是否有必要每次都按`oid`排序,如果业务上可以接受一定的排序误差,可以考虑牺牲部分排序精确性来换取更高的查询速度。

总结来说,MongoDB的索引设计和使用是优化数据库性能的关键。在面对大数据量和复杂查询场景时,需要深入理解查询逻辑,合理构建索引,避免无效或低效的`seek`操作,以提高系统整体的稳定性和性能。在遇到超时问题时,不应只关注网络超时设置,更要深入分析查询行为和索引效率,从根本上解决问题。

141 浏览量

141 浏览量

点击了解资源详情

119 浏览量

166 浏览量

491 浏览量

303 浏览量

2022-07-11 上传

656 浏览量

weixin_38661466

- 粉丝: 7

最新资源

- 虚幻引擎4经典FPS游戏开发包解析

- 掌握LaTeX中psfig.sty的使用技巧

- 探索X102 51学习板:深入嵌入式系统开发

- 深入理解STM32外部中断的实现与应用

- 大冶市数字高程模型(DEM)数据详细解读

- 俄罗斯方块游戏制作教程:Protues实现指南

- ASP.NET视频点播系统源代码及论文:多技术项目资源集锦

- Platzi JavaScript课程体系:全面覆盖初、中、高级

- cutespotify:跨平台MeeSpot音乐播放器兼容SailfishOS

- PictureEx类:在VC6下显示jpg与gif动图

- 基于stc89C51的数字时钟Proteus仿真设计

- MATLAB全面基础教程与实践技巧分享

- 实现双行文字向上滚动效果的js插件

- Labview温度报警系统:实时监控与声光警报

- Java官网ehcache-2.7.3实例教程

- A-Frame超级组件集:超帧的创新与应用