深入解析Hadoop源代码:从HDFS到MapReduce

需积分: 41 73 浏览量

更新于2024-07-24

收藏 5.99MB PDF 举报

"Hadoop源代码分析,涵盖Hadoop的IO、FS、Utils、MapRed等模块,以及与Google核心技术的对应关系"

在深入探讨Hadoop源代码之前,我们需要理解Hadoop的基本架构。Hadoop是一个开源的分布式计算框架,最初受到Google的几个关键技术创新启发,包括Google Cluster、Chubby、GFS(Google文件系统)、BigTable和MapReduce。这些技术的开源版本在Apache Hadoop项目中得到了实现,比如Chubby对应ZooKeeper,GFS对应HDFS(Hadoop分布式文件系统),BigTable对应HBase,而MapReduce则直接在Hadoop项目内实现。

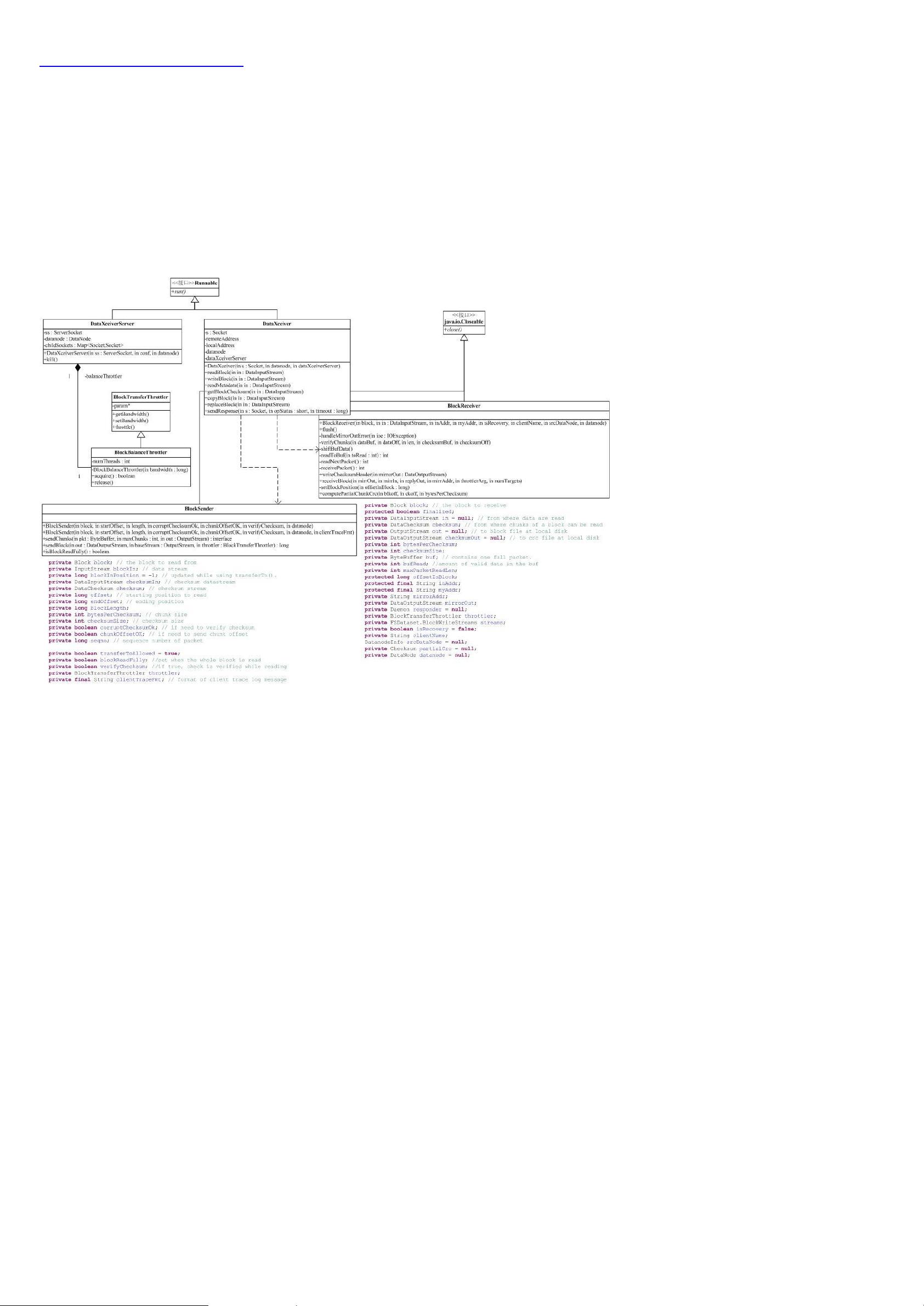

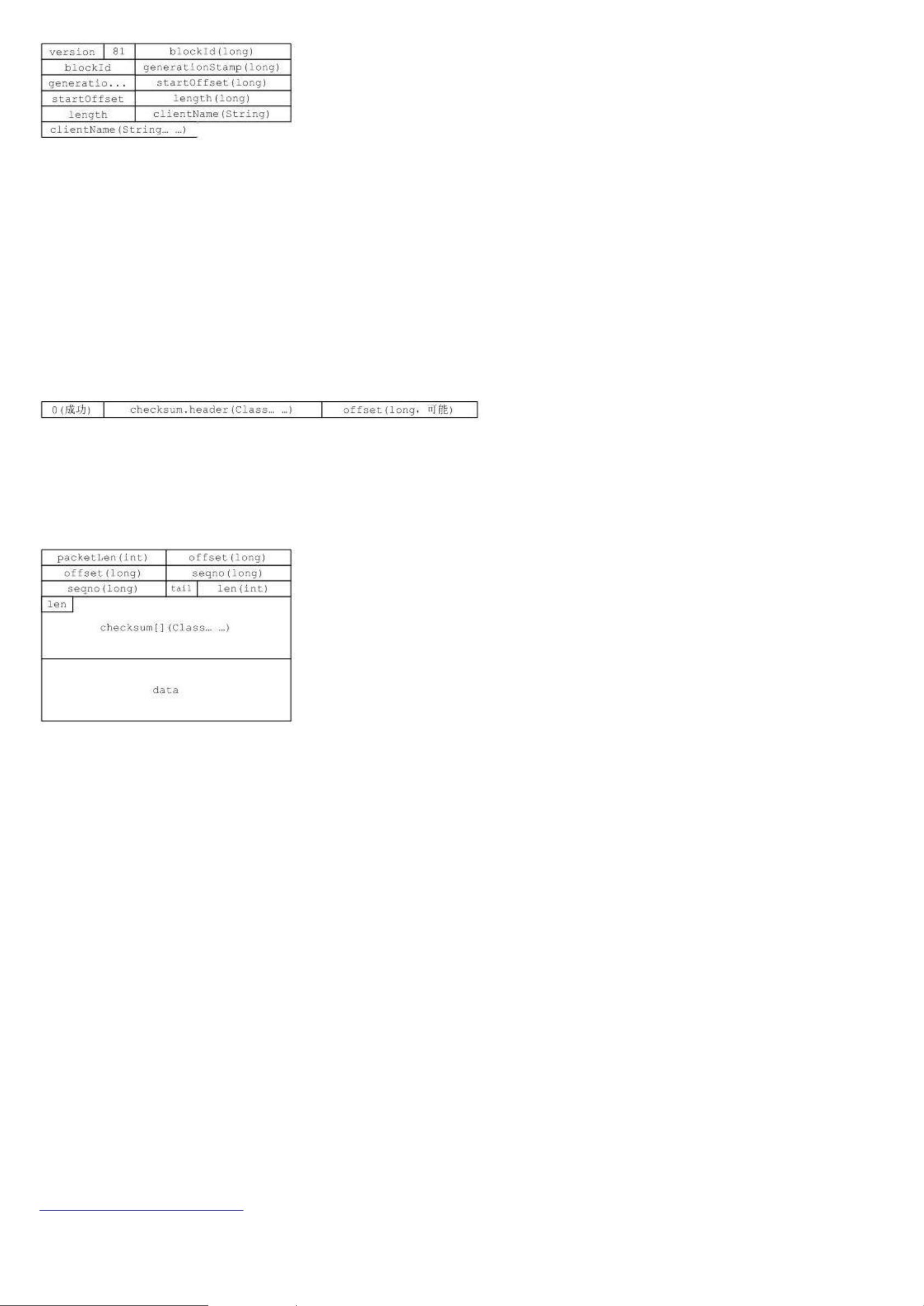

HDFS(Hadoop Distributed File System)是Hadoop的基础,它是一个高度容错性的分布式文件系统,设计用于处理和存储大量数据。HDFS通过将大文件分割成块并在集群中的多个节点上存储,实现了数据的冗余和快速访问。Hadoop MapReduce则是一个用于大规模数据集并行处理的编程模型,它将复杂的计算任务拆分成两个阶段:Map和Reduce,分别进行数据处理和结果聚合。

Hadoop的源代码结构复杂,主要由以下几个关键组件组成:

1. **Hadoop IO**:这个模块包含了各种输入/输出格式、记录读写器和压缩算法。它允许Hadoop处理各种类型的数据源,如文本、序列化对象、Avro数据等。

2. **Hadoop FS**:文件系统接口(FileSystem API)和实现,包括HDFS以及对本地文件系统和其他分布式文件系统的支持。FS API使得应用程序可以透明地操作分布式文件系统,而无需关心底层的实现细节。

3. **Hadoop Utils**:提供通用的工具和实用程序,如网络通信、日志管理、配置文件处理等。这些工具对整个Hadoop生态系统提供了基础支持。

4. **Hadoop MapReduce**:包含MapReduce的运行时环境、作业调度和数据分区逻辑。MapReduce作业被分解为许多独立的任务,这些任务在集群中的不同节点上并行执行。

在Hadoop源代码分析中,我们需要关注的主要包包括`conf`、`io`、`fs`、`utils`和`mapred`。`conf`包处理配置读取,与文件系统交互;`io`包提供数据输入输出的抽象;`fs`包实现文件系统的接口和底层实现;`utils`包包含各种辅助函数和工具;`mapred`包则是MapReduce编程模型的核心。

Hadoop的包之间存在复杂的依赖关系,例如`conf`包依赖于`fs`包来读取配置文件,而`fs`包又封装了文件系统的具体实现。这种设计允许Hadoop灵活地支持多种不同的文件系统。

Hadoop的源代码分析涵盖了从系统配置到分布式计算的全过程,对于理解Hadoop如何处理大数据至关重要。深入研究这些源代码可以帮助开发者优化性能,解决故障,甚至开发新的Hadoop相关应用。例如,通过分析`mapred`包,我们可以理解MapReduce作业的生命周期,优化作业提交、任务调度和数据处理的效率。

Hadoop源代码分析是一项深入的技术任务,涉及到分布式系统、并行计算、文件系统和网络通信等多个领域的知识。通过这样的分析,开发者可以获得对Hadoop内部机制的深刻理解,这对于在实际项目中有效利用Hadoop至关重要。

2022-03-12 上传

2013-01-13 上传

2011-05-21 上传

107 浏览量

2024-11-27 上传

2024-11-27 上传

2024-11-27 上传

2024-11-27 上传

2024-11-27 上传

alexingcool

- 粉丝: 89

- 资源: 1

最新资源

- MATLAB新功能:Multi-frame ViewRGB制作彩色图阴影

- XKCD Substitutions 3-crx插件:创新的网页文字替换工具

- Python实现8位等离子效果开源项目plasma.py解读

- 维护商店移动应用:基于PhoneGap的移动API应用

- Laravel-Admin的Redis Manager扩展使用教程

- Jekyll代理主题使用指南及文件结构解析

- cPanel中PHP多版本插件的安装与配置指南

- 深入探讨React和Typescript在Alias kopio游戏中的应用

- node.js OSC服务器实现:Gibber消息转换技术解析

- 体验最新升级版的mdbootstrap pro 6.1.0组件库

- 超市盘点过机系统实现与delphi应用

- Boogle: 探索 Python 编程的 Boggle 仿制品

- C++实现的Physics2D简易2D物理模拟

- 傅里叶级数在分数阶微分积分计算中的应用与实现

- Windows Phone与PhoneGap应用隔离存储文件访问方法

- iso8601-interval-recurrence:掌握ISO8601日期范围与重复间隔检查