统计语言模型与数据平滑技术

需积分: 40 23 浏览量

更新于2024-07-25

收藏 1.39MB PPT 举报

"语言平滑度技术是计算语言模型中的一个重要方面,主要涉及如何通过统计方法来估计自然语言句子的概率,提升模型的预测准确性和流畅度。本文将介绍统计语言模型的基本概念、发展历程以及数据平滑方法。"

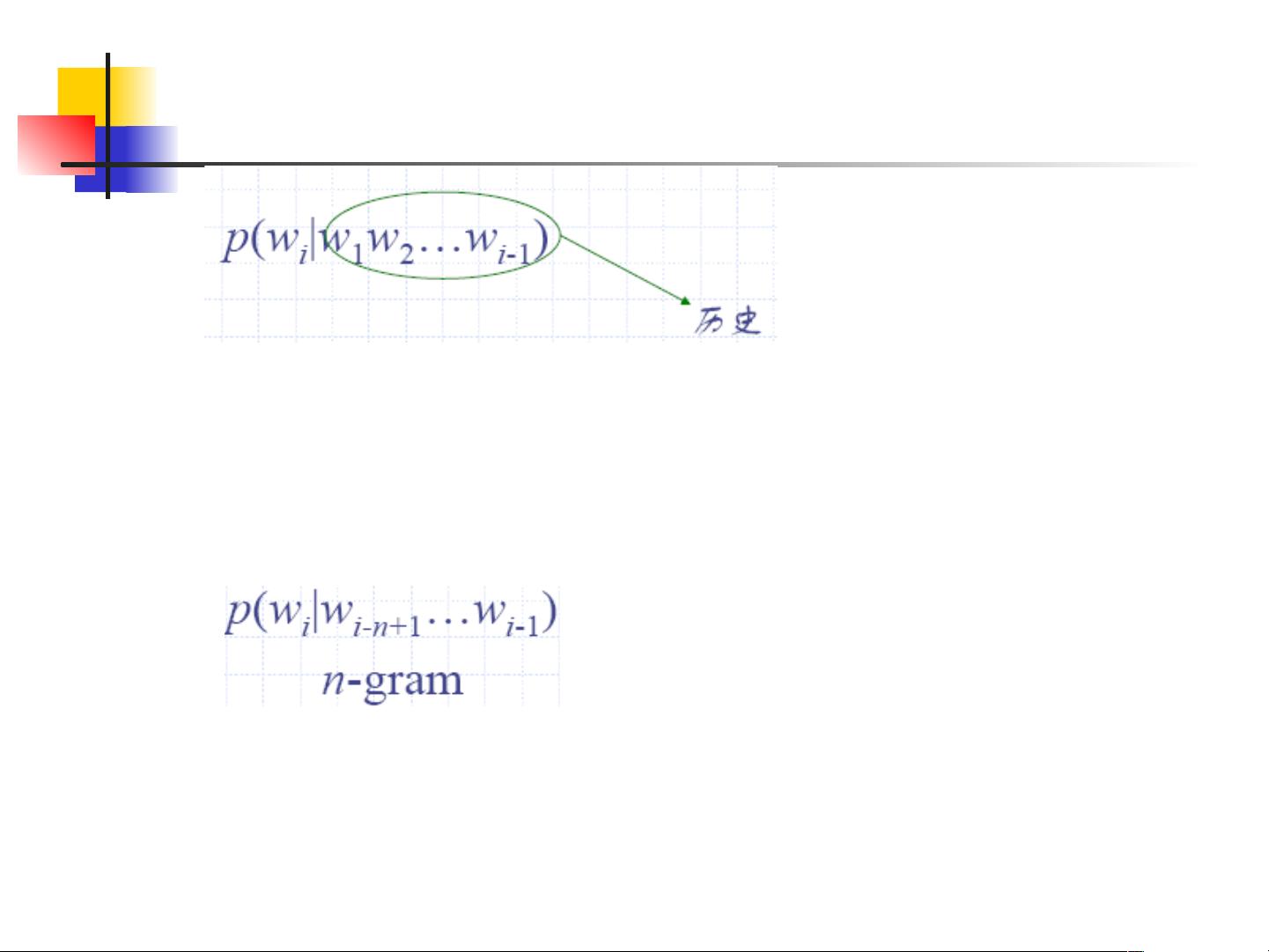

统计语言模型是自然语言处理中的核心工具,它们基于大量文本数据,通过统计方法来预测一个句子或单词序列出现的概率。这种模型的出现标志着从依赖于规则基础的方法转向数据驱动的处理方式。统计语言模型的发展始于20世纪90年代,由语言和语音处理领域的先驱贾里尼克等人提出,并在李开复等人的进一步研究中得到了显著的应用,尤其是在语音识别领域。

统计语言模型的目标是为任意句子或词序列估算概率。例如,句子“我刚吃过晚饭”的概率可能比“刚我过晚饭吃”更高。由于实际中,大部分句子的概率未知,因此需要通过对大量文本数据的分析来估计这些概率。这个过程称为语言建模,它不仅用于语音识别,还广泛应用于光学字符识别、手写识别、机器翻译和信息检索等多个领域。

语言建模的关键挑战之一是处理未在训练数据中出现过的词序列(即零频率问题)。为了解决这个问题,数据平滑技术应运而生。数据平滑方法旨在避免将未见过的词组合赋以零概率,而是分配一个小但非零的概率值,以提高模型的平滑度和预测能力。常见的数据平滑方法包括添加平滑项、Kneser-Ney平滑、Good-Turing平滑等。

TAGGIT和CLAWS是词性标注系统的例子,展示了概率统计方法相对于规则基础方法的优势。CLAWS系统的高精度表明,基于统计的语言模型在处理大量文本时能够取得更好的性能。

在实际应用中,语言模型可以通过评估不同句子的概率来帮助选择最合理的识别结果。例如,在语音识别中,如果有多条可能的识别路径,可以利用语言模型计算每条路径的相对概率,选取概率最高的作为最终识别结果。

语言平滑度技术是提高统计语言模型预测准确性和流畅度的关键手段。通过不断优化和改进数据平滑方法,我们可以更好地理解和处理自然语言,推动自然语言处理技术的进步。

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

103 浏览量

127 浏览量

103 浏览量

xiixiixixi

- 粉丝: 1

- 资源: 9