非监督模式识别:聚类算法与相似性度量

需积分: 29 194 浏览量

更新于2024-07-17

收藏 665KB PPT 举报

"该资源是关于机器学习中的非监督模式识别的PPT,主要探讨了在没有类别标签的情况下,如何通过相似性度量、聚类标准和算法对数据进行分组,即非监督学习的基本原理和方法。"

非监督模式识别是一种机器学习技术,与监督学习相对。在监督学习中,我们拥有带标签的数据,可以训练模型进行预测或分类。而非监督学习则在无标签数据集上操作,其目标是发现数据内在的结构、模式或者群组,即聚类。

1. **相似性度量**:在非监督学习中,样本之间的相似性是聚类的基础。常见的度量方式有欧氏距离和内积。欧氏距离衡量的是两个点在多维空间中的直线距离,而内积则反映两个向量的线性相关程度,内积越大,相似性越高。

2. **聚类标准**:聚类的目标是找到数据的自然分组,这涉及到如何定义一个“好的”聚类。标准可能包括类内的紧密度(类内样本间的相似性较高)和类间的分离度(类间样本的相似性较低)。此外,聚类的定义也非常重要,如硬聚类要求每个样本仅属于一个类。

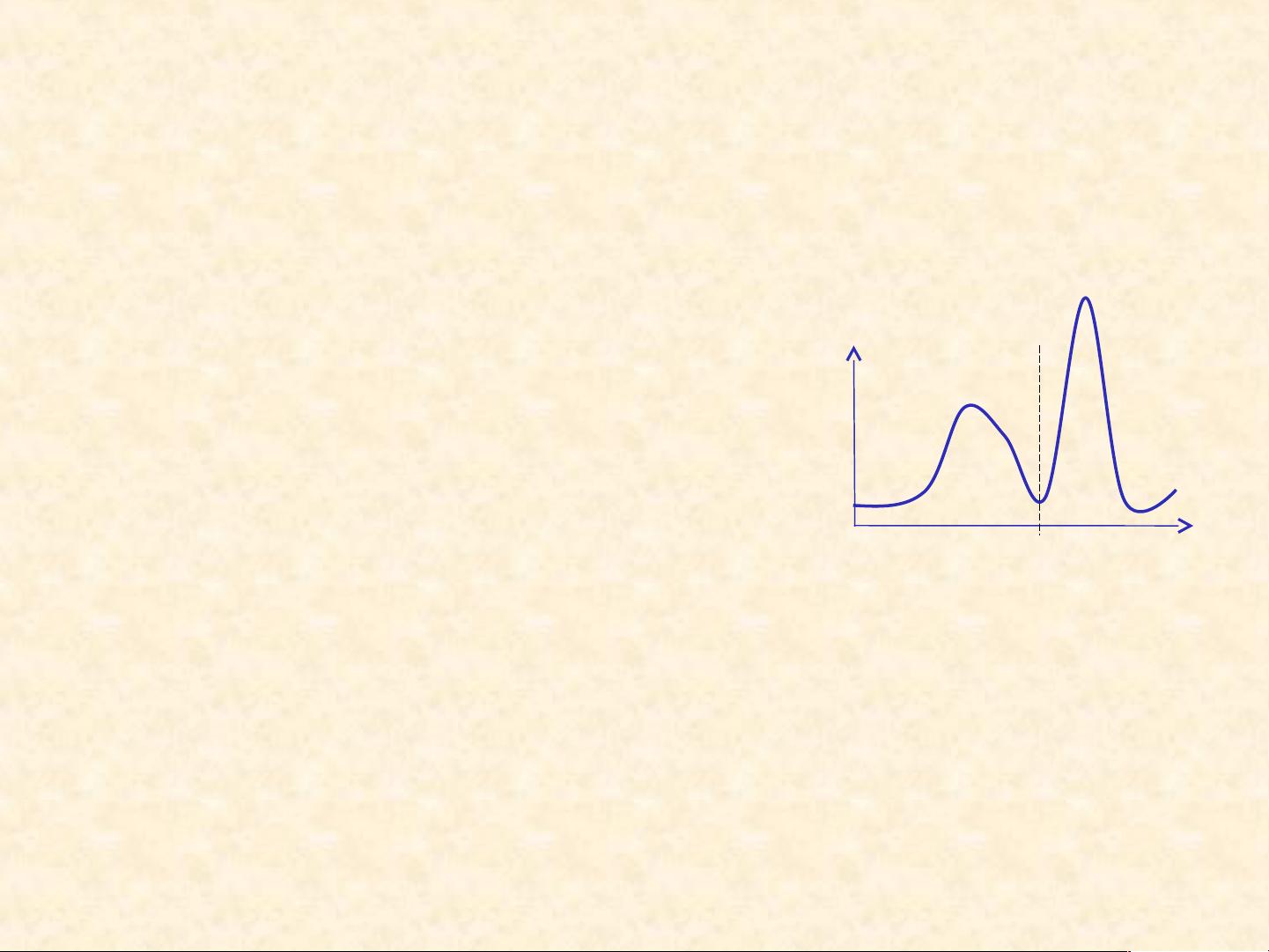

3. **聚类算法**:有很多种聚类算法,如K-means、层次聚类、DBSCAN等。K-means是一种迭代算法,通过不断调整类别中心(质心)和分配样本至最近的类别,直到类别不再改变或达到预设迭代次数。层次聚类则构建了一个反映样本相似性的树状结构,可以是自底向上(凝聚型)或自顶向下(分裂型)。DBSCAN基于密度的聚类算法,能够发现任意形状的聚类并能处理噪声点。

4. **聚类的主观性**:由于非监督学习中缺乏明确的类别标签,聚类结果往往带有一定程度的主观性。这意味着不同聚类算法或参数设置可能会得到不同的结果,因此理解领域知识以及选择合适的聚类方法至关重要。

5. **聚类过程**:基本的顺序聚类算法,如这里提到的,通常从一个初始聚类开始,然后逐步将新的样本分配到最近的类,或者在满足特定条件时创建新的聚类。这个过程会持续到所有样本被分配或达到预设的聚类数量。

非监督模式识别提供了一种探索和理解无标签数据集内在结构的方法,通过相似性度量和聚类算法,我们可以发现数据的隐藏模式,这对于数据挖掘、市场细分、异常检测等应用场景具有重要的价值。然而,由于其主观性和依赖领域知识的特点,合理选择和评估聚类方法显得尤为重要。

2021-09-21 上传

2022-06-23 上传

2021-10-18 上传

2022-06-20 上传

2022-02-22 上传

2014-04-29 上传

2010-11-24 上传

2009-05-18 上传

2021-09-23 上传

keepfast

- 粉丝: 0

- 资源: 6

最新资源

- Java毕业设计项目:校园二手交易网站开发指南

- Blaseball Plus插件开发与构建教程

- Deno Express:模仿Node.js Express的Deno Web服务器解决方案

- coc-snippets: 强化coc.nvim代码片段体验

- Java面向对象编程语言特性解析与学生信息管理系统开发

- 掌握Java实现硬盘链接技术:LinkDisks深度解析

- 基于Springboot和Vue的Java网盘系统开发

- jMonkeyEngine3 SDK:Netbeans集成的3D应用开发利器

- Python家庭作业指南与实践技巧

- Java企业级Web项目实践指南

- Eureka注册中心与Go客户端使用指南

- TsinghuaNet客户端:跨平台校园网联网解决方案

- 掌握lazycsv:C++中高效解析CSV文件的单头库

- FSDAF遥感影像时空融合python实现教程

- Envato Markets分析工具扩展:监控销售与评论

- Kotlin实现NumPy绑定:提升数组数据处理性能