利用Hadoop实现分布式文件系统中的图片存储优化

需积分: 9 163 浏览量

更新于2024-09-11

收藏 256KB PDF 举报

"基于分布式文件系统的图片存储服务的研究"

这篇研究论文主要探讨了如何利用分布式文件系统构建一个高效的图片存储服务。文章首先深入剖析了分布式文件系统的三个核心特性:

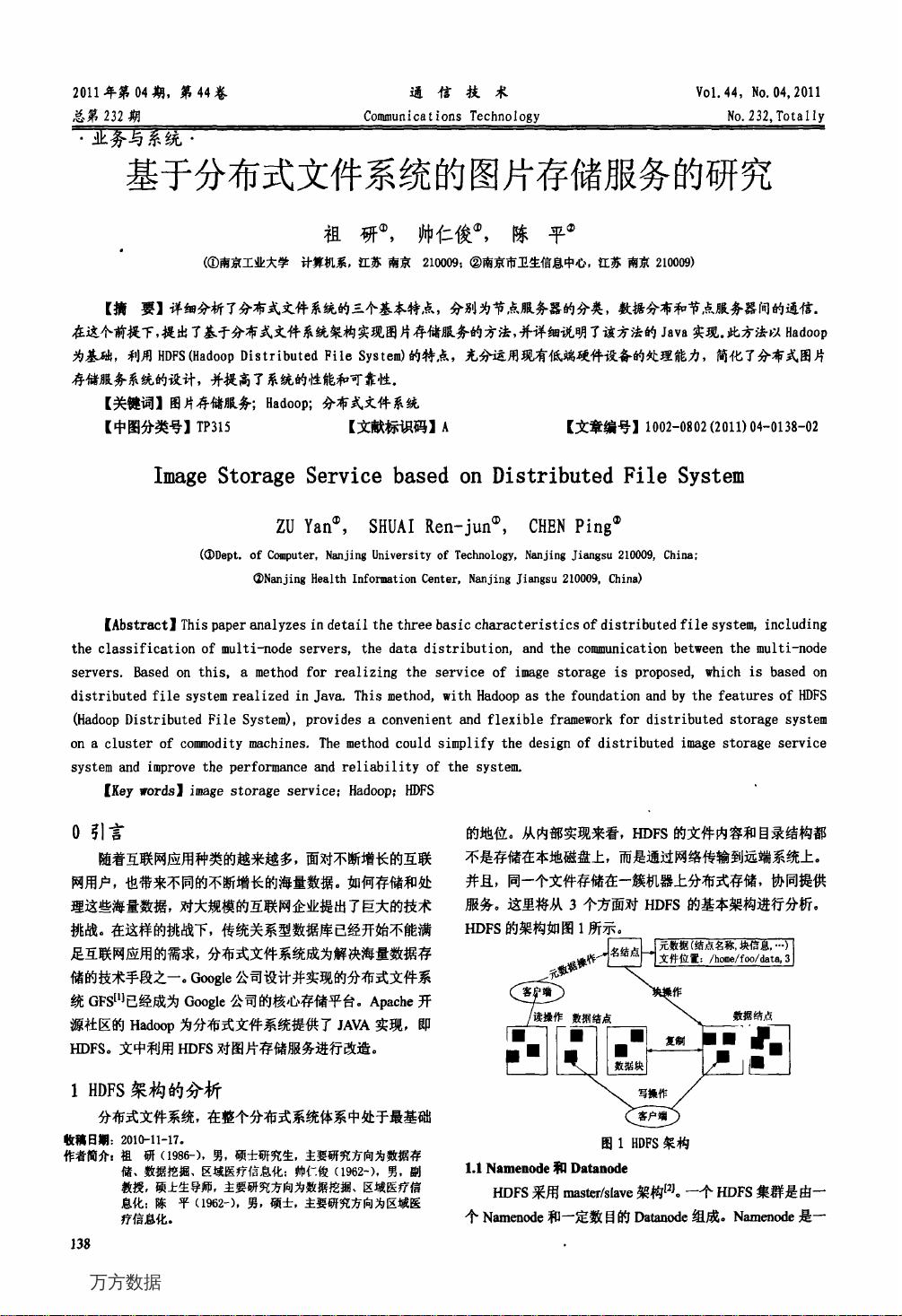

1. 节点服务器的分类:分布式文件系统通常由多个节点服务器组成,这些节点根据功能和角色可以分为数据节点、名称节点等。数据节点负责存储实际的数据块,而名称节点则维护整个文件系统的元数据,包括文件到数据块的映射关系。

2. 数据分布:在分布式文件系统中,数据被分割成多个块,并且这些块会被复制到多个节点上,以提高数据的可用性和容错性。这种策略使得读取和写入操作可以并行进行,提升了系统的整体性能。

3. 节点服务器间的通信:各个节点之间通过网络进行通信,协同完成数据的存取和复制。这种通信机制保证了数据的一致性和完整性。

论文接着提出了一种基于Hadoop分布式文件系统(HDFS)实现图片存储服务的方法。HDFS是Apache Hadoop项目的一部分,它设计为运行在廉价的硬件上,能够处理大规模数据。通过HDFS,图片文件可以被分割成多个块,并在集群的不同节点上进行分布式存储,从而实现高吞吐量的数据访问。

论文详细阐述了这种方法的Java实现,这通常涉及到对Hadoop的MapReduce框架的应用,用于处理数据的分发和计算。Map阶段将任务分解,Reduce阶段则负责整合结果。在图片存储服务中,Map可能用于数据切分,而Reduce则用于合并和写入数据块。

此外,论文还强调了这种方法的优势,如利用低成本硬件扩展存储能力,通过数据冗余提高系统可靠性,以及通过并行处理提升读写速度。同时,由于HDFS具有良好的容错机制,即使有节点故障,也能保证数据的可访问性。

关键词包括“图片存储服务”、“Hadoop”和“分布式文件系统”,表明本研究集中在使用开源的Hadoop框架解决大规模图片存储的问题,目标是提高存储效率和系统稳定性。

这篇论文提供了一个实用的解决方案,对于那些需要处理大量图片数据的企业或机构来说,是一个值得参考的技术方向。通过采用分布式文件系统,特别是HDFS,可以构建出一个可扩展、可靠的图片存储服务,以应对日益增长的图像数据存储需求。

2021-08-09 上传

点击了解资源详情

2021-08-08 上传

2021-08-09 上传

2021-08-09 上传

2021-08-09 上传

2024-10-01 上传

2021-08-08 上传

2021-06-28 上传

rujigochsh

- 粉丝: 0

- 资源: 4

最新资源

- NIST REFPROP问题反馈与解决方案存储库

- 掌握LeetCode习题的系统开源答案

- ctop:实现汉字按首字母拼音分类排序的PHP工具

- 微信小程序课程学习——投资融资类产品说明

- Matlab犯罪模拟器开发:探索《当蛮力失败》犯罪惩罚模型

- Java网上招聘系统实战项目源码及部署教程

- OneSky APIPHP5库:PHP5.1及以上版本的API集成

- 实时监控MySQL导入进度的bash脚本技巧

- 使用MATLAB开发交流电压脉冲生成控制系统

- ESP32安全OTA更新:原生API与WebSocket加密传输

- Sonic-Sharp: 基于《刺猬索尼克》的开源C#游戏引擎

- Java文章发布系统源码及部署教程

- CQUPT Python课程代码资源完整分享

- 易语言实现获取目录尺寸的Scripting.FileSystemObject对象方法

- Excel宾果卡生成器:自定义和打印多张卡片

- 使用HALCON实现图像二维码自动读取与解码