XMem:长视频对象分割的Atkinson-Shiffrin记忆模型架构

PDF格式 | 6.23MB |

更新于2024-06-19

| 192 浏览量 | 举报

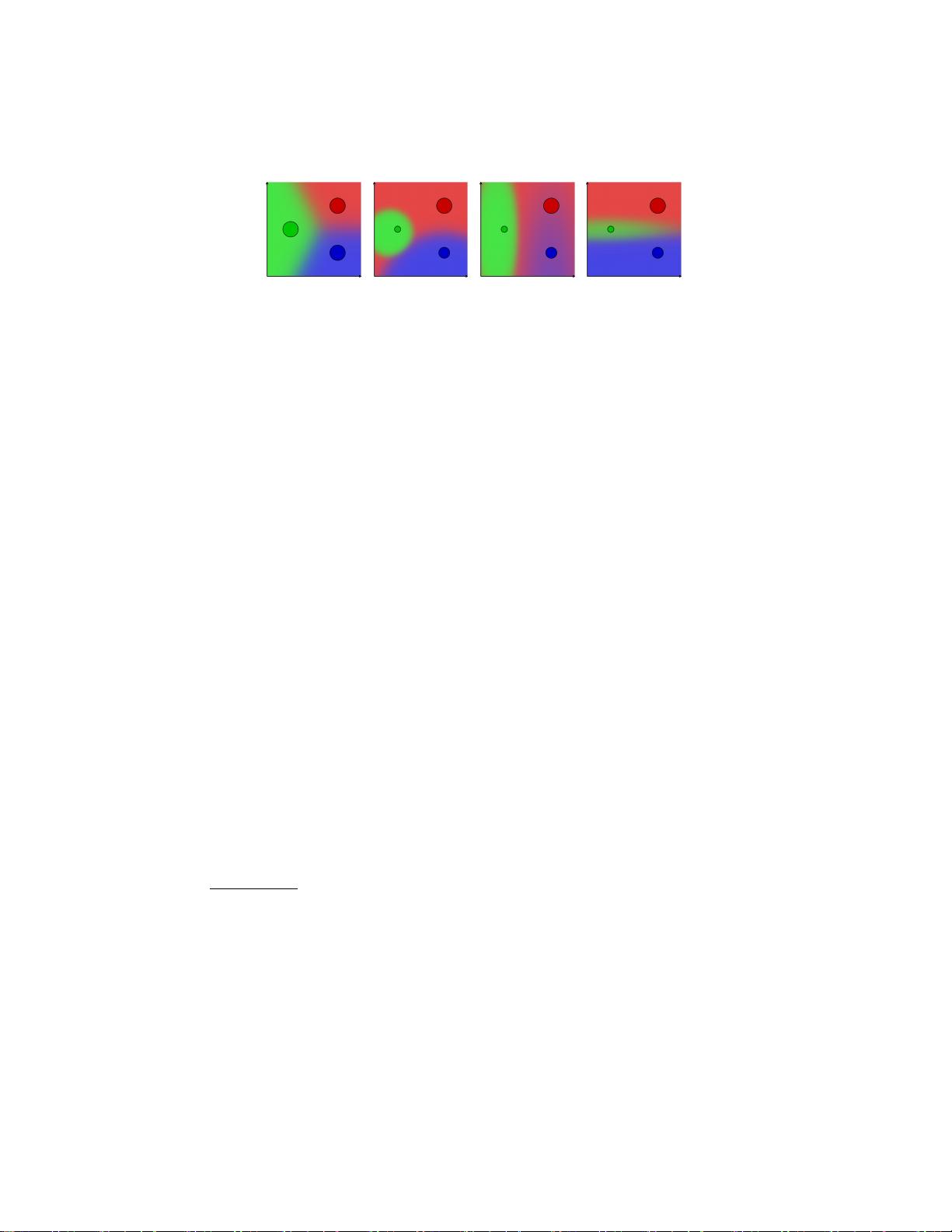

"XMem是基于Atkinson-Shiffrin记忆模型的视频对象分割架构,旨在解决长视频处理中的内存消耗和准确性问题。该架构引入了多层次的特征记忆存储,包括快速更新的感觉记忆、高分辨率的工作记忆和紧凑的长期记忆。通过记忆潜能算法,XMem有效地整合工作记忆元素到长期记忆,防止记忆爆炸并保持长期预测的性能。在长视频数据集上,XMem表现出超越现有先进方法的性能,同时在处理短视频时也具备良好的适应性。"

XMem的核心在于它借鉴了心理学中的Atkinson-Shiffrin模型,这是一个经典的多存储模型,它将记忆分为感觉记忆、工作记忆和长期记忆三个阶段。在视频对象分割任务中,这种分层记忆模型被用来高效地处理视频序列中的对象信息。

首先,感觉记忆是短暂的,用于快速捕获和更新每一帧的新特征。它提供了对最新信息的即时访问,但存储容量有限。其次,工作记忆具有较高的分辨率,用于存储和处理当前关键的视觉信息,例如对象的精确轮廓和运动轨迹。工作记忆在处理复杂的场景变化和遮挡时起着关键作用。最后,长期记忆则是一个更持久且紧凑的存储,用于保存经过时间的、重要的信息,如对象的全局特征和长期运动模式。

为了在长视频中维持高效和准确的分割,XMem引入了一种记忆潜能算法。这种算法能够识别和整合那些频繁被引用的工作记忆元素,将它们转移到长期记忆中。这样做不仅减少了工作记忆的负担,防止了内存占用过大,而且有助于保持长期预测的准确性,因为长期记忆中的信息更稳定,不易受到短期噪声的影响。

此外,XMem还设计了一种新的内存读取机制,这使得模型能够根据当前上下文智能地从不同层次的记忆中检索信息。这在处理长视频时特别重要,因为视频中的对象可能会经历各种复杂的变化,如遮挡、光照变化和相似背景的干扰。

与传统的在线学习方法相比,XMem不依赖于训练时的网络权重更新,从而实现了更快的预测速度。而与递归方法相比,XMem通过多层次记忆系统减少了信息漂移和封闭问题的风险。在DAVIS2017等长视频数据集上的实验结果显示,XMem在性能上超越了现有的先进方法,同时在短视频数据集上也能展现出竞争力,证明了其对不同视频长度的适应性。

XMem是一个创新的视频对象分割框架,它利用人类记忆模型来优化特征存储和信息传播,为长视频分割提供了有效且高效的解决方案。通过集成和管理不同层次的记忆,XMem有望推动视频理解技术在实时和在线应用中的进一步发展。

相关推荐

cpongm

- 粉丝: 6

最新资源

- MATLAB实现ART与SART算法在医学CT重建中的应用

- S2SH整合版:快速搭建Struts2+Spring+Hibernate开发环境

- 托奇卡项目团队成员介绍

- 提升外链发布效率的SEO推广神器——搜易达网络推广大师v2.035

- C#打造简易记事本应用详细教程

- 探索虚拟现实地图VR的奥秘

- iOS模拟器屏幕截图新工具

- 深入解析JavaScript在生活应用开发中的运用

- STM32F10x函数库3.5中文版详解与应用

- 猎豹浏览器v6.0.114.13396 r1:安全防护与网购敢赔

- 掌握JS for循环输出的最简洁代码技巧

- Java入门教程:TranslationFileGenerator快速指南

- OpenDDS3.9源码解析及最新文档指南

- JavaScript提示框插件:鼠标滑过显示文章摘要

- MaskRCNN气球数据集:优质图像识别资源

- Laravel日志查看器:实现Apache多站点日志统一管理