Adaboost与K-Means算法解析:设计思想与步骤

需积分: 0 37 浏览量

更新于2024-08-05

收藏 706KB PDF 举报

"这篇资源包含了两个部分,第一部分是关于Adaboost算法的解释,第二部分涉及K-Means聚类算法的原理和步骤。"

**Adaboost算法设计思想与计算步骤**

Adaboost(Adaptive Boosting)是一种集成学习方法,其核心在于通过多次迭代,将多个弱分类器组合成一个强分类器。设计思想如下:

1. **弱学习器提升**:Adaboost使用弱学习算法(如决策树),通过多次迭代,让每次迭代聚焦于前一次迭代中分类错误的样本,提升它们的权重。

2. **加权多数投票**:每个弱分类器的权重由其在训练集上的分类错误率决定。错误率低的分类器在最终模型中占更大比重。

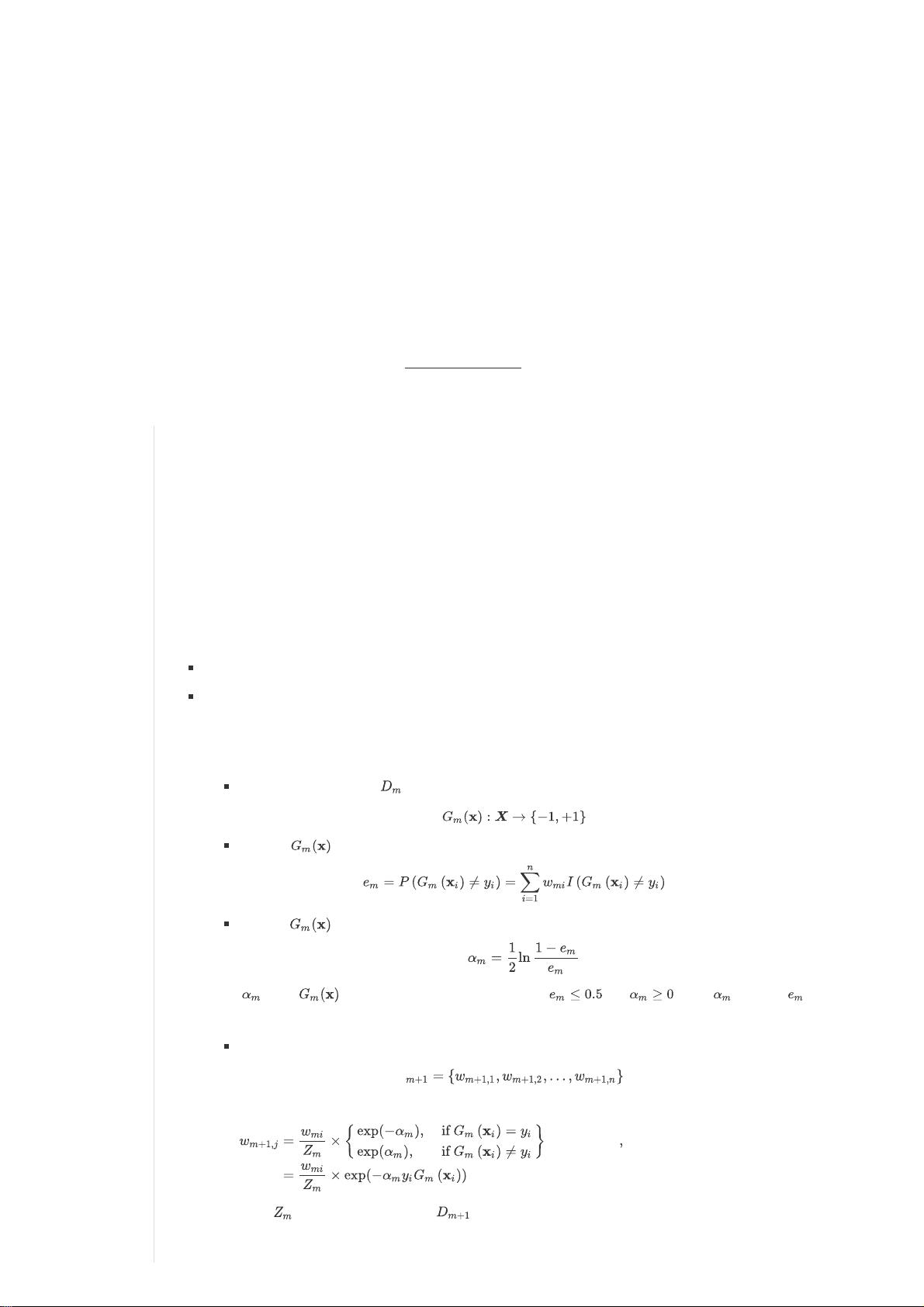

**计算步骤主要包括:**

1. **初始化权重**:给所有训练样本分配相同的初始权重。

2. **迭代**:重复以下步骤m次:

a. 使用当前权重分布训练弱分类器。

b. 计算分类错误率。

c. 计算贡献系数α,它反映了分类器的性能,错误率小的分类器α值大。

d. 更新权重:正确分类的样本权重降低,错误分类的样本权重增加,保持总权重为1。

3. **构造最终分类器**:将所有弱分类器以α为权重加权组合,形成强分类器。

**K-Means聚类算法原理与计算步骤**

1. **混合高斯密度估计视角**:K-Means可以看作是特定条件下的混合高斯模型,即假设每个类别为一个单高斯分布,且各类别的协方差矩阵为单位矩阵。

2. **算法步骤**:

- **初始化**:选择k个初始质心(类中心)。

- **分配样本**:根据样本到质心的距离,将每个样本分配到最近的类。

- **更新质心**:重新计算每个类的质心,通常取该类内所有样本的均值。

- **迭代**:重复分配和更新质心,直到质心不再显著移动或达到预设迭代次数。

3. **影响因素**:

- **初始质心的选择**:不同的初始设置可能导致不同的聚类结果。

- **样本噪声**:噪声样本可能影响聚类效果。

- **K值的设定**:K值的大小直接影响聚类数量和质量,需要根据实际问题选择合适值。

- **样本分布**:非凸、不规则或密集分布的数据可能使K-Means效果不佳。

总结来说,Adaboost和K-Means都是机器学习中重要的算法。Adaboost通过组合弱分类器构建强分类器,而K-Means则是基于距离的无监督聚类方法,两者分别在分类和无监督学习领域有广泛应用。

2021-10-25 上传

2021-10-12 上传

2021-11-10 上传

2021-08-07 上传

2021-09-09 上传

2008-05-30 上传

2021-08-19 上传

2021-09-11 上传

2021-08-19 上传

嘻嘻哒的小兔子

- 粉丝: 34

- 资源: 321

最新资源

- NIST REFPROP问题反馈与解决方案存储库

- 掌握LeetCode习题的系统开源答案

- ctop:实现汉字按首字母拼音分类排序的PHP工具

- 微信小程序课程学习——投资融资类产品说明

- Matlab犯罪模拟器开发:探索《当蛮力失败》犯罪惩罚模型

- Java网上招聘系统实战项目源码及部署教程

- OneSky APIPHP5库:PHP5.1及以上版本的API集成

- 实时监控MySQL导入进度的bash脚本技巧

- 使用MATLAB开发交流电压脉冲生成控制系统

- ESP32安全OTA更新:原生API与WebSocket加密传输

- Sonic-Sharp: 基于《刺猬索尼克》的开源C#游戏引擎

- Java文章发布系统源码及部署教程

- CQUPT Python课程代码资源完整分享

- 易语言实现获取目录尺寸的Scripting.FileSystemObject对象方法

- Excel宾果卡生成器:自定义和打印多张卡片

- 使用HALCON实现图像二维码自动读取与解码

已收录资源合集

已收录资源合集