Flume安装与实战:从入门到AvroSource应用

需积分: 50 53 浏览量

更新于2024-09-11

收藏 584KB DOCX 举报

"本资源主要介绍了如何安装和使用Flume,包括两个具体的应用实例,涉及到Flume与Kafka、大数据相关的技术。"

Apache Flume 是一个分布式、可靠且可用于有效收集、聚合和移动大量日志数据的系统。它具有简单的设计,能够处理各种数据源,如网络数据流和静态文件,并将数据传输到各种存储系统,如HDFS或HBase。在大数据领域,Flume通常用于日志管理和数据集成。

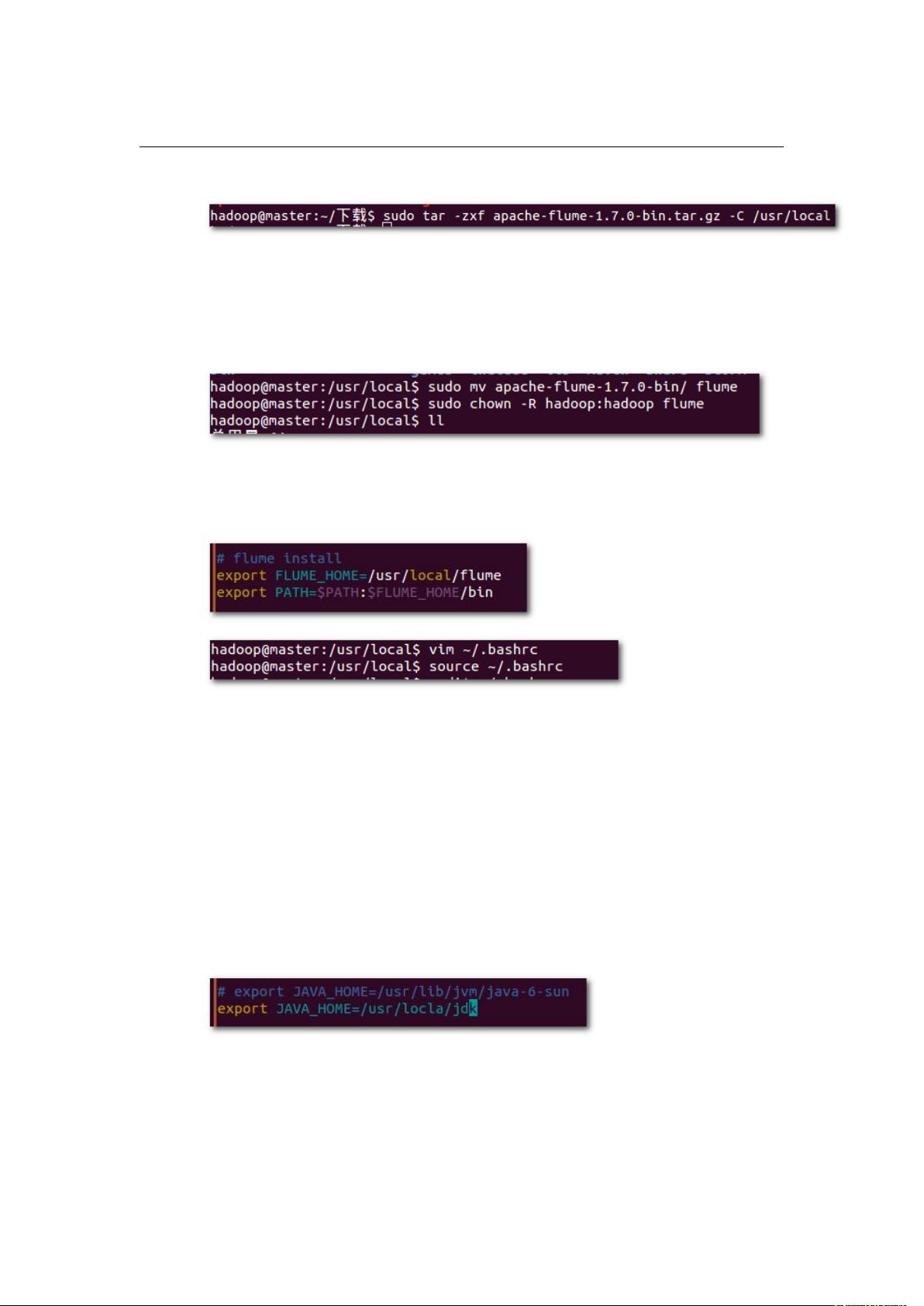

在安装Flume的过程中,首先需要下载Flume的安装包,然后将其解压缩到 `/usr/local` 目录下。在这个例子中,我们使用的版本是 Apache Flume 1.7.0。解压后,为了方便管理,通常会将安装目录重命名。接着,通过 `chown` 命令更改Flume文件夹的所有者,使其归属于 `hadoop` 用户和组。为了使Flume可执行,需要将其路径添加到环境变量 `PATH` 中,这可以通过编辑 `~/.bashrc` 文件完成,然后使用 `source ~/.bashrc` 使更改立即生效。

配置Flume时,需要修改 `flume-env.sh` 文件,设置 `JAVA_HOME` 指向Java运行环境的路径,这对于Flume的正常运行至关重要。最后,通过运行 `flume-ng version` 命令来验证Flume是否已成功安装。

在应用Flume的实例中,第一个实例展示了如何使用AvroSource。AvroSource是一种数据源,可以从Avro客户端接收数据。在此案例中,Flume配置了一个名为 `a1` 的agent,该agent包含一个源头(source)`r1`,一个接收器(sink)`k1`,以及一个通道(channel)`c1`。源头 `r1` 类型设置为 Avro,监听 `0.0.0.0` 的 `4141` 端口,等待Avro数据的接入。接收器 `k1` 类型设置为 logger,意味着它将接收到的数据记录到控制台。通道 `c1` 类型设置为内存,这意味着它会在内存中临时存储事件。

这个配置文件 `avro.conf` 的创建,是启动Flume agent并开始接收Avro数据的前提。一旦Flume运行,AvroSource可以读取指定文件并将其内容通过Flume传输,而Flume则会将这些信息输出到控制台上。

第二个实例虽然未在摘要中详细说明,但通常可能涉及到将Flume与其他组件(如Kafka)集成,用于更复杂的数据流处理,比如从Kafka主题中消费数据,然后通过Flume将数据发送到其他目的地。

总结来说,Flume的安装和使用涉及配置环境、编辑配置文件以定义数据流的流向,以及选择合适的源、Sink和Channel类型以适应不同的数据处理需求。通过Flume,我们可以构建灵活的日志收集和传输解决方案,实现大数据的高效管理和分析。

279 浏览量

277 浏览量

131 浏览量

125 浏览量

186 浏览量

271 浏览量

2024-12-11 上传

255 浏览量

长安一片月

- 粉丝: 13

最新资源

- VS2010环境Qt链接MySQL数据库测试程序

- daycula-vim主题:黑暗风格的Vim色彩方案

- HTTPComponents最新版本发布,客户端与核心组件升级

- Android WebView与JS互调的实践示例

- 教务管理系统功能全面,操作简便,适用于winxp及以上版本

- 使用堆栈实现四则运算的编程实践

- 开源Lisp实现的联合生成算法及多面体计算

- 细胞图像处理与模式识别检测技术

- 深入解析psimedia:音频视频RTP抽象库

- 传名广告联盟商业正式版 v5.3 功能全面升级

- JSON序列化与反序列化实例教程

- 手机美食餐饮微官网HTML源码开源项目

- 基于联合相关变换的图像识别程序与土豆形貌图片库

- C#毕业设计:超市进销存管理系统实现

- 高效下载地址转换器:迅雷与快车互转

- 探索inoutPrimaryrepo项目:JavaScript的核心应用