YOLOv5-v6.0解读与标注:训练、测试和部署指南

需积分: 27 117 浏览量

更新于2024-08-05

收藏 12.83MB PDF 举报

"YOLOv5-v6.0-标注.pdf"

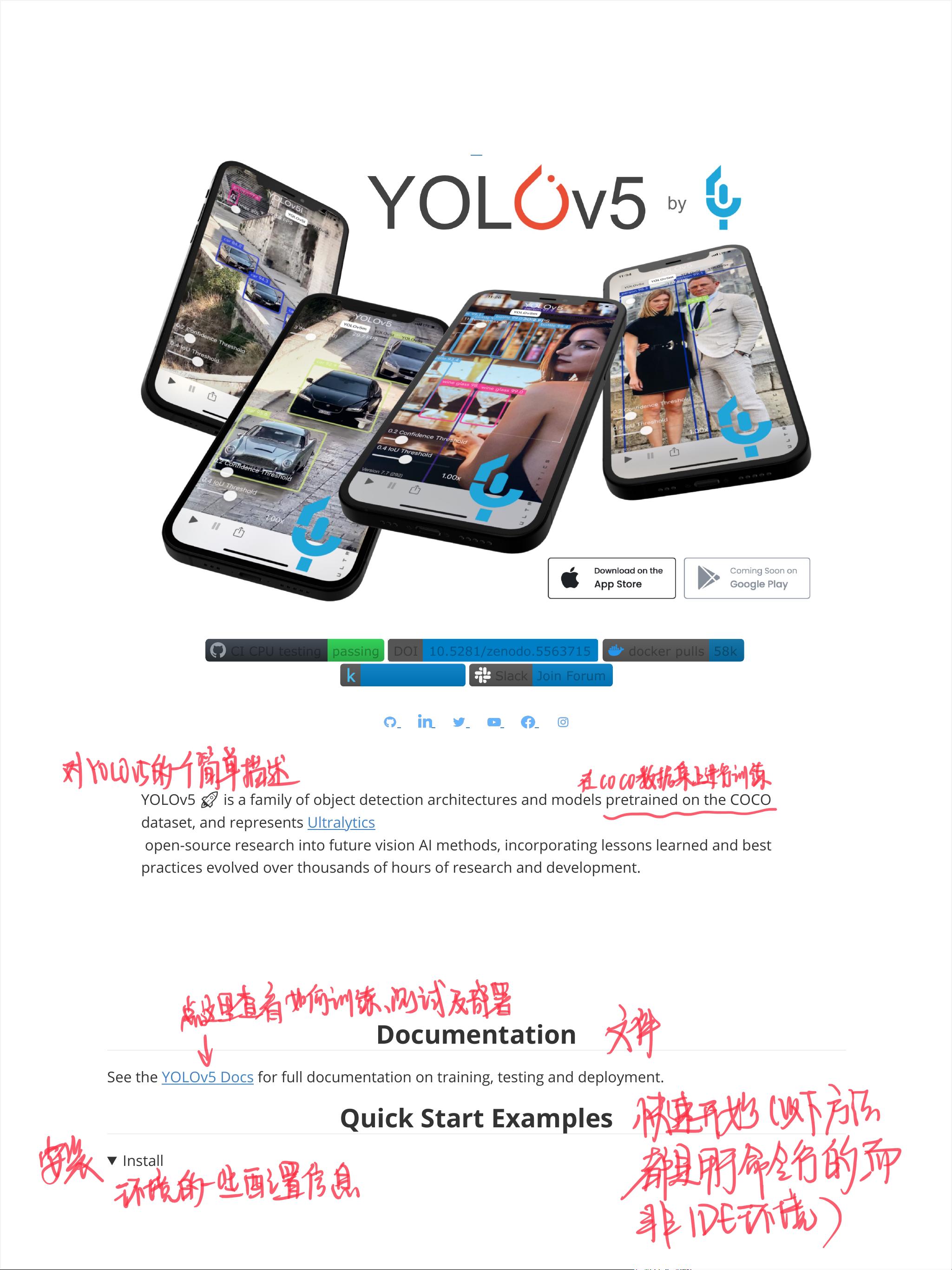

YOLOv5是一个基于PyTorch的对象检测架构系列,代表了Ultralytics的开源研究,专注于未来AI视觉方法的探索。该框架集成了经过数千小时研究和开发积累的经验教训和最佳实践。YOLOv5家族的模型已经在COCO数据集上预训练,用于对象检测任务。

在安装方面,你需要`requirements.txt`中的所有依赖,包括特定的库和版本。确保你的环境符合`2[VJQP!`的要求,这意味着你需要安装最新的依赖项,例如`2[6QTEJ!`,这通常是指PyTorch和相关的库。

进行推断(Inference)时,YOLOv5模型可以通过PyTorch Hub方便地使用。当你运行`detect.py`脚本时,它会自动从最新版本的YOLOv5发布版下载模型,并将结果保存到指定的输出路径,如`UXQVGHWHFW`。

训练(Training)过程在COCO数据集上进行。首次使用时,数据集会自动下载。为了复现训练结果,你需要运行下面的命令。YOLOv5的训练时间会因模型大小和硬件配置的不同而有所变化。通常,小尺寸的模型如YOLOv5s训练速度较快,而大尺寸的模型如YOLOv5x则需要更长的时间,但可能会提供更高的检测精度。

YOLOv5的训练流程可能包括数据预处理、模型选择、超参数设置、训练迭代以及验证阶段。在训练期间,模型会学习从输入图像中识别不同类别的目标,并通过损失函数优化来调整权重。YOLOv5采用了多种技术来提高检测性能,比如批归一化、锚框机制、多尺度训练等。

YOLOv5的文档详细介绍了如何进行训练、测试和部署。对于训练,你可以调整学习率策略、批次大小、训练轮数等参数。测试时,可以评估模型在验证集或测试集上的性能,通常使用指标如平均精度(mAP)、召回率等。最后,部署模型时,你可以将其转换为更轻量级的格式,便于在嵌入式设备或移动应用上运行。

YOLOv5-v6.0是一个强大的对象检测框架,提供了丰富的文档和工具,使得研究人员和开发者能够便捷地进行模型训练、推断和部署。通过不断的学习和优化,YOLOv5持续推动着计算机视觉领域的进步。

2022-02-11 上传

2018-01-24 上传

2021-06-29 上传

2009-02-28 上传

2013-01-16 上传

2022-09-23 上传

2018-11-16 上传

189 浏览量

2022-03-08 上传

橙橙小狸猫

- 粉丝: 188

- 资源: 10

最新资源

- play-bootstrap:用于Bootstrap的Play框架库

- koa-fetchr:Fetchr 的中间件和 Koa 的兼容性包装器

- 基于GA遗传优化的TSP最短路径计算仿真

- TPV2-P2:还有一个理由不雇用我

- pepper-metrics:Pepper Metrics是一个工具,它可以帮助您使用RED方法收集运行时性能,然后将其输出为日志时间序列数据,默认情况下,它使用prometheus作为数据源,使用grafana作为UI

- 演讲少-项目开发

- LuaLSP:支持魔兽世界API的Lua语言服务器协议

- spsstonybrook.github.io

- MySpider:Java网络爬虫MySpider,特点是组件化,可插拔式的,可以根据一套接口实现你自己自定义的网络爬虫需求(本人JavaSE的温习项目,适合java新人)

- 基于ATtiny13的键控简单调光器-电路方案

- h2-h3-automated-measurement:自动测量h2和h3的工具

- pcb2gcode:此存储库已停产,开发仍在继续

- compass:Compass是一个轻量级的嵌入式分布式数据库访问层框架

- privacy-terms-observatory:隐私权条款天文台是已发布的隐私权和热门网站条款的存档

- 美团双buffer分布式ID生成系统

- *(星号)-项目开发