Global Transformer Tracking解析:多目标追踪新方法

需积分: 44 72 浏览量

更新于2024-08-04

收藏 11.38MB PDF 举报

"本文主要解析2022年CVPR会议上发表的‘Global Transformer Tracking’论文中的公式,探讨多目标追踪技术,特别是如何利用全局变换器进行目标检测和跟踪。"

在多目标追踪(Multi-Object Tracking, MOT)领域,Global Transformer Tracking论文提出了一种新的方法,它结合了目标检测和追踪,打破了传统的Tracking-by-Detection范式。该方法通过全局变换器(Global Transformer)来处理图像序列,以实现更高效且准确的目标关联。

1. **目标检测与追踪的分解**:

在传统的Tracking-by-Detection框架中,追踪任务分为两步:首先进行目标检测,生成一系列候选目标,然后进行数据关联,将这些候选目标与历史轨迹相匹配。Global Transformer Tracking则尝试同时处理这两个步骤,通过全局上下文信息增强目标检测和追踪的关联性。

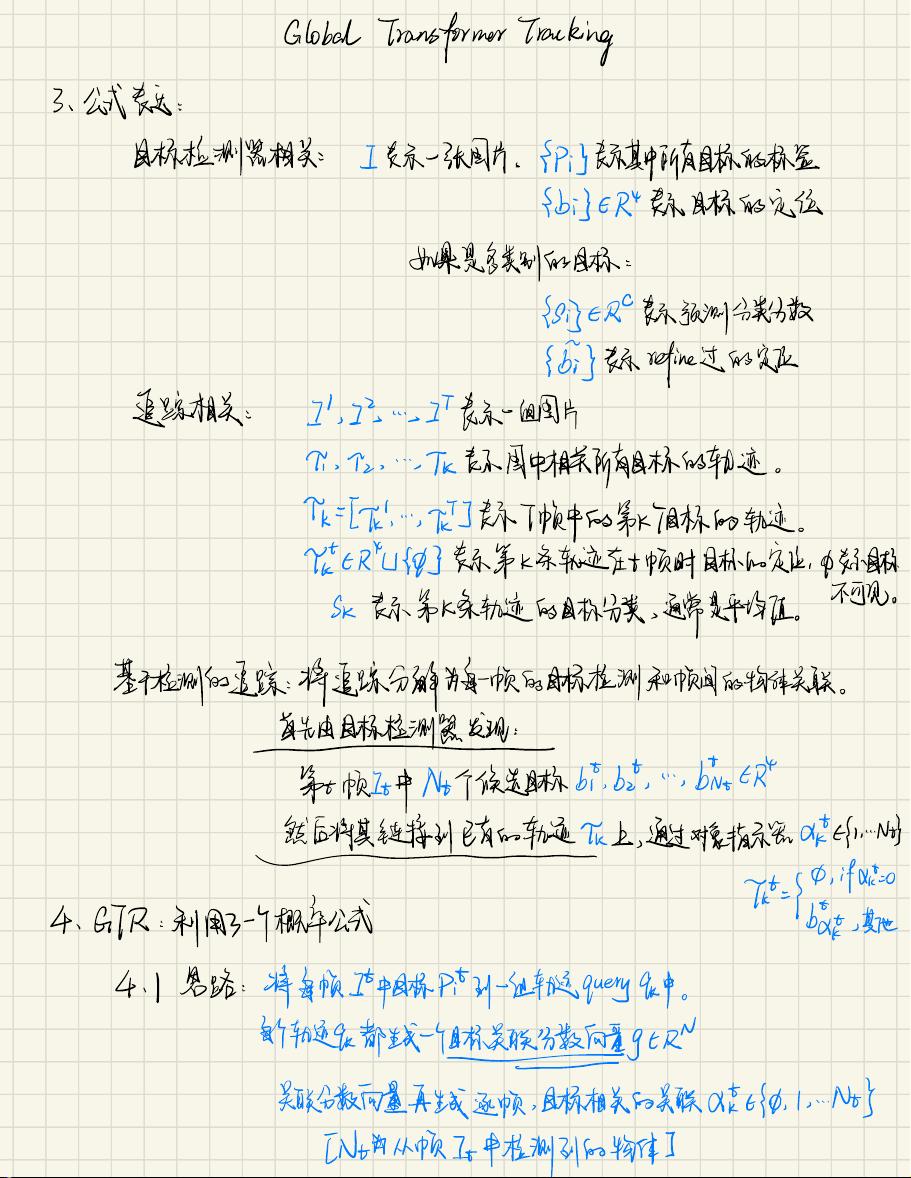

2. **公式解析**:

- **目标检测相关**:用{bi}表示图像中的目标标签,它们属于类别集合{Ci},并且每个目标都有一个边界框定义bi ε R^4。对于多类别目标,Si ε RC表示预测的分类分数。

- **追踪相关**:Ii表示图像序列,πk表示轨迹,其中k表示轨迹编号,t表示时间帧,Lu表示第k条轨迹在时间t的目标定位,SK表示轨迹的分类。

3. **全局变换器的运作**:

- **基于检测的追踪**:每帧图像通过目标检测器产生N0个候选目标,然后利用对象指示器αk将这些候选目标与已有轨迹进行匹配。关联分数向量^γgt用于表示这种关联性。

- **轨迹生成与关联**:对于每帧图像I,目标Pi与轨迹query q生成关联分数向量g(qk, F),其中F包含目标特征。softmax操作将这些分数转换为概率分布,用于确定目标与轨迹的匹配。

4. **训练过程**:

- **两阶段训练**:Global Transformer Tracking的训练分为两个阶段,首先进行目标检测器的训练,然后对全局变换器进行联合训练,优化目标检测和追踪的联合概率。

- **非极大值抑制(NMS)**:在目标检测中,NMS用于去除重复的检测结果,确保每个目标只有一个边界框。在Global Transformer Tracking中,这个机制被考虑进来,以确保在轨迹上的分布与目标框的分布一致。

5. **最终目标关联**:

- **Softmax映射**:最终的关联分数通过softmax操作转化为概率,表示为PA(α0|i|qk,F),其中i对应于每个目标,j对应于所有可能的关联。这个概率分布用于决定每个目标应该关联到哪个轨迹。

- **目标分配**:通过将框上的分布转化为轨迹上的分布,如PT(π|qk,F),可以计算出每个轨迹的可能性,从而进行目标分配。

Global Transformer Tracking通过全局信息的处理,改进了多目标追踪的效率和准确性,尤其是在复杂的场景中,能够更好地维持目标的连续性和一致性。其创新之处在于将目标检测与追踪融合,通过全局变换器进行端到端的学习,提升了整个系统的性能。

2022-09-24 上传

2016-01-08 上传

2010-12-03 上传

2024-04-18 上传

点击了解资源详情

2023-05-31 上传

2023-06-28 上传

2023-07-27 上传

zz的大穗禾

- 粉丝: 247

- 资源: 13

最新资源

- 讨论论坛:学习React-Redux

- INAI Host-crx插件

- ink-enhancement

- GoodNewsExtends:10月CMS插件扩展了GoodNews插件

- spacebox

- operating-system-x86-64bit:具有TARFS文件系统的x86体系结构(64位)的基本操作系统。 使用INT $ 80支持fork(),cow(),分页,虚拟memoryring3用户进程和syscall。 能够运行shell和二进制文件:ls,cat,echo,kill,ps,sleep

- jQuery网页瀑布流插件masonry

- MATLAB-Application-in-Mathematical-Modeling

- dashboard:带有laravel和Chart.js的仪表板项目

- 社交锻炼应用:社交健身者

- NoteCatcher:NoteCatcher 是一个用于笔记的 Web 应用程序。 :file_cabinet:Firebase :man_technologist:Python :link:Microsoft Azure

- exprz:表达式库

- Maise data gathering tool-crx插件

- capstone-project:体式的克隆

- linux-device-driver-tutorial:本教程讨论了开发自己的linux设备驱动程序的技术问题。 本教程的目的是提供简单实用的示例,以便每个人都能以简单的方式理解概念

- reddit-spyglass:允许您查看 reddit 帖子分数,即使它们被隐藏