DPOD:深度学习驱动的3D对象检测与6D姿态估计新法

PDF格式 | 928KB |

更新于2025-01-16

| 18 浏览量 | 举报

DPOD: 3D对象检测和6D姿态估计方法的研究

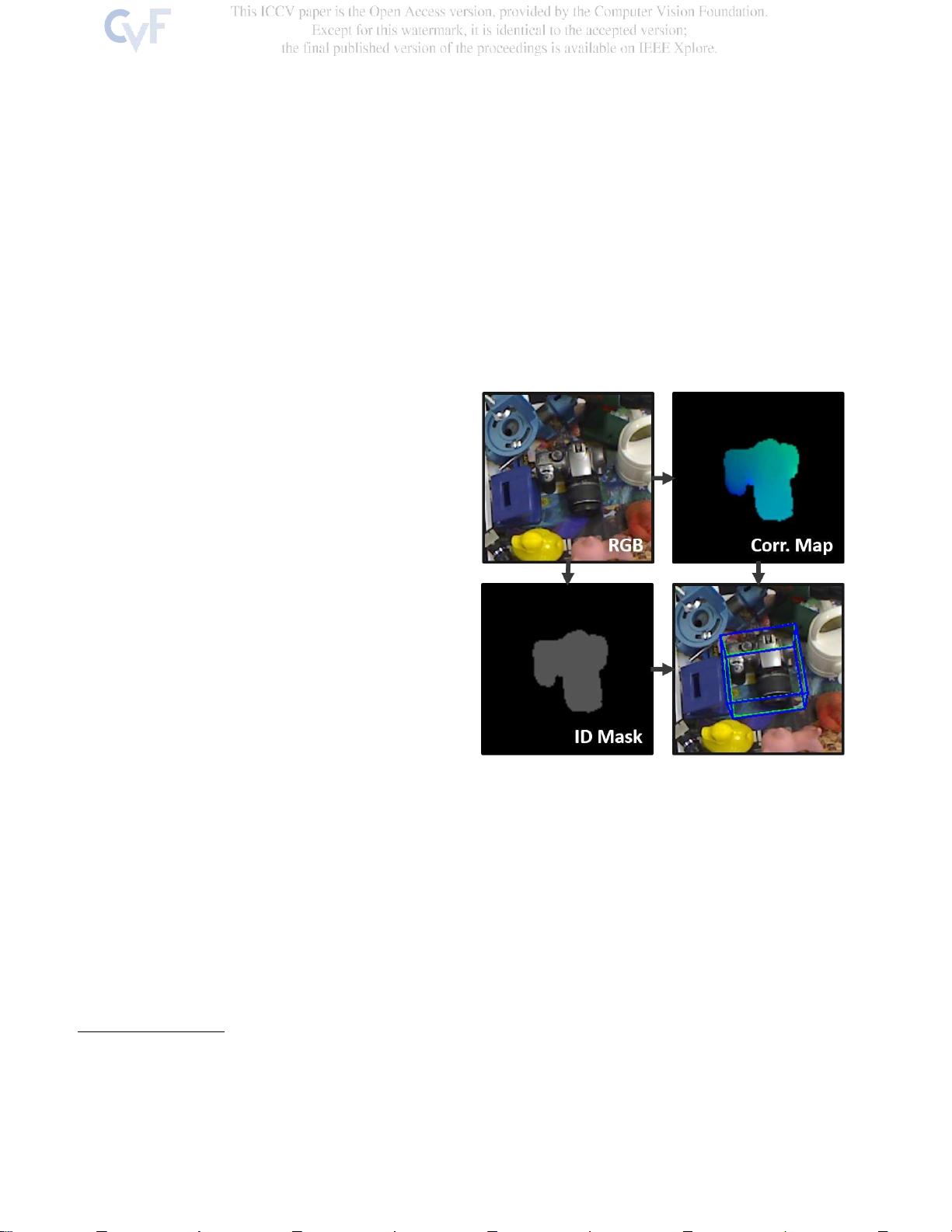

在这个深度学习驱动的计算机视觉领域,本文提出了一种创新的方法,称为密集姿态对象检测器 (DPOD),专用于从RGB图像中进行3D对象检测和6D姿态估计。DPOD的核心在于利用深度学习技术来处理复杂的2D-3D对应关系,通过像素级匹配,找出输入图像中物体的精确位置并确定其在三维空间中的精确姿态,包括六个自由度 (6DoF):平移和旋转。

传统的目标检测器,如R-CNN系列、YOLO和SSD,虽然在局部区域识别上表现出色,但针对需要全面理解物体三维位置的应用,如增强现实、机器人导航或机器视觉,仅靠边界框定位是不够的。DPOD通过首先预测每个对象的ID掩码及其对应的2D图像坐标和3D模型坐标,然后利用配准算法如PnP(投影-射影)和RANSAC(随机采样一致性)来计算6D姿态。

该方法的独特之处在于,它不仅依赖真实的训练数据,还结合了合成渲染的数据,这使得DPOD能够在各种场景下保持良好的性能。与只专注于真实数据训练的其他深度学习方法不同,DPOD的泛化能力更强,能够在实际应用中展现出实时的处理速度,尽管在精度方面表现出色。

图1展示了DPOD的工作流程,它能够从单个RGB图像中准确地识别出物体,生成对应的ID掩码和2D-3D对应关系,进而得到精确的6D姿态估计。结果显示,绿色的地面实况边界框与蓝色的估计边界框高度重合,表明了该方法在姿态估计上的准确性。

近年来,随着深度学习技术的发展,像SSD6D、YOLO6D、AAE、PoseCNN和PVNet这样的方法已经在6D姿态估计领域取得了显著进展。然而,DPOD的独特融合策略使其在处理RGB图像的复杂性方面脱颖而出,证明了密集对应关系和深度学习细化方案对于提高6D姿态估计的精度和鲁棒性的重要性。

DPOD的研究旨在填补RGB图像中3D姿态估计的空白,提供了一种高效且准确的解决方案,对提升许多应用中的用户体验和系统性能具有重要意义。未来的研究方向可能包括进一步优化网络结构、提高模型的训练效率,以及探索更广泛的场景和对象类别适应性。

相关推荐

13 浏览量

cpongm

- 粉丝: 6

最新资源

- 支付宝订单监控免签工具:实时监控与信息通知

- 一键永久删除QQ空间说说的绿色软件

- Appleseeds训练营第4周JavaScript练习

- 免费HTML转CHM工具:将网页文档化简成章

- 奇热剧集站SEO优化模板下载

- Python xlrd库:实用指南与Excel文件读取

- Genegraph:通过GraphQL API使用Apache Jena展示RDF基因数据

- CRRedist2008与CRRedist2005压缩包文件对比分析

- SDB交流伺服驱动系统选型指南与性能解析

- Android平台简易PDF阅读器的实现与应用

- Mybatis实现数据库物理分页的插件源码解析

- Docker Swarm实例解析与操作指南

- iOS平台GTMBase64文件的使用及解密

- 实现jQuery自定义右键菜单的代码示例

- PDF处理必备:掌握pdfbox与fontbox jar包

- Java推箱子游戏完整源代码分享