StyleT2I:提升文本到图像合成的组合性和保真度

23 浏览量

更新于2025-01-16

收藏 1.65MB PDF 举报

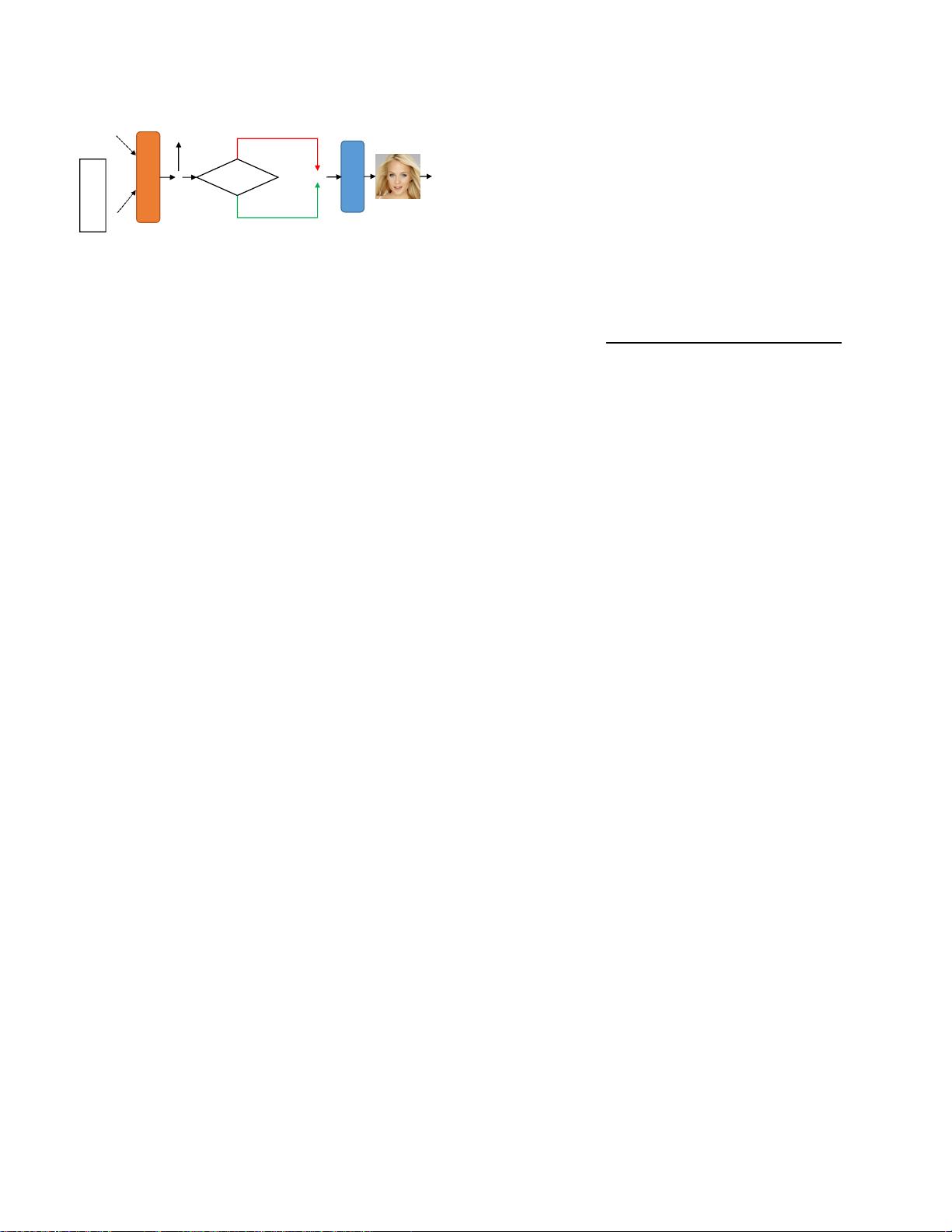

"这篇论文介绍了StyleT2I,一个创新的框架,旨在提升文本到图像合成的组合性和保真度。研究主要针对当前方法在处理未见过或代表性不足的属性组合时的局限性,比如在合成代表性不足的人群群体面部图像时的困难。StyleT2I通过引入CLIP引导的对比损失、语义匹配损失和空间约束等技术,提高了模型的组合属性识别和图像合成能力。此外,它还采用2-范数正则化来平衡图像-文本对齐和图像保真度。在实验部分,作者创建了新的数据集分割和评价指标来评估模型的组合性,并展示了StyleT2I在一致性与保真度方面的优越性能。"

文本到图像合成是一个具有广泛应用前景的技术,包括艺术创作、计算机辅助设计以及训练数据增强等。然而,现有的方法往往存在一个问题,即对于那些在训练数据中不常见或者未曾出现过的属性组合,它们可能无法准确合成,这可能源于模型对过度代表的属性的过拟合,导致生成的图像质量和属性准确性下降。例如,如果输入文本描述的是一个少见的性别属性组合,如"他戴着口红",传统的文本到图像合成方法可能会出错,生成的图像不符合预期。

StyleT2I框架的提出,是为了解决这个问题。它采用了CLIP(Contrastive Language-Image Pre-training)引导的对比损失,使得模型能够更准确地区分不同文本句子中的属性成分。同时,通过设计新的语义匹配损失,可以识别并定位属性的潜在方向,进而进行组合属性调整,优化图像的合成过程。2-范数正则化的应用,旨在防止模型过于依赖某一特定属性,以达到在保持图像-文本对齐的同时,提升合成图像的保真度。

在实验阶段,研究者专门设计了数据集的分割策略,以及新的评价标准,以评估模型在处理组合属性时的能力。实验结果显示,StyleT2I在输入文本和合成图像的一致性上超越了现有的方法,并且在生成高保真图像方面也表现出色。这一突破性的进展不仅提升了文本到图像合成的质量,也为未来的公平性和多样性增强的图像生成研究奠定了基础。

cpongm

- 粉丝: 6

最新资源

- Saber仿真下的简化Buck环路分析与TDsa扫频

- Spring框架下使用FreeMarker发邮件实例解析

- Cocos2d捕鱼达人路线编辑器开发指南

- 深入解析CSS Flex布局与特性的应用

- 小学生加减法题库自动生成软件介绍

- JS颜色选择器示例:跨浏览器兼容性

- ios-fingerprinter:自动化匹配iOS配置文件与.p12证书

- 掌握移动Web前端高效开发技术要点

- 解决VS中OpenGL程序缺失GL/glut.h文件问题

- 快速掌握POI技术,轻松编辑Excel文件

- 实用ASCII码转换工具:轻松实现数制转换与查询

- Oracle ODBC补丁解决数据源配置问题

- C#集成连接器的开发与应用

- 电子书制作教程:你的文档整理助手

- OpenStack计费监控:使用collectd插件收集统计信息

- 深入理解SQL Server 2008 Reporting Services