手持设备上的快速近场光度立体重建技术

PDF格式 | 20.39MB |

更新于2025-01-16

| 11 浏览量 | 举报

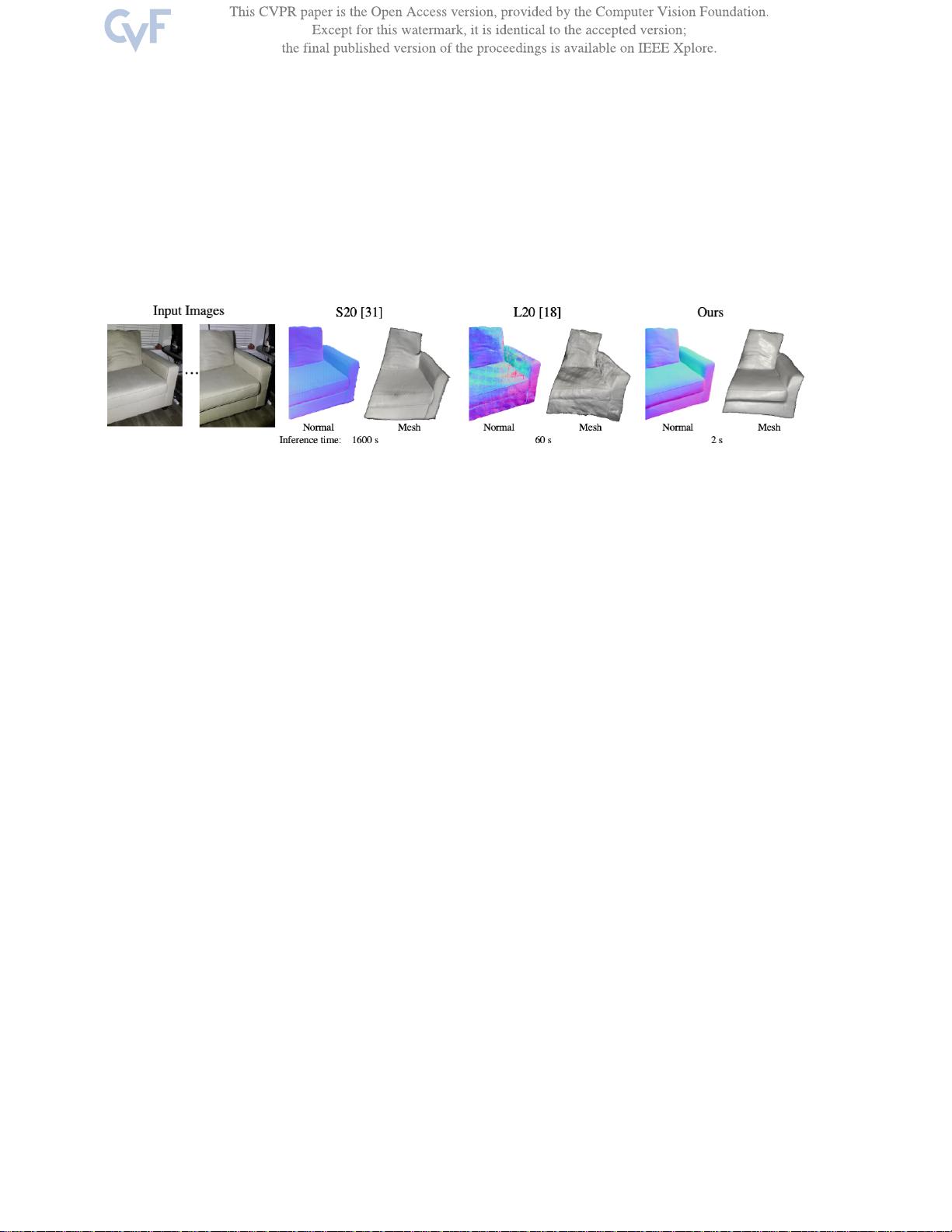

"快速轻量级近场光度立体技术是一种创新的3D物体重建方法,专为在小空间内捕捉大型物体设计。该技术利用iPhone相机和手持手电筒作为光源,通过端到端的学习算法实现高效、精确的重建效果。与传统方法相比,它在推理过程中速度显著提升,能在一秒内在普通GPU上处理高分辨率图像,生成网格,并且对噪声和校准误差具有更好的鲁棒性。

现有的近场光度立体技术依赖于优化过程,这导致计算速度慢且内存需求大。相反,新方法采用递归多分辨率策略,一次性估计整个图像的表面法线和深度图,极大地减少了计算时间和内存消耗。这种方法提高了45倍的速度,同时降低了平均角度误差,从13.3°改进至11.3°,从而提供更准确的重建结果。

该技术的一大亮点是其轻量化特性,允许用户在笔记本电脑上快速处理图像,便于多次重拍,这对于AR/VR应用尤其有价值。此外,尽管最初设计用于校准照明环境,但通过引入校准网络,该方法也能适应非校准的真实世界捕捉场景。

近场光度立体技术相较于远场技术在捕捉大型物体如家具时更具优势,因为它可以更有效地处理近距离照明条件,适合在有限的空间内进行高质量的3D重建。通过这种技术,用户能够在短时间内完成大型物体的精确数字化,为设计、制造、虚拟现实等领域带来便利。"

相关推荐

cpongm

- 粉丝: 6

最新资源

- 普天身份证阅读器新版二次开发包发布

- C# 实现文件的数据库保存与导出操作

- CkEditor增强功能:轻松实现图片上传

- 掌握DLL注入技术:测试工具使用与探索

- 实现带节假日农历功能的jQuery日历选择器

- Spring循环依赖示例:深入理解与Git代码仓库实践

- ABB PLC液压阀门控制程序开发指南

- 揭秘4核旋风密版626象棋引擎的超牛实力

- HTML5实现的经典游戏:小霸王坦克大战源码分享

- 让Visual Studio兼容APM硬件信息的方法

- Kotlin入门:创建我的第一个应用

- Android语音识别技术研究报告与应用分析

- 掌握JavaScript基础:第8版教程源代码解析

- jQuery制作动态侧面浮动图片广告特效教程

- Android PinView仿支付宝密码输入框源码分析

- HTML5 Canvas制作的围住神经猫游戏源码分享