实时三维手形网格重建:精确对齐的新方法

7 浏览量

更新于2025-01-16

收藏 1.42MB PDF 举报

三维手形网格实时重建中的精确对齐方法是一项重要的研究课题,尤其在增强现实(AR)领域有着广泛的应用潜力。本文由香港中文大学副校长等人合作提出,他们关注的是如何在满足实时性、准确的手部姿势和形状捕捉以及精细的网格图像对齐这三个关键需求上取得突破。

当前,三维手部网格重建主要依赖于两种输入类型:RGB图像或深度数据。深度学习方法已经成为主流,例如通过深度神经网络预测手部关节坐标,以指导手部网格顶点的位置或驱动手部模型参数,如MANO模型。然而,这些方法往往难以同时实现高精度的手部姿势和形状重建,以及流畅的网格对齐,特别是在实时环境下。

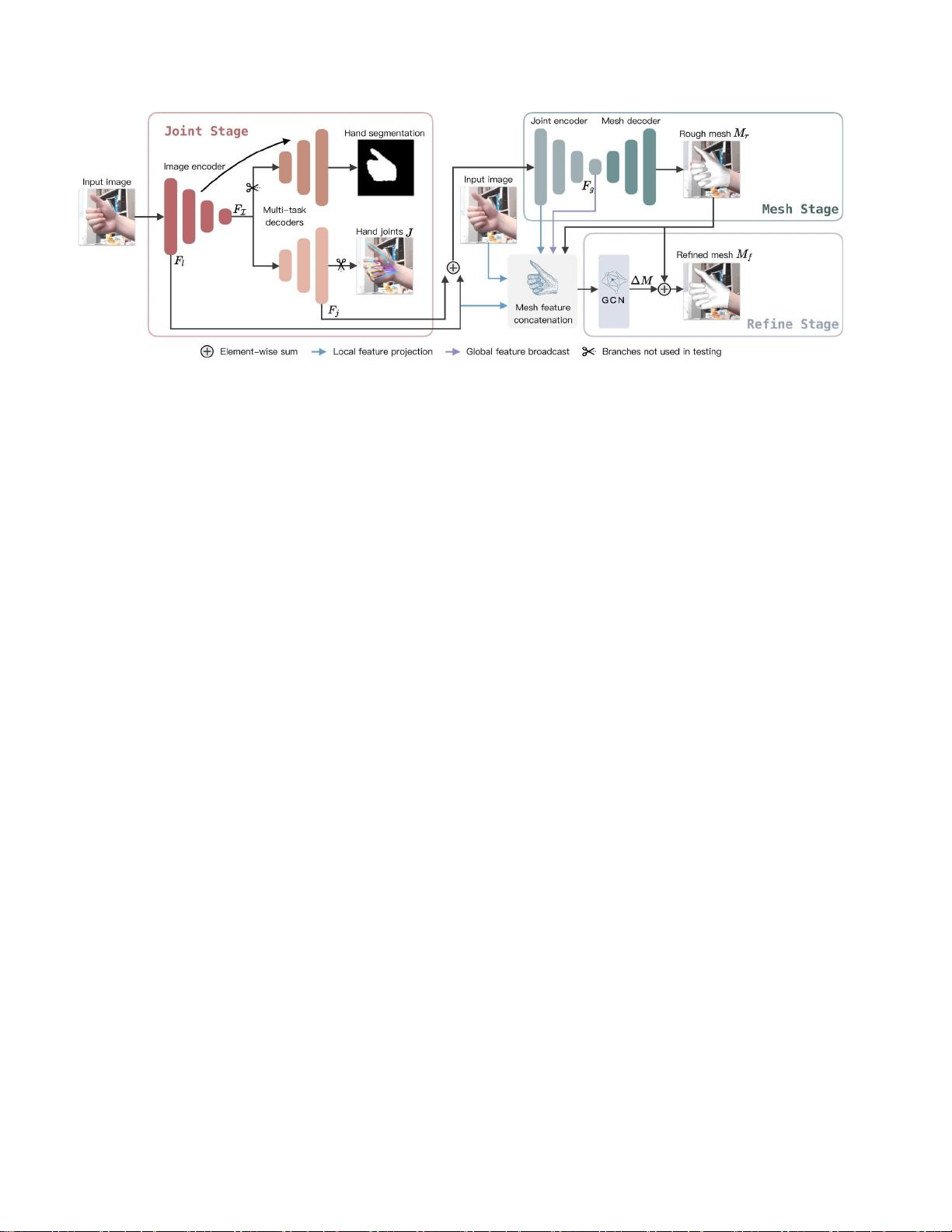

本文的核心贡献在于设计了一个新的流水线架构,将手部网格重建过程分解为三个阶段:关节预测与分割、粗网格生成和精细化网格对齐。首先,通过关节阶段精确捕捉手部关节位置并进行分割;接着,网格阶段生成基础手部网格;最后,通过微调级细化网格对齐,确保在交互式反馈中对手指级细节的准确匹配。精心设计的网络结构和定制的损失函数有助于提升模型性能,使得模型能够在实时环境中提供高质量的预测。

实验结果在多个基准数据集上展示出显著优势,不仅在手部网格和姿态的精度上超越了现有最先进的方法,而且在手图像对齐方面也表现出更高的自然度和真实感。文章通过对比I2L-MeshNet等先前工作,如图1所示,清晰地展示了作者方法在AR交互中的优越性,例如对手指级对齐和手部遮挡的处理能力。

这项研究对于推动计算机视觉技术在AR领域的实际应用具有重要意义,为实现更加自然、流畅的人机交互体验奠定了坚实的基础。通过实时、精确的手部网格重建,该方法有望在游戏、教育、医疗等多个领域开启新的可能性。

571 浏览量

2021-09-18 上传

1250 浏览量

2018-11-26 上传

点击了解资源详情

点击了解资源详情

848 浏览量

cpongm

- 粉丝: 6

最新资源

- 小学水墨风学校网站模板设计

- 深入理解线程池的实现原理与应用

- MSP430编程代码集锦:实用例程源码分享

- 绿色大图幻灯商务响应式企业网站开发源码包

- 深入理解CSS与Web标准的专业解决方案

- Qt/C++集成Google拼音输入法演示Demo

- Apache Hive 0.13.1 版本安装包详解

- 百度地图范围标注技术及应用

- 打造个性化的Windows 8锁屏体验

- Atlantis移动应用开发深度解析

- ASP.NET实验教程:源代码详细解析与实践

- 2012年工业观察杂志完整版

- 全国综合缴费营业厅系统11.5:一站式缴费与运营管理解决方案

- JAVA原生实现HTTP请求的简易指南

- 便携PDF浏览器:随时随地快速查看文档

- VTF格式图片编辑工具:深入起源引擎贴图修改