深度神经网络易受普遍扰动攻击:图像误分类风险

PDF格式 | 1.19MB |

更新于2025-01-16

| 186 浏览量 | 举报

本文主要探讨了深度神经网络分类器在面对普遍扰动时的脆弱性。"泛对抗扰动"这一概念被引入,指的是对于任何给定的最先进的深度学习模型,存在一种小型且图像不可知的扰动,能够在自然图像上以很高的概率诱导分类错误。研究者发现,即使这种扰动极其微小,几乎难以被人眼察觉,却能够显著影响深度神经网络的判断。

作者们开发了一种系统算法来计算这些普遍扰动,结果显示,即使是高度复杂的深度神经网络,也容易受到这类攻击。实验数据显示,它们揭示了分类器在高维决策边界之间的几何关联性,这暗示着潜在的安全威胁。攻击者只需在输入图像的方向上施加这种扰动,就可能破坏大量自然图像的分类结果,这是一种潜在的输入空间攻击向量。

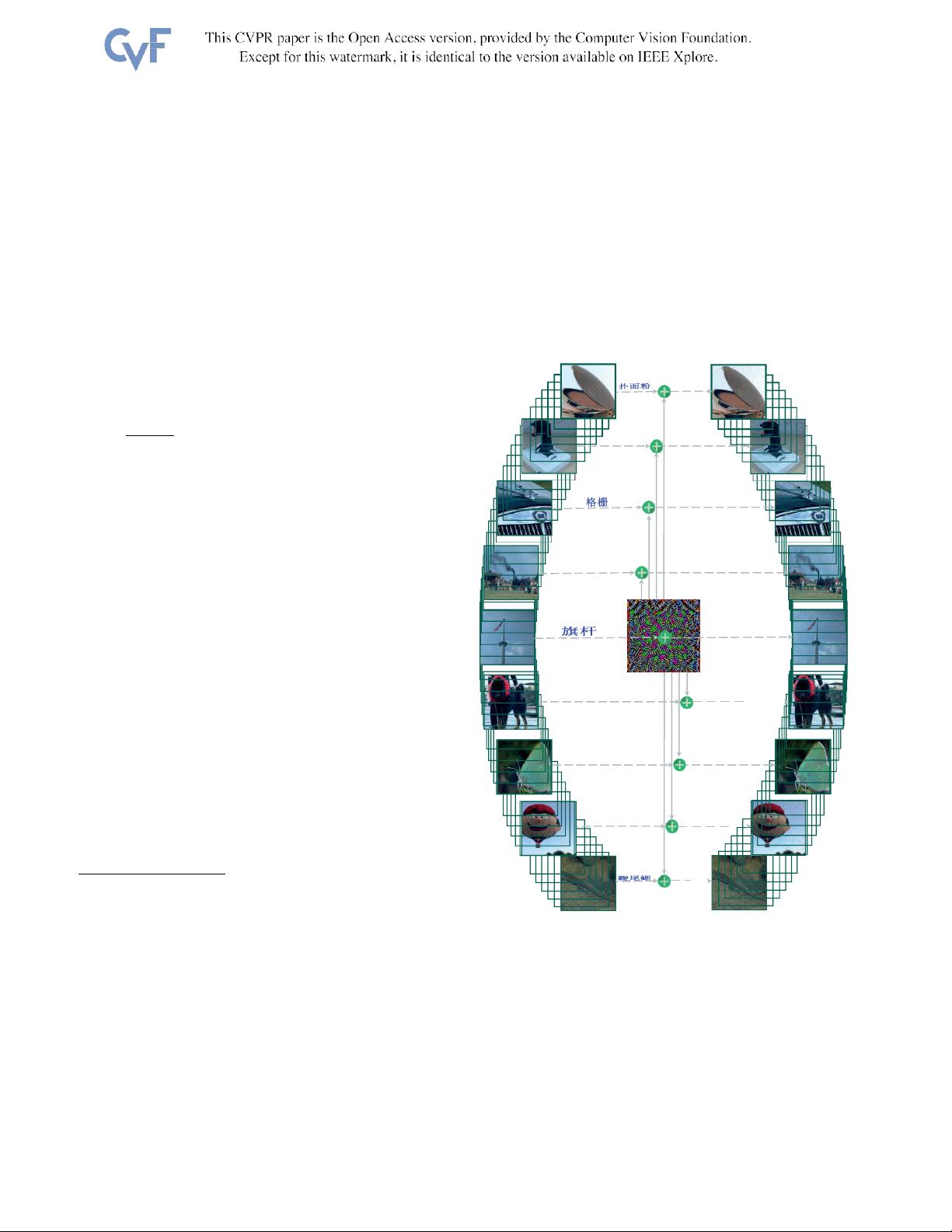

文章通过具体示例(如图1所示)生动地展示了这个现象:一个微小的普遍扰动图像能够改变深度神经网络对原始图像的预测标签,哪怕是在视觉上几乎察觉不到的变化。这种情况在深度学习模型应用于实际、可能带有恶意的环境中显得尤为关键,因为它预示着模型可能面临现实世界的潜在安全漏洞。

作者们强调,这种普遍扰动的存在提醒我们,深度学习模型在面对未知的输入时可能存在漏洞,需要在设计和部署时充分考虑安全性。他们提供的代码和演示视频提供了深入研究和防御这类攻击的实用资源。这篇论文引发了关于深度学习模型鲁棒性与安全性的深入讨论,对防范此类攻击具有重要的理论和实践意义。

相关推荐

cpongm

- 粉丝: 6

最新资源

- WebDrive v16.00.4368: 简易易用的Windows风格FTP工具

- FirexKit:Python的FireX库组件

- Labview登录界面设计与主界面跳转实现指南

- ASP.NET JS引用管理器:解决重复问题

- HTML5 canvas绘图技术源代码下载

- 昆仑通态嵌入版ASD操舵仪软件应用解析

- JavaScript实现最小公倍数和最大公约数算法

- C++中实现XML操作类的方法与应用

- 设计编程工具集:材料重量快速计算指南

- Fancybox:Jquery图片轮播幻灯弹窗插件推荐

- Splunk Fitbit:全方位分析您的活动与睡眠数据

- Emoji表情编码资源及数据库查询实现

- JavaScript实现图片编辑:截取、旋转、缩放功能详解

- QNMS系统架构与应用实践

- 微软高薪面试题解析:通向世界500强的挑战

- 绿色全屏大气园林设计企业整站源码与多技术项目资源