信赖域优化:提升神经网络对抗攻击效率

PDF格式 | 979KB |

更新于2025-01-16

| 141 浏览量 | 举报

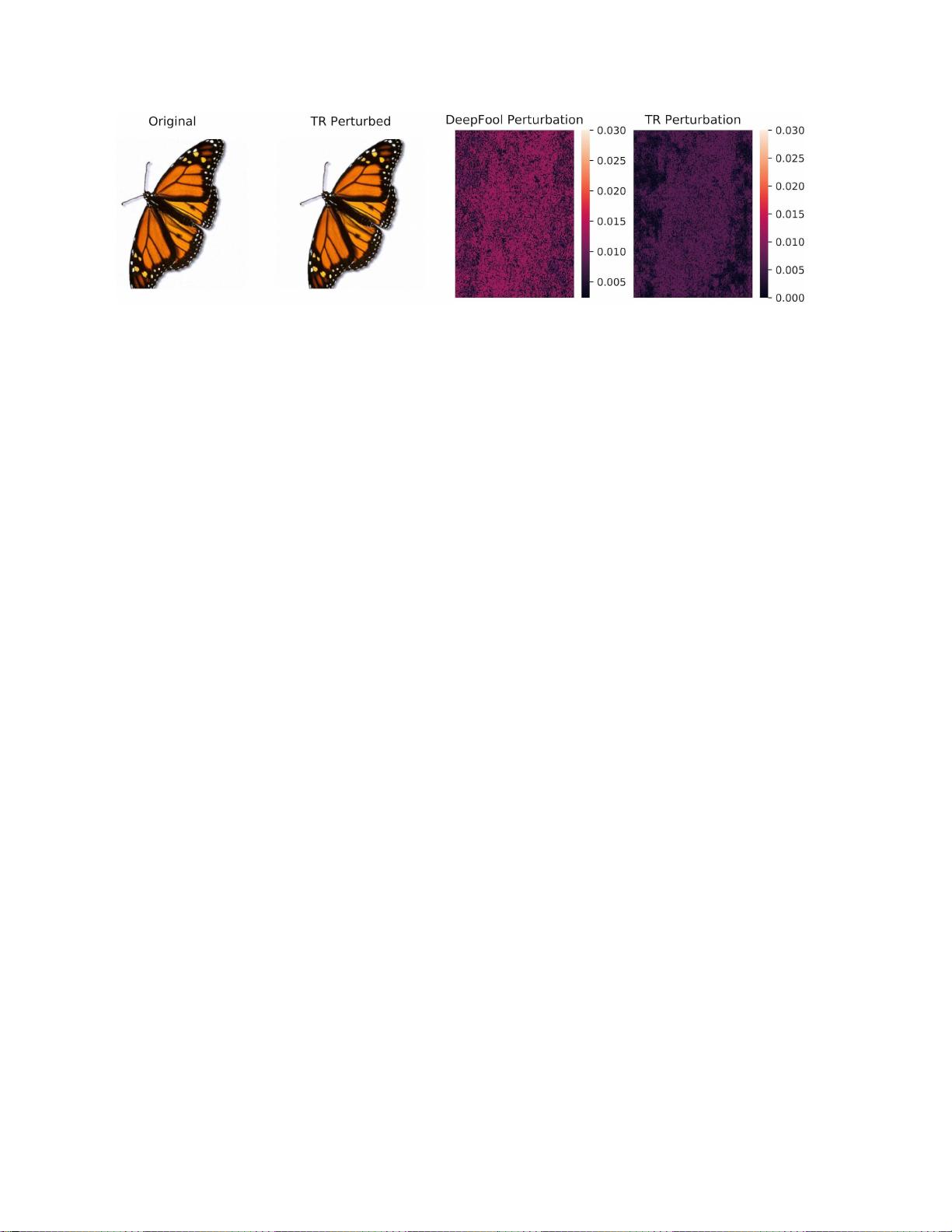

本文主要探讨了基于信赖域的神经网络对抗攻击(Trust Region Adversarial Attack, TRA)在深度学习领域的应用。作者姚哲伟等人针对深度神经网络(DNN)容易受到对抗性扰动的问题,提出了一个旨在高效计算对抗性扰动的新方法。传统的对抗性攻击如DeepFool、Carlini-Wagner(CW)攻击往往需要耗费大量时间和超参数调整,或者通过多步骤优化过程实现。

TRA的关键在于采用信赖域优化技术的变体,这是一种约束优化策略,能够在有限的搜索区域内寻找最优解,从而避免了全局搜索的复杂性和计算成本。这种方法的优势体现在:

1. **效率提升**:相比于CW攻击,TRA在保持类似攻击效果的同时,显著提高了计算速度。例如,在VGG-16模型上,对于TitanXp GPU,TRA能够将速度提升37倍,使得对抗性攻击变得更加实时。

2. **结果质量**:在Cifar-10和ImageNet数据集上,使用不同模型(如AlexNet、ResNet-50、VGG-16和DenseNet-121)进行实验,TRA能够在较小的L∞或L2扰动范围内(如将ImageNet上ResNet-50的分类准确率降低到0.1%或1.5%),快速地实现攻击目标。

3. **适用性广泛**:文章展示了TRA的通用性,不仅适用于经典模型如AlexNet,也适用于更深的模型如ResNet-50,且对大规模ImageNet数据集表现出良好的性能。

4. **对抗性训练的价值**:尽管文章的重点是攻击,但作者也提及了利用攻击方法作为对抗性训练的一种手段,这反映了研究者对提高模型鲁棒性的探索。

基于信赖域的神经网络对抗攻击方法提供了一个有效的途径,既能增强攻击的针对性,又能提高攻击的执行效率,这对于理解DNN的脆弱性以及开发更安全的模型具有重要意义。同时,该方法的开源发布也促进了学术界对该问题的进一步研究和实践应用。

相关推荐

cpongm

- 粉丝: 6

最新资源

- MATLAB实现ART与SART算法在医学CT重建中的应用

- S2SH整合版:快速搭建Struts2+Spring+Hibernate开发环境

- 托奇卡项目团队成员介绍

- 提升外链发布效率的SEO推广神器——搜易达网络推广大师v2.035

- C#打造简易记事本应用详细教程

- 探索虚拟现实地图VR的奥秘

- iOS模拟器屏幕截图新工具

- 深入解析JavaScript在生活应用开发中的运用

- STM32F10x函数库3.5中文版详解与应用

- 猎豹浏览器v6.0.114.13396 r1:安全防护与网购敢赔

- 掌握JS for循环输出的最简洁代码技巧

- Java入门教程:TranslationFileGenerator快速指南

- OpenDDS3.9源码解析及最新文档指南

- JavaScript提示框插件:鼠标滑过显示文章摘要

- MaskRCNN气球数据集:优质图像识别资源

- Laravel日志查看器:实现Apache多站点日志统一管理