1.

介绍

近年来,在能源危机和低碳要求的双重压力下,传统化石燃料汽车

产业面临着严峻的形势。氢能因其环境友好、储量大、生产途径多样等

特点,越来越受到各国的重视。因此 ,燃料电池混合动力电动汽车

(FCHEV)由于其环境友好性和具有竞争力的车辆性能而吸引了越来越

多的 关 注 [1]。在 混 合 动力 电 动 汽车的控 制框架中, 能量管理 策 略

(EMS)是通过调节不同能源之间的功率分配来使整个动力系统更有效

地工作的关键因素。

EMS方法通常可以分为三类:基于规则的方法、基于最优控制的方法

和基于学习的方法。基于规则的EMS是根据系统的特点建立规则。在不

同的基于规则的EMS方法中,基于模糊逻辑规则的EMS由于其实际有效

性而最具吸引力[2]。然而,EMS规则的设计在大多数情况下高度依赖于

专家经验[3]。

能量管理问题可以看作是一个有约束的水平序列优化问题[4]。在

各种求解方法中,基于EMS的动态规划(DP)可以提供数值全局最

优解[5]。然而,在实施基于DP的EMS之前,必须知道车辆的操作条

件和模型随机动态规划(SDP)[6],庞特里亚金使用这些方法,准最

优解可以通过实时实现。然而,需要精确的系统模型和未来驾驶条件

的信息来实现高性能[9,10]。

强化学习(RL)作为一种机器学习,在EMS开发中越来越受到关注

[11]。 当应用RL时,约束序列决策优化问题的解可以通过与环境交互来

逐步学习,而不依赖于系统模型和驾驶条件的先验知识。基于RL的方法

具有适应环境变化的潜力,如能源的模型退化、车辆行驶条件或驾驶员

行为的变化等。Q-Learning作为一种基本的基于值的强化学习方法,已

经在各种混合动力汽车中提出,以解决能源管理问题[12,13]。基于Q-

Learning的方法的主要缺点是它只适用于离散的动作空间和状态空间,

而EMS需要在连续的动作和状态空间中实现

针对强化学习中的连续空间问题,给出了其求解方法。

通常涉及一个功能评估,以评估价值功能或/和策略功能。所使用的近

似函数可以是线性的或非线性的。通过对提取的状态特征进行线性组

合,实现了线性函数 例如,多项式、傅立叶基、Corse编码和瓦片编码

是提取状态特征的常用函数[14,15]。

神经网络、高斯函数等非线性函数逼近器一般具有更好的泛化能

力,适应更多场景。在[16]中提出了一种基于高斯的RL非线性函数逼

近,解决了线性函数逼近的信息损失问题。深度神经网络已被广泛应用

为强化学习的函数逼近方法。大量的深度强化学习(DRL)算法已经被

迅速开发和研究[17]。对于EMS问题,已经提出了DRL,如深度Q网络

(DQN)[18]和深度确定性策略梯度(DDPG)[19],并取得了有趣的结

果[20]。然而,基于深度神经网络的非线性函数逼近存在计算复杂度

高、超参数调整困难等缺点,阻碍了其实际应用[21]。

模糊推理系统(FIS)是在模糊集合上定义输入、输出和状态变量的

系统。它抓住了人脑思维的模糊性,可以模仿人的综合推理来处理常规

数学方法难以解决的问题[22]。与神经网络相似,FIS也具有良好的泛化

能力和函数逼近能力。FIS函数近似器在强化学习中的第一个应用是模糊

Q学习(FQL),其中使用FIS引擎来近似状态-动作值函数[23]。在能源

管理中,FQL被应用于解决能源管理的最优化问题[24,25],以减少能

源损失,提高效率和经济性。在我们以前的工作中,也提出了一种基于

EML的燃料电池混合动力汽车EMS,

[26]以延长燃料电池的寿命即使计算量很低

虽然在这项工作中已经证明了这一要求的合理性,但Q-Learning的固有

缺点,例如值高估和大的训练方差,并没有得到很好的解决。

为了克服FQL的缺点,FIS也可以用作策略函数逼近器以形成模糊策

略梯度(FPG),并且在策略梯度学习范例中通常可以实现更快和更平

滑的收敛[27]。蒙特卡罗策略梯度(Monte-Carlo Policy Gradient,简称

REINFORCE)是一种策略梯度RL方法,可用于求解连续状态离散动作空

间。同时,在学习过程中,智能体可以探索动作空间,并通过在目标动

作附近进行小扰动来避免陷入局部最优[28]。

本文提出了一种基于模糊REINFORCE的混合动力电动汽车EMS方

法,该方法将FIS应用于蒙特卡洛策略梯度中的策略函数估计。此

外,为了抑制REINTRONIC的训练方差,本文还使用了模糊基线函数

[29]。由于所提出的方法的无模型特性,EMS控制器不需要精确的系

统模型。最优控制可以通过与环境的相互作用来实现。此外,学习模

糊REINFORCE基于EMS也表现出令人满意的鲁棒性未知的外部输入

和不同的系统状态。因此,本文的主要贡献如下:

1)

模糊REINFORCE,作为一个无模型学习的EMS,最初提出来解决

FCHEV的能量管理问题

2)

提出了模糊基线函数来抑制模糊再训练算法的训练方差;

3)

所提出的方法的适应性的驾驶条件和系统状态的变化是合理的。

4)

建议的模糊REINFORMATION已成功地实现在单片机和实时,这证明

了它的低计算要求。

第二部分介绍了混合动力电动汽车能量系统的建模,包括燃料电

池、蓄电池和整车动力学模型。第3节描述了所提出的基于模糊增强的

能量管理策略的原理。第4节给出了仿真和硬件在环实验结果的分析。

论文最后在第五中结束。

2.

燃料电池混合动力汽车能量系统

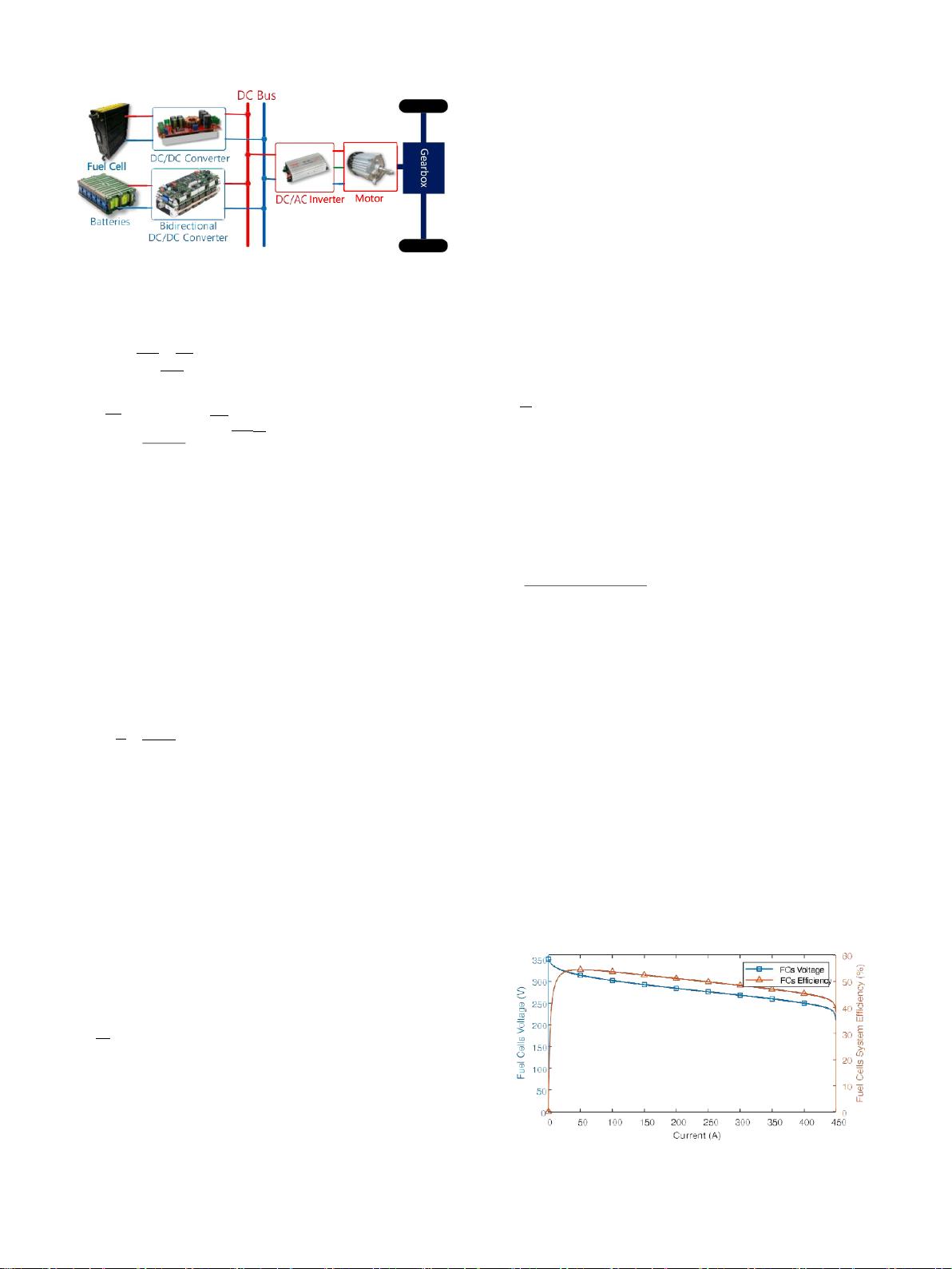

FCHEV的研究能量系统如图1所示。其动力源由燃料电池(FC)系统

和蓄电池系统组成。由于FC的动态响应慢,电池主要用于吸收多余的功

率并提供瞬时大功率输出。它们都通过DC/DC变换器共享直流母线,用

于提供负载所需的功率或吸收负载能量。

本文将对各部分的具体模型进行分析

2.1.

燃料电池模型

质子交换膜燃料电池(PEMFC)是一种低温