Baoping Liu

1

, Bo Liu

1

, Ming Ding

2

, Tianqing Zhu

1

, Xin Yu

1

1

University of Technology Sydney, NSW, Australia

2

Data61, CSIRO, Sydney, NSW, Australia

baoping.liu@student.uts.edu.au, ming.ding@data61.csiro.au

{Bo.liu, Tianqing.Zhu, Xin.Yu}@uts.edu.au

4691

0

TI2Net:时态身份不一致网络用于Deepfake检测

0

摘要

0

在本文中,我们提出了一种名为TI2

Net的时态身份不一致网络(TemporalIdentity

Inconsistency

Network),它专注于时态身份不一致性的Deepfake检测

。具体而言,TI2

Net通过捕捉同一身份的视频帧之间的人脸差异来识别伪造

视频。因此,TI2

Net是一种无参考检测器,可以用于未知数据集。对于给定

身份的视频剪辑,所有帧中的身份信息首先被编码为身份向

量。TI2

Net通过身份向量的时态差异来学习时态身份嵌入。时态嵌

入表示视频剪辑中的身份不一致性,最终用于确定视频剪辑

的真实性。在训练过程中,TI2

Net采用三元损失来学习更具辨别力的时态嵌入。我们进行

了全面的实验来评估所提出的TI2

Net的性能。实验结果表明,TI2

Net对未知操作和具有未知身份的数据集具有很好的泛化能

力。此外,TI2

Net还对压缩和添加噪声表现出稳健的性能。

0

1.引言

0

近年来,深度神经网络(DNNs),尤其是生成神经网络(

GANs)的发展,使得Deepfake能够生成逼真的图像和视频

并迷惑公众。因此,Deepfake检测已成为一项紧迫的任务

,以保护人们免受Deepfake造成的误导。现有的Deepfake

检测器可以分为图像级(帧级)检测器和视频级检测器。图

像级检测器依赖于空间特征,如纹理不一致性

[26],[5]和颜色失真

[12],[11]。一些检测器还将空间信息转换到频域,并捕捉

频域中的痕迹

[8],[9],[14]。此外,借助强大的DNNs,许多检测器分析

潜在特征中的痕迹。

0

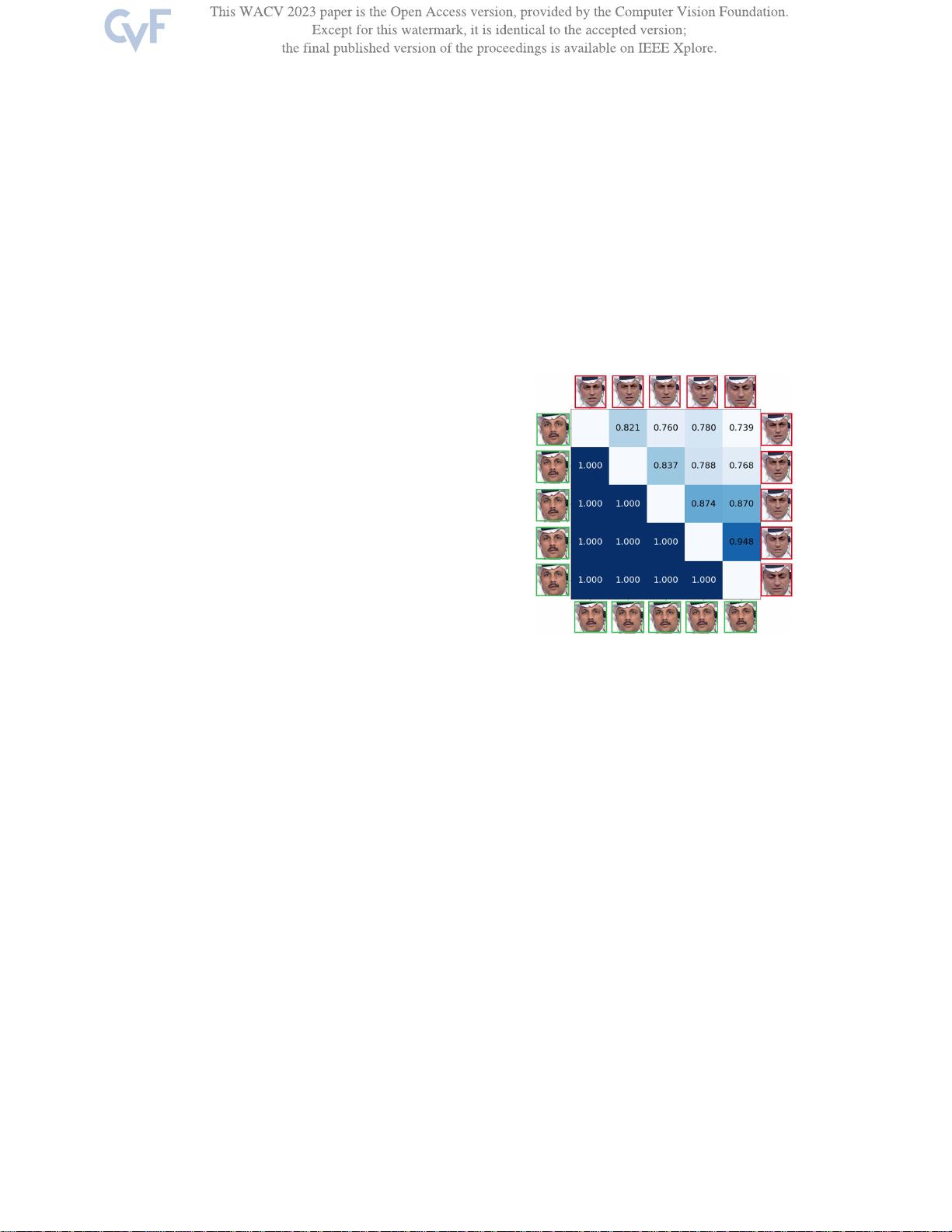

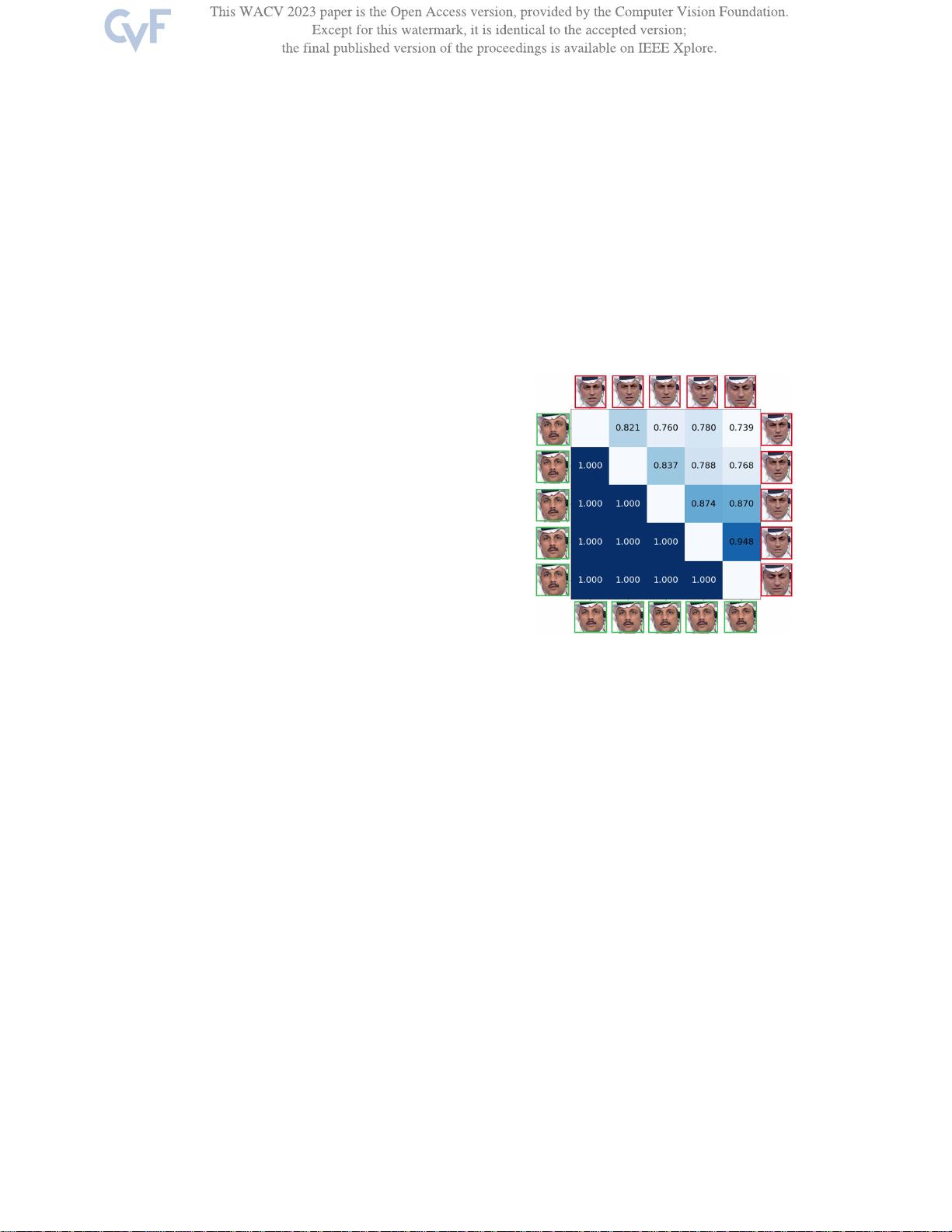

图1:真实视频帧(下三角)和伪造视频帧(上三角)之间

的成对身份相似性。下三角中的每个值表示行左侧的面孔与

列底部的面孔之间的相似性(在绿色框中)。上三角中的每

个值表示行右侧的面孔与列顶部的面孔之间的相似性(在红

色框中)。对角线表示自相似性,留空。

0

用于识别伪造图像的空间特征

[23],[25],[24]。尤其是,由于人脸交换操作会混合不同

身份的面孔,最近发现身份不一致的痕迹对于伪造检测是一

个有效的线索。例如,Dong等人[5]

[6]检测到内部面部区域和外部面部区域之间的空间身份不一

致。尽管这种基于身份的检测器可以用于逐帧检测视频,但

它们在伪造视频上表现不佳,因为它们没有考虑到更直观和

重要的时态不一致性,这是检测Deepfake视频的重要痕迹

。为了检测伪造视频,一些检测器利用了时态痕迹,如帧间

变化[7],时态频率痕迹[15]和一般不一致性。